-

질문 & 답변

카테고리

-

세부 분야

데이터 엔지니어링

-

해결 여부

해결됨

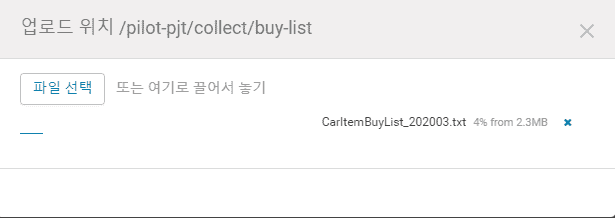

hue에서 파일 업로드가 정상적으로 되지 않습니다.

22.01.12 17:30 작성 조회수 307

0

.

.답변을 작성해보세요.

0

고니

질문자2022.01.13

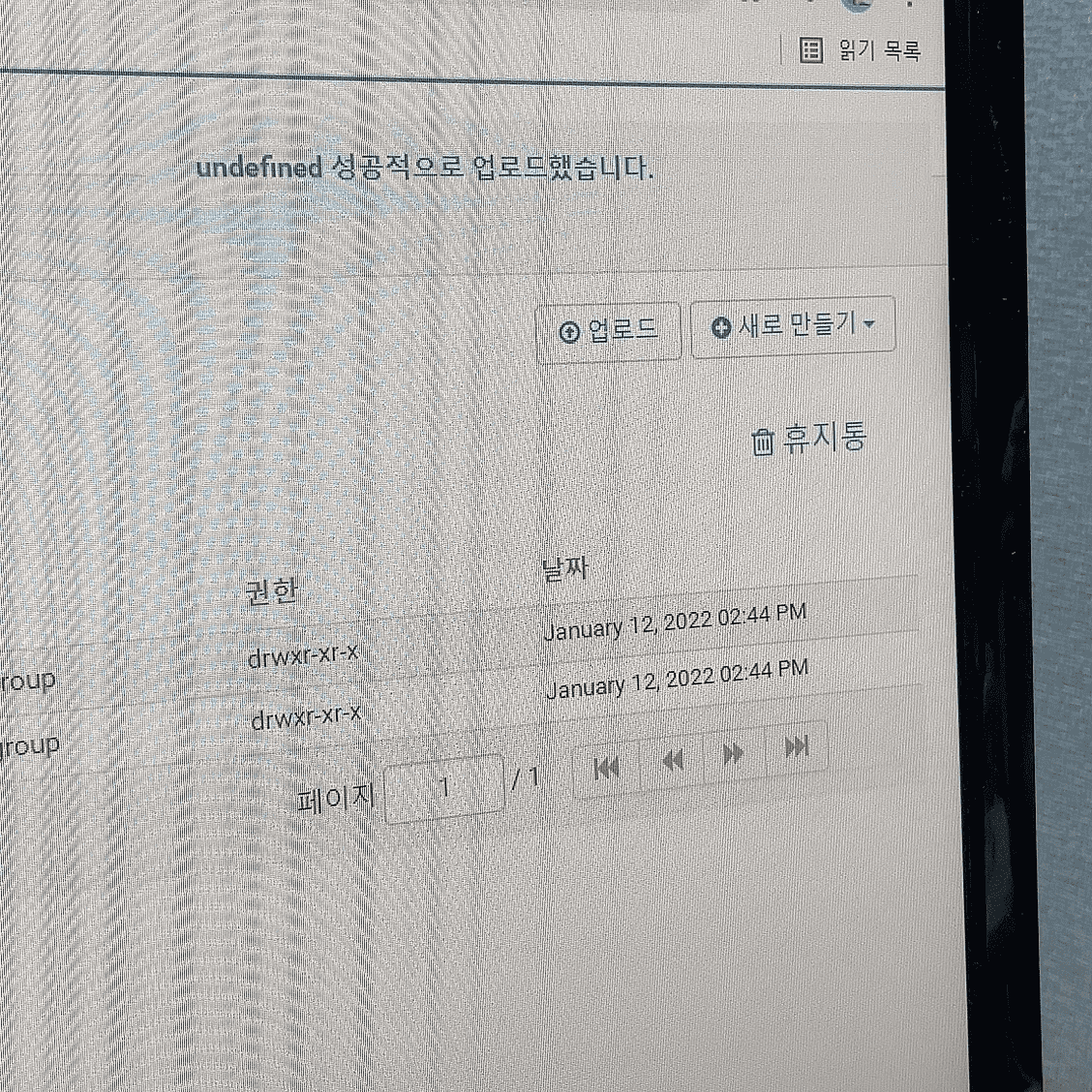

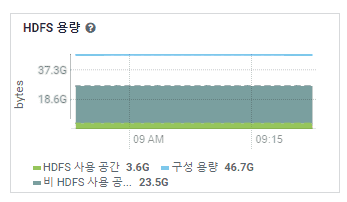

내용을 삭제해서 용량을 10kb정도로 줄이니까 업로드가 됩니다.

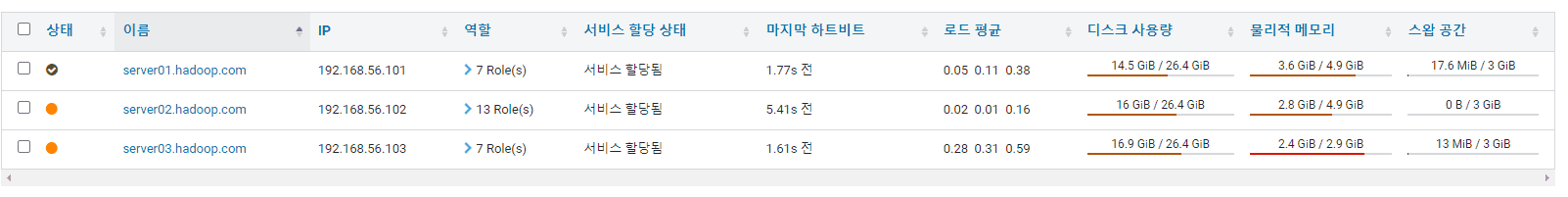

HDFS용량은 그래도 여유가 있는것 같고

Big.D

지식공유자2022.01.13

네~ HDFS의 퍼미션 or 여유공간 문제는 아닌것 같습니다.

실습PC 환경의 특성(브라우져/보안/백신 프로그램 등)을 타는것 같기도 한데요..

일반적으로 파일을 PC에서 서버로 업로드 될땐 파일이 쪼개져서 올라가는데, 큰파일의 경우 브라우져(Chrome)와 WebHDFS 간의 세션 연결 시간이 길어지면서 통신에 문제가 발생 하는것으로 보입니다.

우선 아래 HDFS 명령으로 해당 파일(사이즈 유지)을 직접 업로드해서 실습을 진행해봐 주세요~

1. CarItemBuyList_202003.txt 파일을 파일질라를 통해 Server02의 /home/pilot-pjt에 업로드

2. putty로 Server02에 접속해 아래 명령으로 해당 파일을 HDFS에 직접 업로드

$ hdfs dfs -put /home/pilot-pjt/CarItemBuyList_202003.txt /pilot-pjt/collect/buy-list

추가로 아래 점검 명령을통해 HDFS에 문제 (“CORRUPT FILES”, “MISSING BLOCKS”, “MISSING SIZE”, “CORRUPT BLOCKS”)가 있는지, Safe 모드 인지등을 체크해 봐 주시고요..

$ hdfs fsck /

$ hdfs dfsadmin -report

참고로 로그는 HDFS에 업로드중 문제가 발생 했기 때문에 아래의 위치에 있는 네임노드 및 데이터노드의 로그를 확인해 보시면 됩니다.

/var/log/hadoop-hdfs

- 빅디 드림

0

고니

질문자2022.01.13

새로운 디렉토리에 올려봤는데도 마찬가지입니다,,car-master에는 CarMaster.txt가 정상적으로 올라와 있는데 이 경로에서도 똑같은 알림이 뜨면서 올라가지 않습니다.

답변 2