박사 졸업 후 5년 정도 Computer vision를 공부하고 가르치는 계기가 돼서

지금까지 수학전공과 공학이론을 연결한 공부들을 하고 있습니다.

전문분야(공부 분야)

전공: 수학(Topological Geometry), 부전공(컴퓨터 공학)

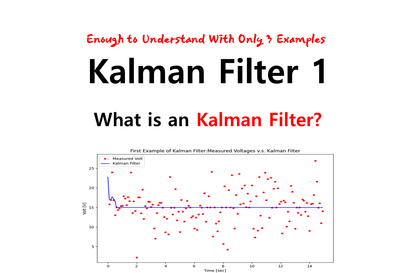

현) 3D Computer Vision(3D Reconstruction) , Kalman Filter, Lie-group(SO(3)),

Stochastic Differential Equation 연구자

현) 유튜브 채널 운영: 임장환: 3D Computer Vision

현) facebook Spatial AI KR 그룹 (수학전문위원)

출신학교

독일 Kile 대학 이학박사 (Topological Geometry & Lie-group 전공, 컴퓨터 공학 부전공)

중앙대 수학과 학사, 석사(Topology 전공)

경력

전) 대성그룹 자회사 두비비젼 CTO

전) 중앙대학교 첨단영상 대학원 연구교수(3D Computer Vsion연구)

저서:

최적화이론: https://product.kyobobook.co.kr/detail/S000200518524

링크

유튜브: https://www.youtube.com/@3dcomputervision

블로그: https://blog.naver.com/jang_hwan_im

![[R로 하는] 머신러닝을 위한 통계학 기초Hình thu nhỏ khóa học](https://cdn.inflearn.com/public/courses/325155/course_cover/d8120723-26f7-4fcc-a25c-a99eef4ea0f6/machine-learning-statistics-r-eng.png?w=420)