-

질문 & 답변

카테고리

-

세부 분야

딥러닝 · 머신러닝

-

해결 여부

미해결

안녕하십니까 강의 잘 보고 있습니다

21.07.01 20:53 작성 조회수 213

0

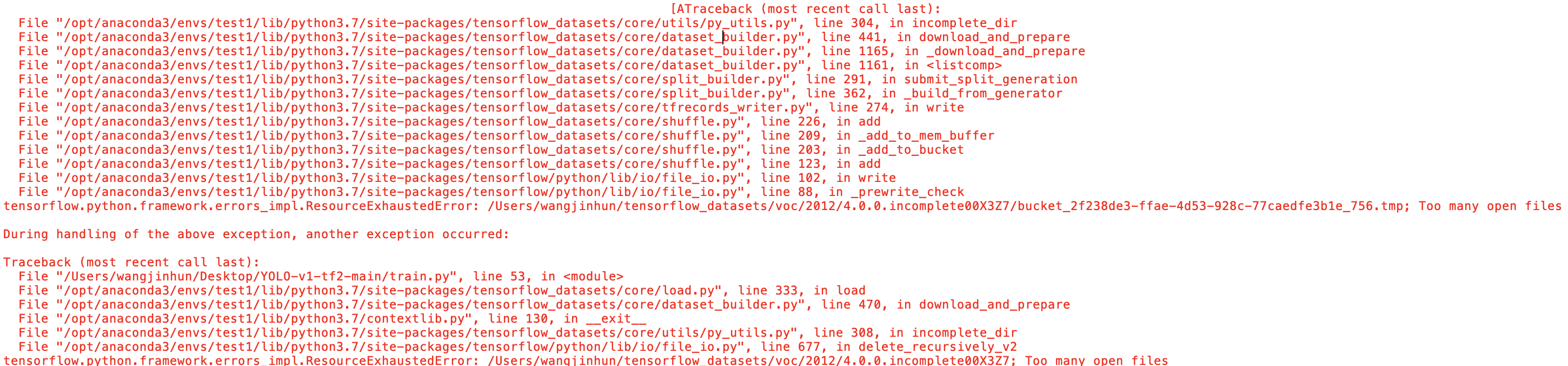

train.py를 실행하면 쭉 voc를 받다가 이런 오류가 뜨는데 어떻게 해야하나요??

train.py를 실행하면 쭉 voc를 받다가 이런 오류가 뜨는데 어떻게 해야하나요??

답변을 작성해보세요.

0

AISchool

지식공유자2021.07.08

안녕하세요~.

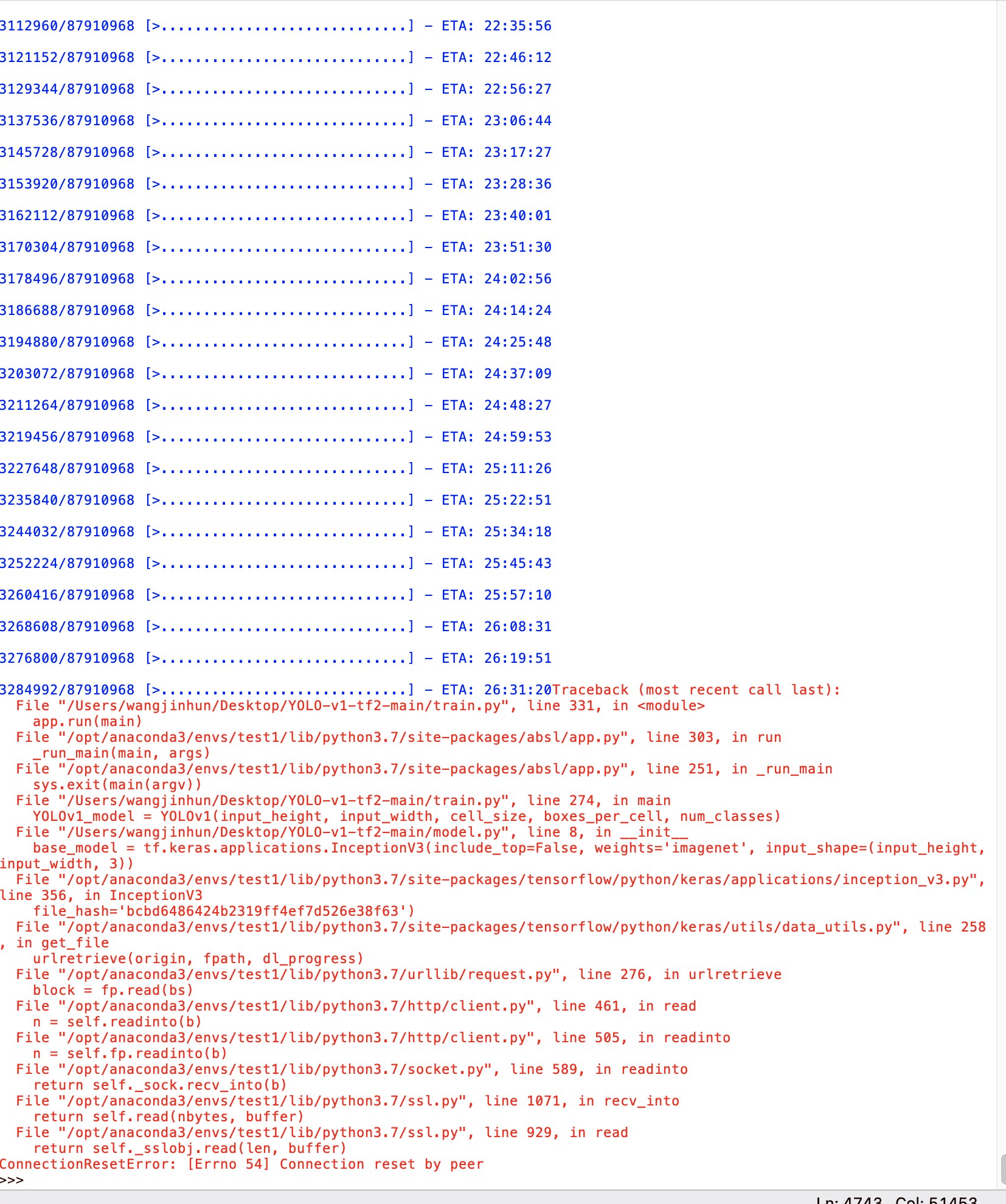

아래 사진에 숫자 올라가는게 무엇을 의미하는지 알려주실수 있을가요.

->

pascal voc 데이터셋을 로컬 환경에 다운로드 받는 것입니다.

질문 2

강사님이 주신 코드의 train data 와 test data, vaild data 등의 경로를 제가 직접 지정해 주면 제가 학습 시키고 싶은 것도 학습이 가능한가요?? 다크넷을 이용하여 yolo 학습을 시켜보았는데 이렇게도 가능하면 직접 해보고 싶어서 그렇습니다.

->

네. 가능합니다. 다만 해당 경우에 학습에 사용할 image와 annotation 파일등을 지금 코드에서 사용하는 형태의 데이터 타입과 똑같은 포맷으로 지정해서 처리해주어야만 하는데 이부분이 구현하시기 조금 어려우실수 있습니다.

감사합니다~.

0

찌눈이

질문자2021.07.06

강사님이 말씀하신 코드를 추가한뒤에 제 노트북을 가지고 동작을 해보니 아래와 같은 출력을 하다가 또 오류가 뜹니다. 하지만 감사히 코랩을 이용하여 강사님의 코드를 돌려보니 잘 동작하는 것을 확인하였습니다. 그래도 궁금해서 그런데 혹시 아래 사진에 숫자 올라가는게 무엇을 의미하는지 알려주실수 있을가요.

질문 2

강사님이 주신 코드의 train data 와 test data, vaild data 등의 경로를 제가 직접 지정해 주면 제가 학습 시키고 싶은 것도 학습이 가능한가요?? 다크넷을 이용하여 yolo 학습을 시켜보았는데 이렇게도 가능하면 직접 해보고 싶어서 그렇습니다.

0

AISchool

지식공유자2021.07.04

음... 아래 글을 참조하면 아래와 같이 적용했을때 문제가 해결될수도 있다고 하는 것 같네요.

https://ask.csdn.net/questions/6376147

아래와 같이 tfds를 import하기 전에 limit을 변경하는 아래 코드들을 추가해서 다시 시도해보시겠어요?

import resource

low, high = resource.getrlimit(resource.RLIMIT_NOFILE)

resource.setrlimit(resource.RLIMIT_NOFILE, (high, high))

import tensorflow_datasets as tfds

감사합니다.

0

찌눈이

질문자2021.07.04

그 부분을 삭제하고 해도 같은 오류가 나옵니다 ㅜㅜ이게 혹시 아나콘다를 이용한 가상환경에서 돌리는게 원인이 될 수 있나요? too many open file 이라고 계속 나오네요

0

AISchool

지식공유자2021.07.01

안녕하세요~. 반갑습니다.

voc 파일을 다운로드 하다가 뭔가 문제가 생긴것 같습니다.

아래 경로에 접근하신뒤

/Users/wangjihun/tensorflow_datasets/

해당 경로에 있는 voc 폴더를 삭제하고

다시 train.py 파일을 실행해서 다시 voc 데이터를 다운로드 받은뒤 진행해보시겠어요?

감사합니다.

답변 5