-

질문 & 답변

카테고리

-

세부 분야

딥러닝 · 머신러닝

-

해결 여부

미해결

교재 P42 MDP 계산 질문

23.07.18 21:49 작성 조회수 85

0

맨 아래 수식이

파이1 X p1 + 파이2 X p1 으로 나오는데요,

파이1 X p1 + 파이1 X p2 가 되어야 하지 않나요?

파이는 행동을 선택할 확률이고 S1->S2 로 이동하는건 파이 1에 국한되는 일이기 때문에 파이 1은 고정,

S3로 갈수도 있는 확률을 곱해서 더해줘야 할것 같은데..

글을 쓰다 보니 이것도 아닌것 같네요..

조금 더 설명 부탁드립니다.

답변을 작성해보세요.

1

멀티코어

지식공유자2023.07.19

안녕하세요 Nuno Bettencourt님.

강의를 수강해주셔서 감사합니다.

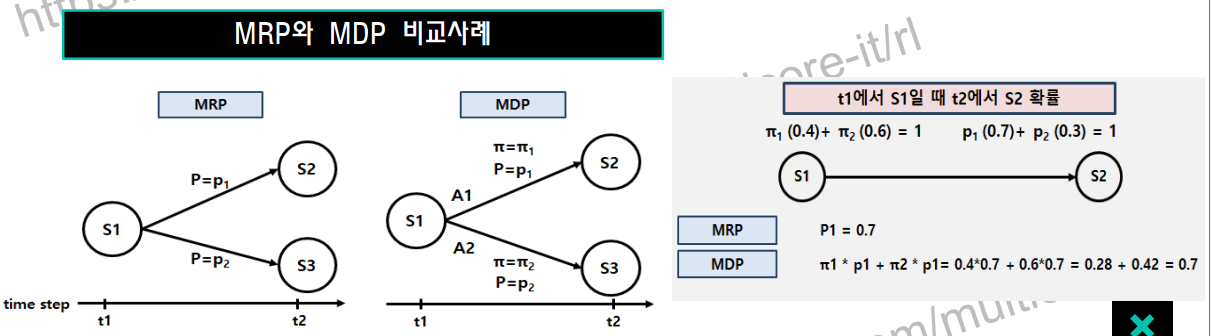

MRP에서는 확률이 1개 입니다. 상태전이확률이죠. 이 것은 자연환경에서 주어진 것입니다. MDP에서는 확률이 2개 입니다. 상태전이확률과 정책입니다. 정책에는 사람의 의지가 들어가 있습니다. 정확히 말하면 사람의 의지가 반영되어 학습에 의해 정해진 확률이 정책입니다. 정책 또한 상태전이확률과 마찬가지로 확률입니다.

배를 운전하는 경우를 보면 S2로 이동하는 정책과 S3로 이동하는 정책이 있을 때, 강화학습에서는 이것을 확률로 예기합니다. S2로 이동하는 정책의 확률이 0.4, S3로 이동하는 정책의 확률이 0.6일 경우. 강화학습 환경에서 배는 S2로 40%의 확률로 이동합니다. 확률적으로 가장 좋은 경로를 배가 선택하는 것입니다. 다시한번 말씀드리면 흑백 논리가 아나라 확률입니다. 여기에 추가되는 것이 상태전이확률입니다. 이것은 자연환경에서 주어지는 바람의 영향과 같습니다. S2로 이동하는 상태전이확률이 0.7이고, S3로 이동하는 상태전이확률이 0.3라고 할때, 배가 (정책에 의해)확률적으로 방향을 틀었을 때 바람이 S2방향으로 불어서 쉽게 이동할 확률이 바로 0.7입니다.

t2에서 S2에 있을 확률을 구해보면 다음과 같습니다. 여기에서 명심해야 할 것은 선장이 S2로 방향키를 틀었을 때 t2에 S2에 있을 확률이 아니라. 정책과 상태전이확률이 모두 확률적이고, 이 상태에서 배가 확률적 선택에 의해 t2에 S2에 있을 확률을 구하는 것입니다. 배는 S2, S3로 가는 선택을 각각 0.4와 0.6의 확률로 하게됩니다. 이것은 배가 그 동안 항해를 통해 학습한 결과를 통해 만들어진 확률입니다. 또한 여기에 자연적으로 S2로 흘러갈 확률(상태전이확률)이 0.7입니다. 그러면 확률적으로 계산할 때 배의 정책 선택에 대한 각각의 확률과 S2로 이동할 수 있는 상태전이확률을 곱해서 합계를 구하면 t2에서 S2에 있을 확률을 구할 수 있습니다. 아래 그림과 같이 "S2에 있을 확률 = 정책1x상태전이확률1 + 정책2x상태전이확률1"이 됩니다.

감사합니다.

답변 1