-

질문 & 답변

카테고리

-

세부 분야

딥러닝 · 머신러닝

-

해결 여부

미해결

MDP 질문

22.10.09 09:50 작성 조회수 130

0

MDP에서 상태가 변한다는 것은 원래 가지고 있던 상태 전이 매트릭스와 정책의 영향을 동시에 받는다는 것과 같다. (이해완료)

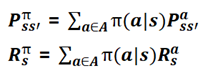

따라서 행동에 따른 정책과 상태 전이 확률의 기댓값(평균)을 구함으로서 정책을 고려한 상태 전이 매트릭스를 구할 수 있다(이해 못함)

-> 두번째 문장에서 기댓값을 구해서 상태전이 매트릭스를 구할 수 있다는 부분이 이해가 잘 안됩니다.

답변을 작성해보세요.

0

멀티코어

지식공유자2022.10.19

안녕하세요 ljp4122님.

이 문제를 해결하기 위해 위 식과 같이 행동에 따른 정책(𝝿)과 상태 전이 확률(P)의 기댓값(평균)을 구함으로써 정책을 고려한 상태 전이 매트릭스를 구할 수 있습니다. 여기에서 기대값은 평균의 개념을 가지고 있습니다.

감사합니다.

답변 1