(企画者のための)LLMの基礎とLLMベースサービス企画の理解

arigaram

LLMが必要な理由と技術的背景、および基本概念について説明します。

Beginner

NLP, gpt, AI

生成AIまたはLLMをベースにRAG(検索拡張生成:Retrieval-Augmented Generation)システムを構築しても、望む性能が得られず、適切な解決策が見つからない場合はどうすればよいでしょうか? 本講義では、認知負荷(Cognitive Load)理論に基づき、RAG性能を改善する方策を提示します。この講義を通じて、LLMコンテキストウィンドウの限界を理解し、RAGシステムにおける認知負荷の効果的な管理方法を習得できます。チャンク(Chunk)のサイズと構造設計、高品質チャンク生成手法、動的最適化、性能評価、実践技法などを網羅する実務レベルの理論講義です。

受講生 18名

難易度 中級以上

受講期間 無制限

LLMコンテキストウィンドウとトークンの限界を理解し管理するための戦略

高品質チャンクを生成する方法とRAGパイプラインに統合する方法

現在、講義を完成させている最中です。講義が完全に完成するまで(随時補強はしますが)長くお待ちいただく必要があるという欠点があります。この点を考慮してご購入を決定していただきますようお願いいたします。

2025年9月4日

各セクション別の統合要約版を2/3程度アップロードしました。まだアップロードしていない統合要約版を近いうちに一つずつアップロードします。

セクション3をセクション3とセクション4に分離していましたが、講義リストにあるセクション番号と授業資料にあるセクション番号が不一致になり、混乱を招く可能性があったため、セクション4をセクション31(最後尾)に移動しました。

2025年9月1日

セクション3をセクション3とセクション4に分離しました。これに伴い、セクション番号と授業資料番号が一致しない場合があります。授業資料を修正し、動画を録音して再度掲載いたします。お待ちいただければ幸いです。

受講生の混乱を減らす方向で目次を再構成しています。これに伴い、8月22日に一時非公開処理していた授業を再び公開処理しました。

2025年8月22日

まだ完成していない[上級]コースに属する授業(セクション11〜30)を非公開状態に変更しました。今後完成次第、各セクションごとまたは授業ごとに公開する予定です。受講生の混乱を減らすための措置ですので、ご理解いただければ幸いです。

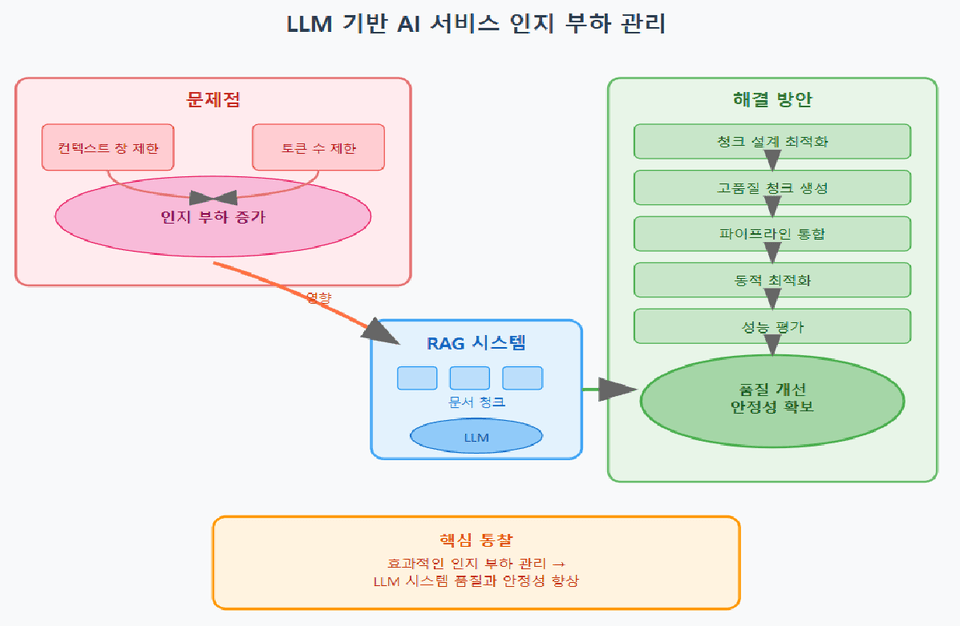

大規模言語モデル(LLM)をベースに人工知能サービスを作る方式が主流になりましたが、コンテキストウィンドウのサイズとトークン数が制限されているため限界があります。特にRAG(Retrieval-Augmented Generation:検索拡張生成)システムでは、ドキュメントやチャンク(Chunks:ドキュメントの断片)を適切に管理できないと、LLM側の認知負荷が発生し、最適な回答を生成することが難しくなります。

認知負荷(cognitive load)とは、システム(人間の脳と人工知能を含む)が処理すべき情報量と複雑性によって、情報を認識しにくくなる程度を意味します。LLMシステムにおいて認知負荷が高まると、情報が過度に蓄積されて核心が曖昧になり、性能が低下して期待するレベルの回答が得られない可能性があります。したがって、効果的な認知負荷管理はLLMベースのシステムの品質と安定性を左右する核心要素です。

この講義では、LLMのコンテキストウィンドウの限界と認知負荷の概念に基づき、チャンク設計から高品質なチャンク生成、RAGパイプラインの統合、動的最適化、そしてパフォーマンス評価に至るまで、実務にすぐに適用できる段階的な方法論を提示します。これにより、既存の様々なRAG強化技法では解決できなかった応答品質の低下問題を大幅に解決できることが期待されます。

LLMコンテキストウィンドウとトークン制限による認知負荷管理戦略

高品質チャンク(Chunk)生成方法と多様なチャンキング(Chunking)技法を活用する方案

RAGシステムを構築するためのデータ前処理、検索、プロンプト設計、後処理を統合する技術

動的最適化によるリアルタイムチャンクサイズ調整と要約パラメータ調整

パフォーマンス評価指標の適用と結果レポート作成方法

人工知能(AI)、ChatGPT、LLM、RAG、AI活用(AX)

最初のセクションでは、本講義の全体的な概要と目標を明確にし、LLMのコンテキストウィンドウと認知負荷管理の基本概念を扱います。特に認知負荷とは何か、LLM環境においてこれがなぜ重要なのかを詳しく理解し、RAGの基礎を学習します。理論をベースに講義で扱う核心的なトピックを確認しながら、学習の方向性を定めるのに役立ちます。初心者でも簡単についてこられるよう概念を一つずつ丁寧に説明し、その後の高度なトピックへ自然に移行できる確かな土台を築きます。

このセクションでは、LLMのコンテキストウィンドウとトークン化メカニズムを深く分析します。トークンとは何か、どのように分割され、モデルの入力にどのような影響を与えるかを詳しく見ていき、コンテキストウィンドウサイズの限界がモデルのパフォーマンスにどのような影響を与えるかを様々な事例とともに説明します。また、トークンに応じたコストを計算する方法を身につけ、実際のシステム設計時に活用できるよう実務的な感覚を養います。このプロセスを通じて、トークンとコンテキストに対する体系的な理解を基に、認知負荷管理の具体的な問題を直感的に把握できるようになります。

効果的なチャンク設計はRAGシステム品質の核心です。このセクションでは、固定サイズチャンクから段落ベース、意味単位クラスタリング、階層型構造に至る多様なチャンク戦略を紹介し、各方法の長所と短所、適用事例を深く扱います。チャンクサイズと構造が認知負荷とコンテキスト活用に与える影響についての理解を基に、状況に合った最適なチャンク戦略を設計する実践ノウハウを習得できます。最後には実習を通じて多様なチャンク方式を適用する経験を積み、理論と実務を有機的に結びつけることができます。

このセクションでは、認知負荷を減らし情報品質を高めるのに適したチャンクを生成する技法の中で、より高度な技法を扱います。スマート要約、原文と要約文の統合、埋め込みベースのクラスタリング、メタタグ付け、クエリ意図の反映といった様々な技術を習得し、各技法を組み合わせてより効率的なチャンクを作る方法を実習します。これにより、単純なチャンキング方式を超えて、情報の意味と質問者の意図まで反映した高品質チャンクを生成する能力を養います。これは複雑な文書を扱わなければならない状況でも、LLMが最適な回答を出せるよう支援するための核心戦略です。

このセクションでは、RAGシステムの設計と統合を本格的に扱います。前処理、類似度検索とフィルタリング、チャンク再構成及びプロンプト設計、回答生成と後処理、そして幻覚現象(Hallucination)チェック及び再投入戦略に至るまで、RAGパイプライン全過程を体系的に扱います。各段階ごとに認知負荷を最小化しながらも正確な回答生成に集中するノウハウを実習とともに習得します。実務環境ですぐに適用可能な実質的な技術と問題解決方法を重点的に提供します。

このセクションでは、コンテキスト負荷とチャンクのサイズを状況に合わせて動的に調整する方法を扱います。質問の複雑度評価、動的チャンクサイズ調整アルゴリズム、適応型要約パラメータ調整、マルチターン対話におけるコンテキスト累積管理、そしてシステムモニタリングとフィードバックループ設計に至るまで、インテリジェントシステム運用のための自動化および最適化戦略を深く紹介します。これにより、変化する要求と複雑度に対応しながらLLMパフォーマンスを最大化できるリアルタイム管理能力を身につけることができます。

RAGシステムとチャンク戦略の効果を客観的に評価するための多様な指標と評価方法論を扱います。再現率、精度、応答遅延、コスト分析、トークン使用効率、ユーザー満足度、そしてA/Bテストを通じた戦略検証に至るまで、システム性能の多角的測定を通じて改善点を導出する方法を学習します。評価結果を基に継続的な性能チューニングと高度化のための知見を提示し、データ基盤の意思決定能力を強化します。

現在のRAGとLLM認知負荷管理分野で解決すべき研究課題と未来の拡張可能性について議論します。完全自動化されたチャンク最適化、長期記憶統合問題、大規模マルチメディア文書ベースのRAGシステム構築シナリオ、マルチモーダル情報を処理する方向でRAGシステムを拡張する方法を扱います。最新の研究動向と実際の適用事例を通じて、今後の発展方向と挑戦課題を明確に理解できるようにします。

このセクションでは、これまで学んだ理論と技法を統合し、実際のRAGシステムを設計、実装、調整、評価する総合プロジェクトを遂行する方法を説明します。プロジェクトテーマの選定からデータ収集・前処理、Chunk戦略設計、RAGシステム統合、性能評価及び結果レポート作成、最終発表とコードレビューに至るまでのすべての段階を順次進めながら、実戦能力を検証できるようにします。ここで学んだ内容をもとに、開発者はチームを構成するか個人単位で実務型プロジェクトを進めることができ、これを通じてこの講義で学習した内容を完璧に体得することができるでしょう。

認知負荷の概念に基づいてLLMコンテキストウィンドウとトークン制限を明確に理解し、これを管理する戦略を習得します。

様々なチャンク生成技法とチャンク最適化技法で情報を効率的に分割・要約し、LLMのパフォーマンスを最大化できます。

RAGパイプライン全体のプロセスを実習し、実際のシステム構築および調整能力を身につけることができます。

動的最適化とパフォーマンス評価を通じて、リアルタイム運用環境で安定的かつ高性能なAIサービスを提供する方法を学びます。

最新の研究課題と拡張方向を通じてAIシステムの発展の流れを理解し、未来への対応力を強化します。

学習対象は

誰でしょう?

LLMとRAGシステムを直接設計したり運用する開発者

大容量ドキュメント処理およびマルチターン対話処理の最適化に関心のある人工知能エンジニア

前提知識、

必要でしょうか?

自然言語処理(NLP)に関する基本概念の理解

大規模言語モデル(LLM)の基本動作原理を理解する

トークン化とコンテキストウィンドウについての概念

基本的なプログラミング能力(Python言語推奨)

(選択) 人工知能および機械学習モデルを活用した経験、または関連プロジェクトの実施経験

全体

322件 ∙ (47時間 9分)

講座資料(こうぎしりょう):

¥41,039

知識共有者の他の講座を見てみましょう!

同じ分野の他の講座を見てみましょう!