Thống kê học trí tuệ nhân tạo dành cho người không chuyên ngành

arigaram

Thấu hiểu bản chất của thống kê cơ bản cần thiết cho việc phát triển và ứng dụng trí tuệ nhân tạo mà không cần đến một công thức hay một dòng mã nào.

入門

AI

Khi xây dựng hệ thống RAG (Retrieval-Augmented Generation: Tạo sinh tăng cường truy xuất) dựa trên AI tạo sinh hoặc LLM mà không đạt được hiệu suất mong muốn và không có giải pháp thích hợp, thì phải làm sao? Khóa học này sẽ trình bày các phương pháp cải thiện hiệu suất RAG dựa trên lý thuyết Cognitive Load (Tải trọng nhận thức). Thông qua khóa học này, bạn có thể hiểu được giới hạn của cửa sổ ngữ cảnh LLM và cách quản lý Cognitive Load một cách hiệu quả trong hệ thống RAG. Đây là một khóa học lý thuyết cấp độ thực tiễn, bao gồm các chủ đề như kích thước và thiết kế cấu trúc Chunk, kỹ thuật tạo Chunk chất lượng cao, tối ưu hóa động, đánh giá hiệu suất và các kỹ thuật thực chiến.

18 học viên

Độ khó Trung cấp trở lên

Thời gian Không giới hạn

Chiến lược hiểu và quản lý giới hạn của cửa sổ ngữ cảnh và token trong LLM

Cách tạo Chunk chất lượng cao và cách tích hợp vào pipeline RAG

Hiện tại khóa học đang trong quá trình hoàn thiện. Có nhược điểm là bạn sẽ phải chờ đợi lâu cho đến khi khóa học hoàn thành (mặc dù sẽ có những cập nhật bổ sung thường xuyên). Vui lòng cân nhắc điều này trước khi quyết định mua.

Ngày 4 tháng 9 năm 2025

Tôi đã đăng tải khoảng 2/3 bản tóm tắt tổng hợp cho từng phần. Tôi sẽ sớm đăng tải từng bản tóm tắt tổng hợp còn lại.

Tôi đã tách Phần 3 thành Phần 3 và Phần 4, nhưng điều này có thể gây nhầm lẫn do số phần trong danh sách bài giảng và số phần trong tài liệu học tập không khớp nhau, nên tôi đã chuyển Phần 4 sang Phần 31 (cuối cùng).

1 tháng 9 năm 2025

Chúng tôi đã tách Phần 3 thành Phần 3 và Phần 4. Do đó, số thứ tự của các phần và số thứ tự của tài liệu học tập có thể không khớp nhau. Chúng tôi sẽ chỉnh sửa tài liệu học tập và ghi âm lại video để đăng tải lại. Rất mong quý vị kiên nhẫn chờ đợi. Xin cảm ơn.

Chúng tôi đang tái cấu trúc mục lục theo hướng giảm thiểu sự nhầm lẫn cho học viên. Theo đó, các bài học đã tạm thời chuyển sang trạng thái riêng tư vào ngày 22 tháng 8 đã được công khai trở lại.

22 tháng 8, 2025

Tôi đã chuyển các bài học thuộc khóa [Nâng cao] chưa hoàn thành (Phần 11 ~ 30) sang trạng thái riêng tư. Trong tương lai, khi hoàn thành, tôi sẽ công khai từng phần hoặc từng bài học. Đây là biện pháp nhằm giảm thiểu sự nhầm lẫn cho học viên, rất mong các bạn thông cảm.

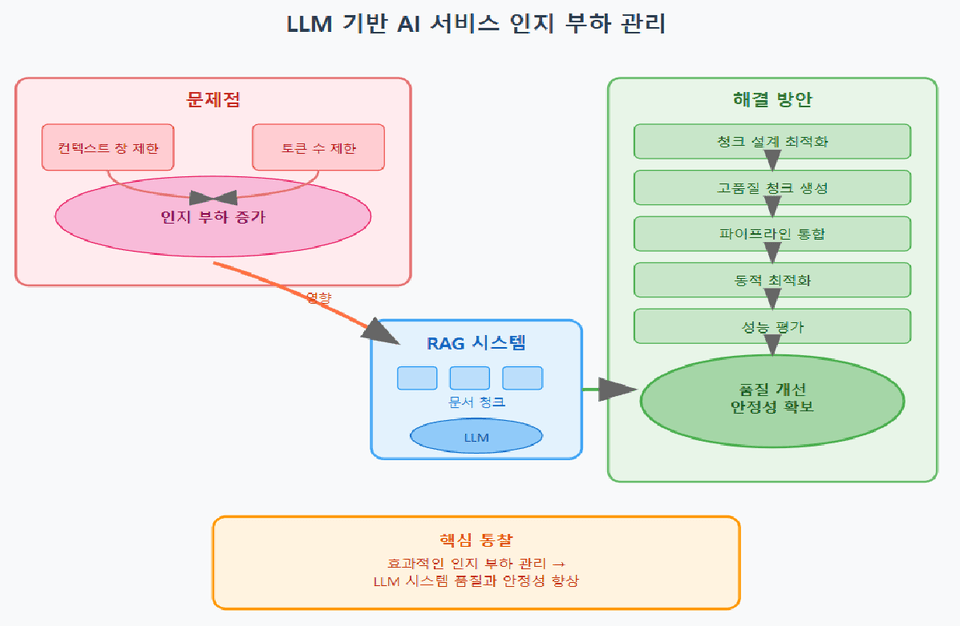

Mô hình ngôn ngữ lớn (LLM) đã trở thành xu hướng chủ đạo trong việc xây dựng các dịch vụ trí tuệ nhân tạo, tuy nhiên vẫn tồn tại những hạn chế do kích thước cửa sổ ngữ cảnh và số lượng token bị giới hạn. Đặc biệt trong hệ thống RAG (Retrieval-Augmented Generation: Tạo sinh tăng cường bằng truy xuất), nếu không quản lý tài liệu hoặc các chunk (Chunks: đoạn văn bản nhỏ của tài liệu) một cách hợp lý, sẽ phát sinh tải nhận thức ở phía LLM, khiến việc tạo ra câu trả lời tối ưu trở nên khó khăn.

Tải nhận thức (cognitive load) là mức độ khó khăn trong việc nhận biết thông tin tùy thuộc vào lượng thông tin và độ phức tạp mà hệ thống (bao gồm cả bộ não con người và trí tuệ nhân tạo) phải xử lý. Trong hệ thống LLM, khi tải nhận thức tăng cao, thông tin tích tụ quá mức khiến trọng tâm bị mờ nhạt, hiệu suất giảm sút và có thể không đạt được câu trả lời ở mức độ mong đợi. Do đó, quản lý tải nhận thức hiệu quả là yếu tố cốt lõi quyết định chất lượng và tính ổn định của hệ thống dựa trên LLM.

Trong khóa học này, dựa trên khái niệm giới hạn cửa sổ ngữ cảnh của LLM và tải nhận thức, chúng tôi trình bày phương pháp luận từng bước có thể áp dụng ngay vào thực tế, từ thiết kế chunk, tạo chunk chất lượng cao, tích hợp pipeline RAG, đến tối ưu hóa động và đánh giá hiệu suất. Thông qua đó, kỳ vọng có thể giải quyết phần lớn vấn đề suy giảm chất lượng phản hồi mà các kỹ thuật tăng cường RAG đa dạng hiện có không thể giải quyết được.

Chiến lược quản lý tải nhận thức theo cửa sổ ngữ cảnh và giới hạn token của LLM

Phương pháp tạo Chunk chất lượng cao và cách thức sử dụng các kỹ thuật Chunking đa dạng

Công nghệ tích hợp tiền xử lý dữ liệu, tìm kiếm, thiết kế prompt và hậu xử lý để xây dựng hệ thống RAG

Điều chỉnh kích thước chunk và tham số tóm tắt theo thời gian thực thông qua tối ưu hóa động

Phương án áp dụng chỉ số đánh giá hiệu suất và viết báo cáo kết quả

Trí tuệ nhân tạo (AI), ChatGPT, LLM, RAG, Ứng dụng AI (AX)

Trong phần đầu tiên, chúng ta sẽ làm rõ tổng quan và mục tiêu của khóa học, đồng thời đề cập đến các khái niệm cơ bản về cửa sổ ngữ cảnh của LLM và quản lý tải nhận thức. Đặc biệt, chúng ta sẽ hiểu chi tiết tải nhận thức là gì, tại sao nó lại quan trọng trong môi trường LLM, và học về những kiến thức nền tảng của RAG. Dựa trên lý thuyết, chúng ta sẽ điểm qua các chủ đề cốt lõi sẽ được đề cập trong khóa học, giúp định hướng học tập. Các khái niệm sẽ được giải thích từng bước một cách dễ hiểu để người mới bắt đầu cũng có thể theo kịp, từ đó xây dựng nền tảng vững chắc để chuyển tiếp tự nhiên sang các chủ đề nâng cao sau này.

Trong phần này, chúng ta sẽ phân tích sâu về cửa sổ ngữ cảnh và cơ chế token hóa của LLM. Chúng ta sẽ tìm hiểu chi tiết về token là gì, cách chúng được phân tách và ảnh hưởng như thế nào đến đầu vào của mô hình, đồng thời giải thích thông qua các ví dụ đa dạng về cách giới hạn kích thước cửa sổ ngữ cảnh ảnh hưởng đến hiệu suất của mô hình. Ngoài ra, bạn sẽ học cách tính toán chi phí theo token để có thể áp dụng vào thiết kế hệ thống thực tế, từ đó phát triển trực giác thực tiễn. Thông qua quá trình này, dựa trên sự hiểu biết có hệ thống về token và ngữ cảnh, bạn sẽ có thể nắm bắt trực quan các vấn đề cụ thể trong quản lý tải nhận thức.

Thiết kế chunk hiệu quả là yếu tố cốt lõi quyết định chất lượng hệ thống RAG. Trong phần này, chúng ta sẽ giới thiệu các chiến lược chunk đa dạng từ chunk kích thước cố định đến chunk dựa trên đoạn văn, phân cụm đơn vị ngữ nghĩa và cấu trúc phân cấp, đồng thời phân tích sâu về ưu nhược điểm và các trường hợp áp dụng của từng phương pháp. Dựa trên sự hiểu biết về tác động của kích thước và cấu trúc chunk đối với tải nhận thức và việc sử dụng ngữ cảnh, bạn sẽ có thể nắm vững kinh nghiệm thực tế trong việc thiết kế chiến lược chunk tối ưu phù hợp với từng tình huống. Cuối cùng, thông qua thực hành áp dụng các phương pháp chunk khác nhau, bạn sẽ tích lũy kinh nghiệm và kết nối hữu cơ giữa lý thuyết và thực tiễn.

Trong phần này, chúng ta sẽ tìm hiểu các kỹ thuật nâng cao để tạo chunk phù hợp với việc giảm tải nhận thức và nâng cao chất lượng thông tin. Bạn sẽ học và thực hành nhiều kỹ thuật đa dạng như tóm tắt thông minh, kết hợp văn bản gốc với bản tóm tắt, phân cụm dựa trên embedding, gắn thẻ meta, phản ánh ý định truy vấn, cũng như cách kết hợp các kỹ thuật này để tạo ra chunk hiệu quả hơn. Qua đó, bạn sẽ phát triển năng lực tạo ra chunk chất lượng cao vượt xa phương pháp chunking đơn giản, có thể phản ánh cả ý nghĩa thông tin và ý định của người đặt câu hỏi. Đây là chiến lược cốt lõi giúp LLM đưa ra câu trả lời tối ưu ngay cả khi xử lý các tài liệu phức tạp.

Trong phần này, chúng ta sẽ đi sâu vào thiết kế và tích hợp hệ thống RAG. Chúng ta sẽ xem xét một cách có hệ thống toàn bộ quy trình pipeline RAG, từ tiền xử lý, tìm kiếm và lọc theo độ tương đồng, tái cấu trúc chunk và thiết kế prompt, tạo câu trả lời và hậu xử lý, cho đến kiểm tra hiện tượng ảo giác (Hallucination) và chiến lược tái đầu vào. Thông qua thực hành, bạn sẽ học được các kỹ thuật tập trung vào việc tạo ra câu trả lời chính xác trong khi giảm thiểu tải nhận thức ở từng bước. Khóa học tập trung cung cấp các kỹ thuật thực tế và phương pháp giải quyết vấn đề có thể áp dụng ngay trong môi trường làm việc thực tế.

Trong phần này, chúng ta sẽ tìm hiểu cách điều chỉnh động tải ngữ cảnh và kích thước chunk phù hợp với từng tình huống. Từ đánh giá độ phức tạp của câu hỏi, thuật toán điều chỉnh kích thước chunk động, điều chỉnh tham số tóm tắt thích ứng, quản lý tích lũy ngữ cảnh trong hội thoại đa lượt, đến thiết kế vòng lặp giám sát hệ thống và phản hồi - chúng tôi sẽ giới thiệu chuyên sâu các chiến lược tự động hóa và tối ưu hóa để vận hành hệ thống thông minh. Thông qua đó, bạn sẽ có được khả năng quản lý thời gian thực để tối đa hóa hiệu suất LLM, đáp ứng với những yêu cầu và độ phức tạp thay đổi.

Bài viết này đề cập đến các chỉ số và phương pháp luận đánh giá đa dạng để đánh giá một cách khách quan hiệu quả của hệ thống RAG và chiến lược chunk. Từ recall, độ chính xác, độ trễ phản hồi, phân tích chi phí, hiệu suất sử dụng token, mức độ hài lòng của người dùng, cho đến xác thực chiến lược thông qua A/B test, bạn sẽ học cách rút ra những điểm cần cải thiện thông qua đo lường đa chiều hiệu suất hệ thống. Dựa trên kết quả đánh giá, bài viết đưa ra những hiểu biết sâu sắc cho việc tinh chỉnh hiệu suất liên tục và nâng cao hệ thống, đồng thời tăng cường năng lực ra quyết định dựa trên dữ liệu.

Bài viết này thảo luận về các nhiệm vụ nghiên cứu cần giải quyết và khả năng mở rộng trong tương lai trong lĩnh vực quản lý tải nhận thức RAG và LLM. Nội dung bao gồm tối ưu hóa chunk hoàn toàn tự động, vấn đề tích hợp bộ nhớ dài hạn, kịch bản xây dựng hệ thống RAG dựa trên tài liệu đa phương tiện quy mô lớn, và phương pháp mở rộng hệ thống RAG theo hướng xử lý thông tin đa phương thức. Thông qua xu hướng nghiên cứu mới nhất và các trường hợp ứng dụng thực tế, bạn sẽ hiểu rõ hướng phát triển và thách thức trong tương lai.

Trong phần này, chúng ta sẽ tìm hiểu cách thực hiện một dự án tổng hợp để thiết kế, triển khai, điều chỉnh và đánh giá hệ thống RAG thực tế bằng cách tích hợp các lý thuyết và kỹ thuật đã học cho đến nay. Bạn sẽ có thể xác minh năng lực thực tế của mình bằng cách thực hiện tuần tự tất cả các bước từ việc lựa chọn chủ đề dự án, thu thập và tiền xử lý dữ liệu, thiết kế chiến lược Chunk, tích hợp hệ thống RAG, đánh giá hiệu suất và viết báo cáo kết quả, đến thuyết trình cuối cùng và code review. Dựa trên những gì đã học ở đây, các nhà phát triển sẽ có thể thực hiện các dự án thực tế theo nhóm hoặc cá nhân, và thông qua đó có thể hoàn toàn tiếp thu nội dung đã học trong khóa học này.

Hiểu rõ cửa sổ ngữ cảnh và giới hạn token của LLM dựa trên khái niệm tải nhận thức, đồng thời nắm vững các chiến lược quản lý chúng.

Với các kỹ thuật tạo chunk đa dạng và kỹ thuật tối ưu hóa chunk, bạn có thể phân chia và tóm tắt thông tin một cách hiệu quả để tối đa hóa hiệu suất của LLM.

Thực hành toàn bộ quy trình RAG pipeline, trang bị khả năng xây dựng và điều chỉnh hệ thống thực tế.

Học cách cung cấp dịch vụ AI ổn định và hiệu suất cao trong môi trường vận hành thời gian thực thông qua tối ưu hóa động và đánh giá hiệu suất.

Hiểu được xu hướng phát triển của hệ thống AI thông qua các đề tài nghiên cứu mới nhất và hướng mở rộng, đồng thời tăng cường khả năng ứng phó với tương lai.

Khóa học này dành cho ai?

Nhà phát triển trực tiếp thiết kế hoặc vận hành hệ thống LLM và RAG

Kỹ sư AI quan tâm tối ưu hóa xử lý tài liệu dung lượng lớn và xử lý hội thoại đa lượt.

Cần biết trước khi bắt đầu?

Tìm hiểu khái niệm cơ bản về Xử lý ngôn ngữ tự nhiên (NLP)

Hiểu nguyên lý hoạt động cơ bản của mô hình ngôn ngữ lớn (LLM)

Khái niệm về token hóa và cửa sổ ngữ cảnh

Kỹ năng lập trình cơ bản (ưu tiên Python)

(Tùy chọn) Kinh nghiệm áp dụng mô hình Trí tuệ nhân tạo và Học máy, hoặc kinh nghiệm thực hiện dự án liên quan

613

Học viên

31

Đánh giá

2

Trả lời

4.5

Xếp hạng

18

Các khóa học

Tôi là một người coi IT vừa là sở thích vừa là nghề nghiệp.

Tôi có nhiều kinh nghiệm trong việc viết lách, dịch thuật, tư vấn, phát triển và giảng dạy.

Tất cả

326 bài giảng ∙ (50giờ 15phút)

Tài liệu khóa học:

6.789.095 ₫

Hãy khám phá các khóa học khác của giảng viên!

Khám phá các khóa học khác trong cùng lĩnh vực!