모두를 위한 대규모 언어 모델 LLM(Large Language Model) Part 1 - Llama 2 Fine-Tuning 해보기

AISchool

LLM(Large Language Model)의 기초 개념부터 고성능 LLM인 Llama 2 모델을 내가 원하는 데이터셋에 Fine-Tuning하는 방법까지 차근차근 학습합니다.

Intermediate

LLM, Llama, 딥러닝

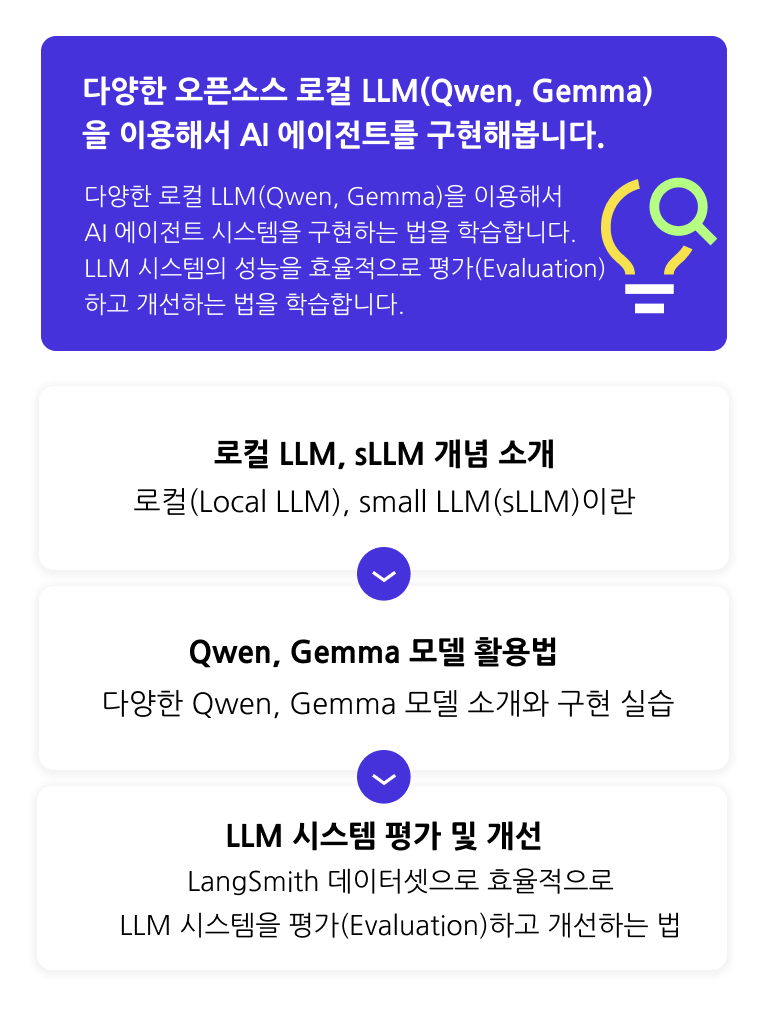

다양한 로컬 LLM(Qwen, Gemma)을 활용하는 방법을 학습하고, LLM 시스템의 성능을 효율적으로 평가(Evaluation)하고 개선하는 다양한 기법들을 살펴봅니다.

7명 이 수강하고 있어요.

난이도 중급이상

수강기한 무제한

로컬 LLM(Qwen, Gemma)를 이용해서 AI 에이전트를 구현하는 법

LLM 시스템의 성능을 평가(Evaluation)하고 개선하는 법

고품질 AI 에이전트를 구현하는 법

실습을 통해 로컬 LLM(Local LLM)을 활용해서 다양한 AI 에이전트를 구현해봅니다.

로컬 LLM(Qwen, Gemma)을 효율적으로 활용하는 법

LLM 시스템의 성능을 효과적으로 평가(Evaluation)하고 개선하는 법

로컬 LLM(Qwen, Gemma)을 활용해서 AI 에이전트를

만들어보고 싶은 분

OpenAI API가 아니라 로컬 LLM으로 AI 에이전트를 구현해보고 싶은 분

LLM 시스템 구현 능력을

향상시키고 싶으신 분

LLM의 성능을 효율적으로 평가(Evaluation)하고 개선하는 방법을 학습하고 싶은 분

최신 AI 트렌드를

놓치고 싶지 않은 분

최신 LLM 모델들을 팔로업(follow-up)하면서 최신 AI 트렌드를 놓치지않고 싶은신 분

👋 본 강의는 Python, 자연어처리(NLP), LLM, 랭체인(LangChain), LangGraph에 대한 선수지식이 필요한 강의입니다. 반드시 아래 강의를 먼저 수강하시거나 그에 준하는 지식을 갖춘 뒤 본 강의를 수강하세요.

Q. 로컬 LLM(Local LLM)이란 무엇인가요?

로컬(Local LLM)은 “내 PC/서버(로컬 환경)에서 직접 실행하는 대규모 언어 모델(LLM)”을 뜻합니다. 즉, OpenAI API처럼 클라우드(원격 서버)에 요청을 보내는 방식이 아니라, 내 컴퓨터의 CPU/GPU에서 모델을 돌려서 텍스트 생성/요약/번역/코딩 도움 등을 하는 형태입니다. 대표적인 로컬 LLM 모델로 Qwen과 Gemma 모델이 있습니다.

Q. 로컬 LLM(Local LLM)을 활용할 때의 장점은 무엇인가요?

오픈소스 로컬 LLM을 활용할 때의 장점은 다음과 같습니다.

데이터 통제/프라이버시

민감 데이터(내부 문서, 고객정보)를 외부 API로 보내지 않고 온프레미스/사내 VPC에서 처리 가능.

보안감사/규정준수(금융·의료 등)에서 유리.

비용 구조를 ‘예측 가능’하게 만들 수 있음

API처럼 “토큰당 과금”이 아니라 GPU/서버 비용으로 고정화 가능(트래픽이 클수록 유리해지기 쉬움).

캐시/배치/양자화 등으로 단가를 직접 낮출 수 있음.

커스터마이징(튜닝/도메인 특화)이 쉬움

LoRA/QLoRA, DPO, RAG 튜닝, 시스템 프롬프트 고정 등 업무 도메인 맞춤 최적화가 가능.

출력 포맷(예: JSON 엄격), 용어/톤/규칙 준수율을 현업 기준으로 끌어올리기 좋음.

벤더 락인 감소

특정 회사의 정책 변경, 가격 인상, 모델 단종, 레이트리밋 변화에 덜 흔들림.

필요하면 언제든 다른 모델로 스위칭 가능.

투명성/디버깅 이점

가중치/아키텍처 정보가 공개되는 경우가 많아, 성능 이슈를 더 체계적으로 진단 가능.

안전성/편향 테스트를 내부 기준으로 수행하기 쉬움.

Q. 선수 지식이 필요한가요?

본 [로컬 LLM(Local LLM) 활용 가이드 Part 1 - small LLM(sLLM) 활용하기 & LLM의 성능 평가(Evaluation) 및 개선하기] 강의는 랭체인(LangChain),랭그래프(LangGraph) 라이브러리와 LLM을 이용해서 AI 에이전트를 구현하는 프로젝트 실습을 다루고 있습니다. 따라서 Python, 자연어처리, LLM, 랭체인(LangChain), 랭그래프(LangGraph)에 대한 기초지식을 가지고 있다는 가정하에 강의가 진행됩니다. 따라서 선수지식이 부족하다면 반드시 선행 강의인 [모두를 위한 대규모 언어 모델 LLM Part 5 - LangGraph로 나만의 AI 에이전트 만들기] 강의를 먼저 수강하시길 바랍니다.

학습 대상은

누구일까요?

로컬 LLM(Local LLM) 활용법을 학습하고 싶은 분

로컬 LLM(Qwen, Gemma)으로 AI 에이전트를 만들어보고 싶은 분

선수 지식,

필요할까요?

Python 사용 경험

선수강의 [모두를 위한 대규모 언어 모델 LLM Part 5 - LangGraph로 나만의 AI 에이전트 만들기] 수강경험

9,479

명

수강생

718

개

수강평

353

개

답변

4.6

점

강의 평점

31

개

강의

전체

37개 ∙ (7시간 3분)

얼리버드 할인 중

₩49,500

25%

₩66,000

지식공유자님의 다른 강의를 만나보세요!

같은 분야의 다른 강의를 만나보세요!