カフカパーフェクトガイド - コア編

dooleyz3525

¥12,114

29%

¥8,480

中級以上 / Kafka, Data Engineering

4.9

(103)

カフカの核心から内部メカニズムの深化レベルの内容まで、詳細な理論の説明とハンズオン実践&本番カフカアプリケーションの開発実践を通じて、カフカを始める人も一気に専門家レベルに到達できるように講義を構成しました。

中級以上

Kafka, Data Engineering

カフカ・コネクトに関する深い理論の説明と、現場ですぐに使えるレベルの詳細な実践を通じて、現場で必要とするカフカ・コネクトベースのデータ連動およびデータパイプライン構築の専門家に成長させていきます。 。

学習した受講者のレビュー

5.0

MinKyu Song

Kafka coreの講義に続いてコネクトの講義まで完了しました。やはり非常に素晴らしい講義でした。残念な点があるとすれば、最新バージョンでは一部のパラメータ値を修正しないと実習ができない点ですが、講義ではこの該当部分もすべて説明が含まれて進行されるので大きな問題はありません。良い講義を作ってくださり、知識を共有してくださりありがとうございます。

5.0

행복한 족제비

韓国最高のKafka講座

5.0

잉여인간

講義資料がよく準備されていて、 実習するにあたって、特に問題はありませんでした。 とても楽しく受講できました。

カフカコネクト主要コンポーネントのコアメカニズム

CDC(Change Data Capture)の理解と実務適用技術

MySQLデータの複製とChange Data Capture(CDC)の理解と実践の適用方法

Debezium CDC Sourceコネクタの重要なメカニズムと特長

Debezium CDCソースコネクタを使用したRDBMS間のデータ連携

Debiziumコネクトベースの連動システム構築ノウハウ

JDBCベースのSourceコネクタとSink Connectorの環境設定と駆動

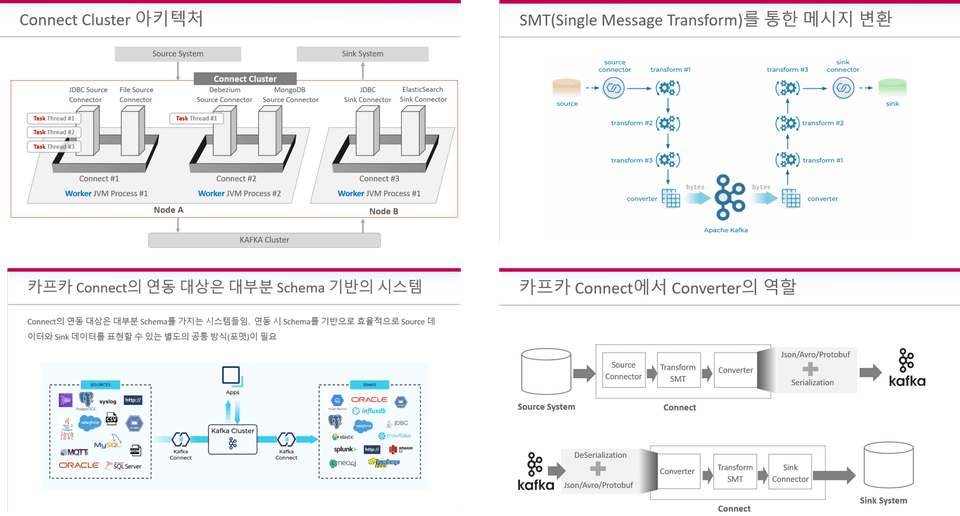

メッセージ変換のためのさまざまなSMTクラスの適用

REST APIを使用したコネクト管理

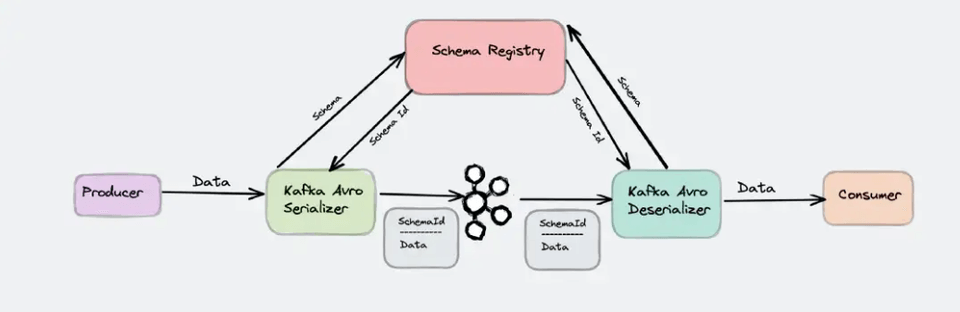

スキーマレジストリ(Schema Registry)の活用とコネクトとの統合

REST APIを使用したスキーマ・レジストリの管理

Apache Kafkaの実務のためのコネクト、

原理から実務応用までしっかり!

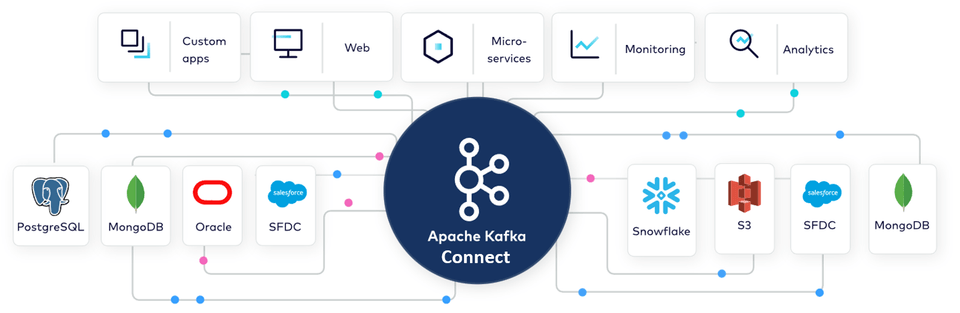

Kafka Connectは、別のコーディングを実装せずにすでに作成されたコネクタを介して、さまざまなシステム間のリアルタイムデータ連携を簡単かつ迅速かつ確実に構築できます。

海外ではすでに多くの企業がカフカコネクトを導入しており、国内でもカフカコネクトを異機種データシステム間の統合および転写データパイプライン構築に活用しながら、カフカおよびカフカコネクトに対する実務力量を備えた人材に対する需要が増えていますが、残念ながらカフカコネクトに関する学習資料はまだ欠けています。本/資料/講義だけが閲覧できるため、実務で望む程度の実戦能力を備えた人材を養成しにくいです。

詳細

メカニズムの説明

実務レベル

さまざまな例

問題の解決

部屋までOK

この講義は今までどんな講義や本でも触れられなかった、詳細で実践的なレベルでカフカコネクトを扱っています。

大部分の企業の重要なデータシステムは、RDBMSです。

多くの企業がCDCベースのコネクトを扱うことができる人材を求めています。

コネクトクラスター、Connector、SMT(Single Message Transform)、Converterなどのコア基盤知識を詳細な説明と実習を通じて自由自在に活用できるレベルで体得させます。

SpoolDir Source、JDBC Source/Sink、Debezium Source Connectorなど、RDBMS運用環境に適用できるさまざまなConnectorの環境設定パラメータと内部メカニズム、そして様々な適用実習を通じて、カフカベースの実戦データ連動システムを構築するのに役立ちます。

Debezium CDCソースコネクタについて多くのことを説明しました。

コネクトだけでなく、Avroおよびスキーマレジストリを介したスキーマデータの転送と集中管理、特に実務で重要に扱われる必要があるスキーマ互換性について詳しく説明します。

ConnectとSchema Registryの主要要素を、さまざまなREST APIを介して作成/変更/削除/管理する方法を学びます。

約200ページ分の講義教材を受講生の皆様にお届けします。

カフカサーバーOSとしてOracle(Oracle)VirtualBox VMベースでUbuntu Linux(Ubuntu Linux)20.04を使用していますが、仮想マシンベースで動作するため、Windows / macOS環境の両方で構成できます。

VirtualBoxはWindows/macOS環境でほぼほとんどインストール可能ですが、Macの場合は最新のM1モデルからVirtualBoxがインストールされないため、UTMなどの仮想環境を利用してUbuntuをインストールする必要があります。

Kafkaは、Apache KafkaではなくConfluent Kafka Community Editionバージョン7.1.2を使用しています。

コンフルエントは、カフカを作ったコア人材が主軸となった企業で、企業顧客向けにパフォーマンスと利便性の面でより向上した企業向けカフカを提供しています。インフラの構築とメンテナンスの負担を軽減し、より迅速な開発を支援します。

Spooldir Source Connectorのようにファイルデータの連動も実習として提供しますが、ほとんどのコネクト実習連動はRDBMS間のデータ連動を主軸とします。

特に、SourceとSinkはどちらもMySQL DBで同じ実習が多く、SourceはMySQL、SinkはPostgreSQLの実習も一緒に行います。

完全な練習環境構成では、20〜30 GBのストレージ容量、4 GB以上のRAMを備えたPC環境が必要になる場合があります。

Q. なぜカフカコネクトを学ぶべきですか?

カフカコネクトは、カフカベースのデータ連携のための重要なコンポーネントです。

カフカコネクトは、120以上の多様なConnectorを通じて、Oracle、MySQL、PostgreSQLなどの代表的なRDBMSだけでなく、MongoDB、ElasticSearchなどのNoSQL、RedShift、SnowFlake、Vertica、TeradataなどのDWシステムなど、さまざまな異機種データシステムを相互接続するために使われています。

別途のコーディングの実装がなくても、カフカコネクトを通じて容易に異機種データシステムを相互連動/統合することができ、特にCommunity licenseを介した連動S/Wコストの削減とCDCベースで大容量データの遅延時間のないリアルタイム連動などのメリットで、多くの企業でその使いやすさと活用度が大きくなっています。

本講義を通じてカフカコネクトをよく身につけるようになれば、企業が望むカフカ専門の人材でさらに伸ばすことができます。

Q. 以前の講義であるカフカ完璧ガイド - コア編を聴くべきですか?

以前の講義であるカフカパーフェクトガイド - コア編を受講する方が良いですが、受講しなかったとしても、カフカの基本であるBroker、Producer、Consumerの概念がよく確立されており、カフカのメッセージの送信と読書を適用してみた経験がある方なら十分に本講義を聞くことができます。

Q. 講義受講にはRDBMS経験が必要ですか?

残念ながら、この講義では3ヶ月以上のRDBMS経験が必要です。

基本的にRDBMSテーブルとカラム変更生成程度だけ理解してもほとんどの講義実習が可能ですが、CDCやRDBMS複製などは講義でその内容を詳しく説明することにもかかわらず、RDBMSに対するある程度の経験がなければ実習が難しく感じられます。

学習対象は

誰でしょう?

カフカコネクトの内部メカニズムを確実に理解し、実務に応用したい方

転写データパイプラインの構築とCDCベースのデータアーキテクチャの理解を望むデータエンジニアまたはアーキテクチャ

JDBCまたはDebezium CDC Connectorの操作が必要なDBAまたはシステム・オペレーター

運用DBのリアルタイム同期を通じたETLとDB連動を悩むDW開発者

マイクロサービスベースのアーキテクチャ構成におけるCDCベースのデータ連携方式を考える開発者とアーキテクト

前提知識、

必要でしょうか?

Kafka Broker、Producer、Consumerの基礎知識

3ヶ月以上のRDBMSの開発または運用経験

27,469

受講生

1,455

受講レビュー

4,052

回答

4.9

講座評価

14

講座

(元) エンコアコンサルティング

(元) 韓国オラクル

AIフリーランスコンサルタント

『Python機械学習完璧ガイド』著者

全体

147件 ∙ (24時間 35分)

講座資料(こうぎしりょう):

1. 講座紹介

07:11

2. 講義実習コードと教材紹介

02:22

4. 実習環境の構築概要

02:40

12. Kafka を起動する

11:10

13. Kafka サーバー 環境設定

12:35

29. コンバーターの理解

08:32

35. kafkacat 紹介

03:34

36. kafkacat 使用方法 実習

19:46

全体

32件

4.9

32件の受講レビュー

受講レビュー 5

∙

平均評価 4.2

修正済み

5

Kafka coreの講義に続いてコネクトの講義まで完了しました。やはり非常に素晴らしい講義でした。残念な点があるとすれば、最新バージョンでは一部のパラメータ値を修正しないと実習ができない点ですが、講義ではこの該当部分もすべて説明が含まれて進行されるので大きな問題はありません。良い講義を作ってくださり、知識を共有してくださりありがとうございます。

お、ついにコネクト講義まで完了されたんですね。講義への褒め言葉までいただき、本当にありがとうございます。

受講レビュー 1

∙

平均評価 5.0

受講レビュー 4

∙

平均評価 5.0

受講レビュー 4

∙

平均評価 5.0

受講レビュー 3

∙

平均評価 5.0

5

良いレビューをいただき、本当にありがとうございます ^^

星だけつけたのにコメントをいただけるとは思いませんでした。ありがとうございます。初めて触れる人も理解しやすい本当に良い講義を通じてたくさん学びました。:D

知識共有者の他の講座を見てみましょう!

同じ分野の他の講座を見てみましょう!

期間限定セール、あと5日日で終了

¥54

30%

¥12,114