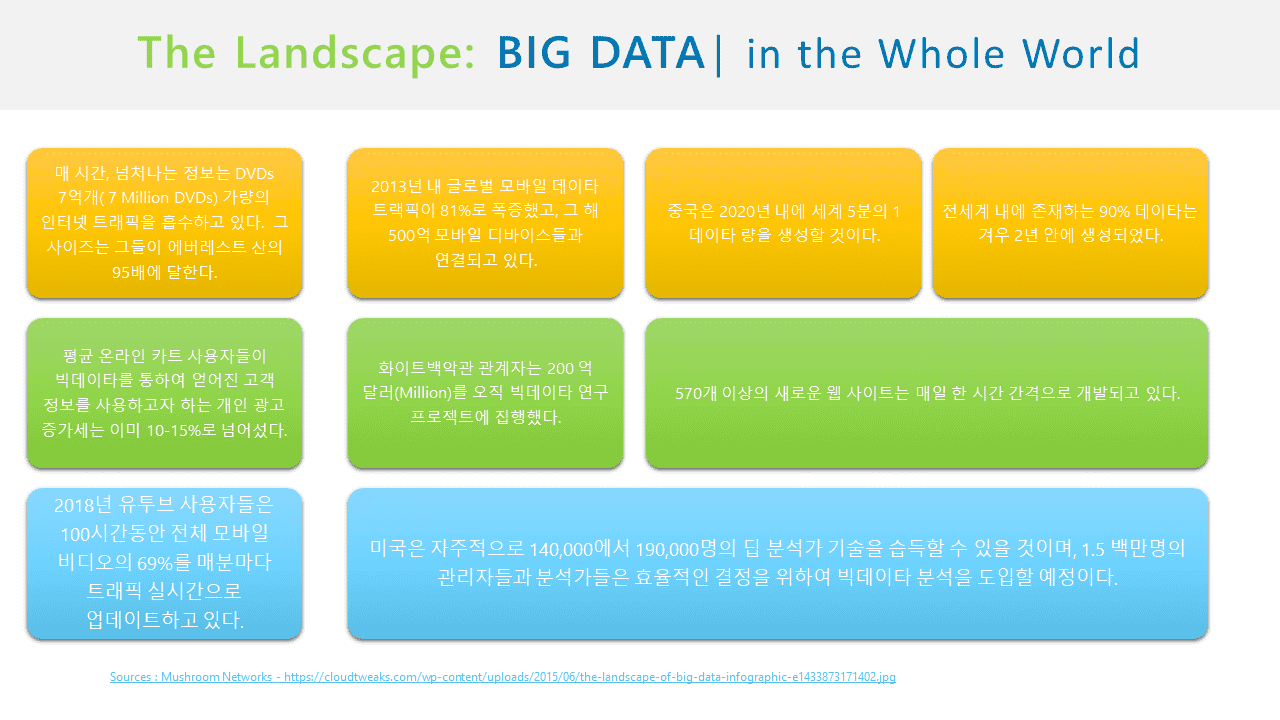

まさにビッグデータ時代! 👨💻

データサイエンスの中心、大勢はハドゥプ!

複数のIT大企業、ソーシャルメディアサービスなどで、ビッグデータの分析と処理にHadoop(Apache Hadoop)を先取りして使用しています。 Hadoopは、大量のデータを少ないコストで処理できるように作られたJava言語ベースのフレームワークで、大規模なデータセットを分散保存して処理します。ところで、そのようなHadoopを通じてビッグデータの専門家レベルのクラス に上がることができたらどうでしょうか。

企業はデータ分析を通じて新しい市場を開拓し、希少な価値を与え、新しい消費者に必要な情報をリアルタイムで提供できる快感を与えることができるようになります。中小企業 またビッグデータは必ず取り扱うべき必須事項であるだけに、ビッグデータ関連職務で就職/転職を夢見る方には 朗報ではありません。

BigData with Hadoop

Google、Yahoo、Facebook、IBM、Instagram、Twitterなどビッグデータ分散型システムインフラストラクチャ を構築します。

このレッスンでは、ビッグデータの用語を 理解し、オープンソフトウェアHadoopを介してビッグデータを扱うプロセス を間接的に体験します。この講義を通じて、受講生の皆さんはビッグデータテクノロジー(Big Data Technology)の世界、そして第4次革命の世界を同時に経験できるようになります。

Hadoopは一般的なソフトウェア 、Hadoop 3.2.1バージョン を通じてビッグデータを扱います。 ビッグデータの理解から Hadoopの使い方まで 一度にOK。

ビッグデータ不可欠な理解

Hadoopの

Hadoopによるビッグデータ処理 学習チュートリアル こんな方におすすめです! もちろん、ここに該当しない方も歓迎します。 (初心者は2倍に歓迎します✌)

就職/転職

Java / Python 経由

興味と興味

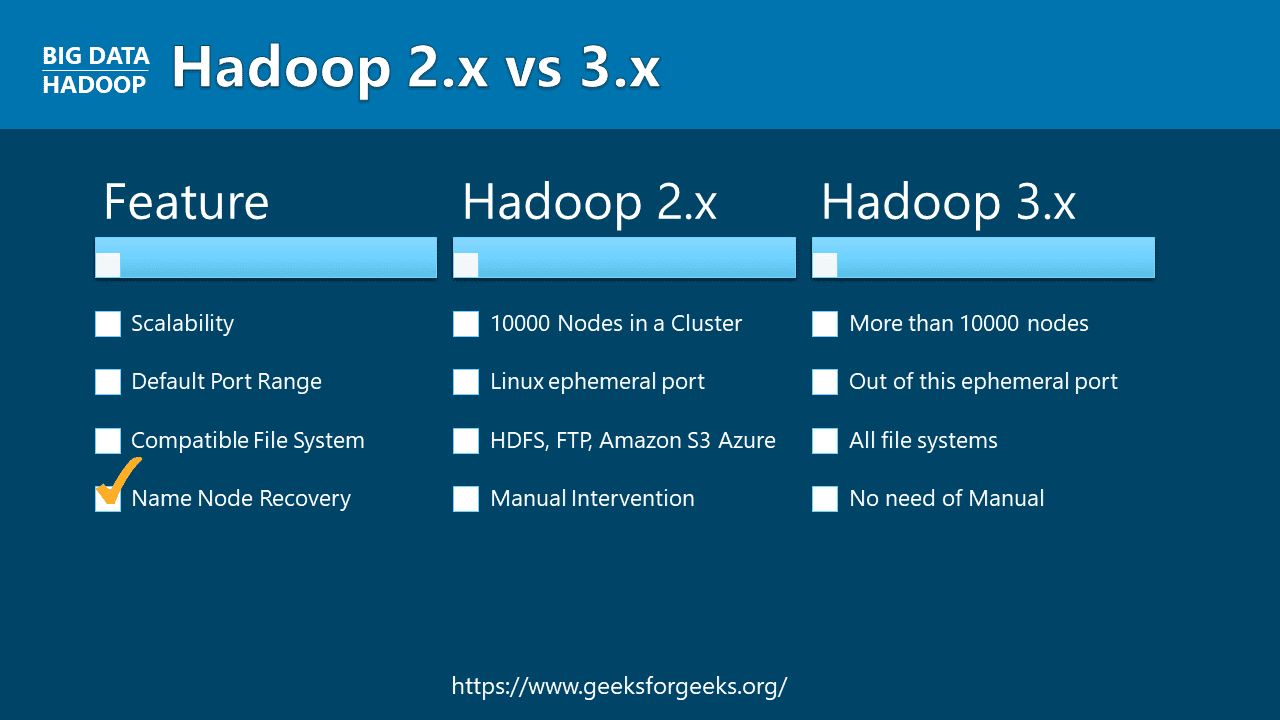

Hadoop 3.xバージョン データ環境などプレーヤーの知識として、Java プログラミング言語の基礎、ビッグデータ 、および仮想マシン/データセットに関する用語の 知識とLinux Ubuntu の基本的な理解が必要です。 次の内容 学習します。 1. 仮想化技術の課題とゲストオペレーティングシステムの理解 サーバー統合に有利な仮想化技術を学び、OSレベルの仮想化を介して1つのOSに複数のサーバーを分離する方法に基づいて学びます。 Linuxに適用できる仮想化方式であるオープンソースソリューションUbuntuを通じて、誰もが挑戦して大量のサーバーを製作運営することになるでしょう。さらに、ゲストオペレーティングシステムの知識はもちろん、大量のサーバーを通じてビッグデータを分散技術に変えることになり、広がる多量の技術経験を蓄積できるようになります。サーバー仮想化を使用して、1つの物理サーバー上またはオペレーティングシステムで非常に効率的な仮想マシンの難しいオペレーティングシステムを体験することができます。

ビッグデータの定義と実際の適用例について学びます。 企業が好むデータ処理ソフトウェアであるHadoopに関する用語を理解してください。 2. Ubuntu 20.04 LTSの上にHadoopをインストールし、命令を操作する方法 フロントエンド(FrontEnd)開発者がWebアプリケーションを開発する際に自然に遭遇するLinux CLI(Command Line Interface)方式のツールを使用する基礎的な方法から、Hadoopを扱うLinuxターミナルを自然に学ぶ予定です。もちろん、非 Windows ベースの GUI 環境で原도のように Ubuntu を使用するための前提事項を学びながら、セルの設定ファイルなどの Linux システムの理解を超えて中級者方向に自然に導きます。

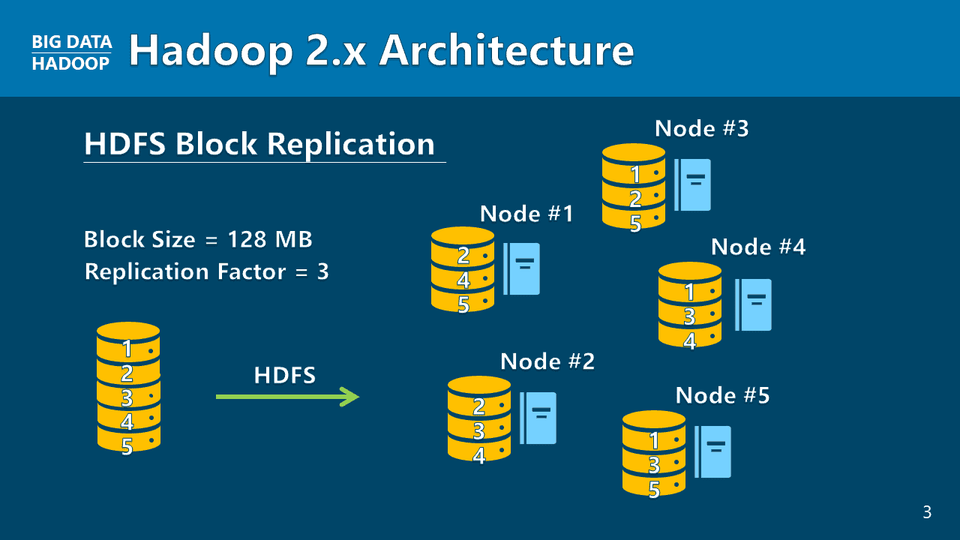

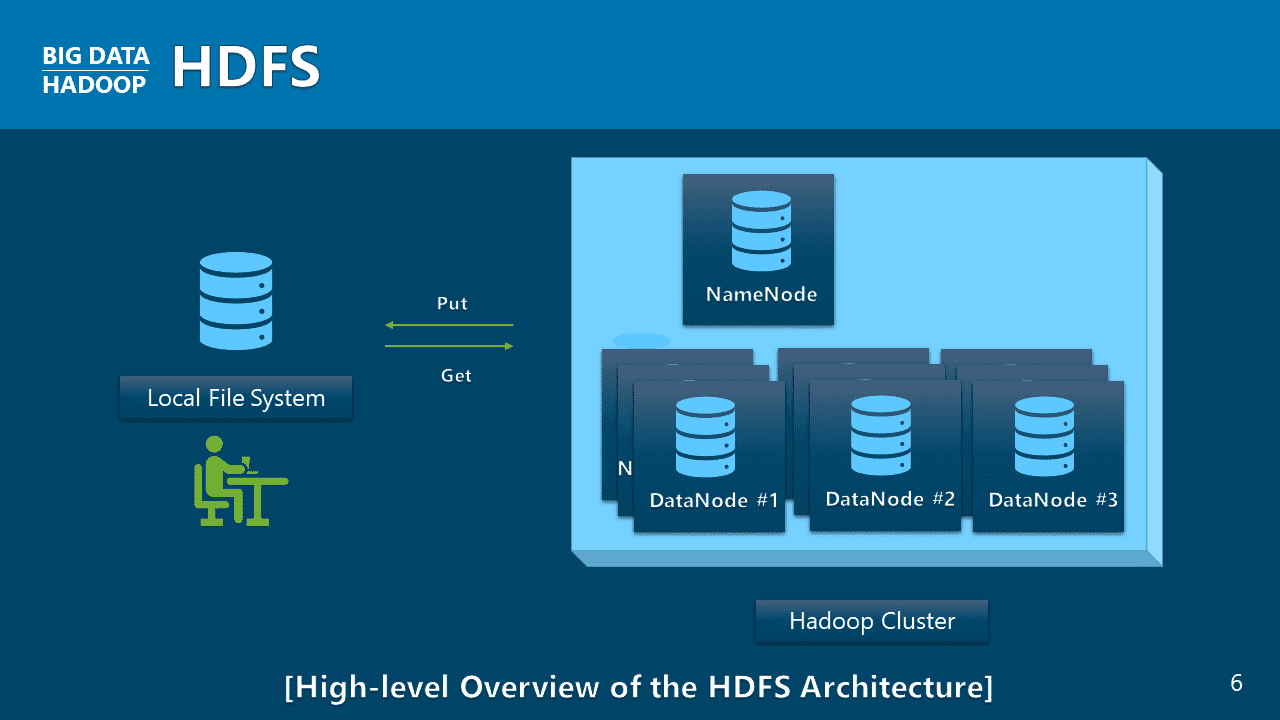

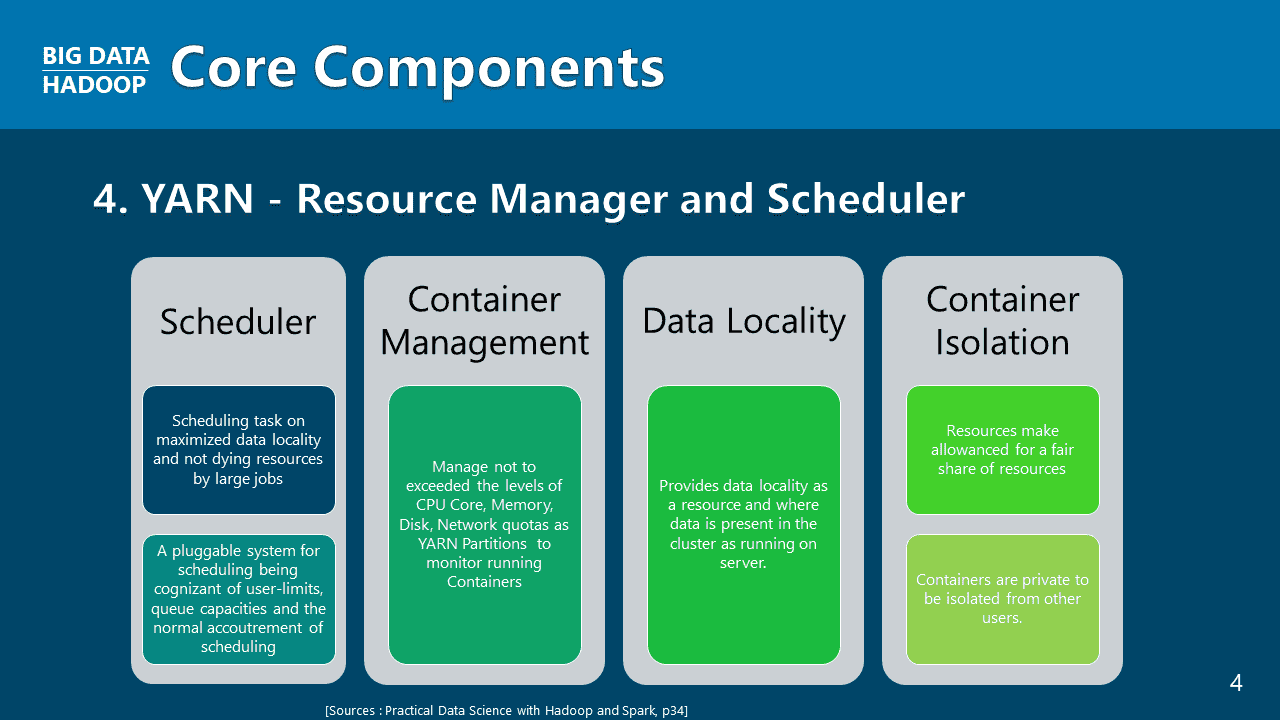

Windows 10ベースのノートブックに仮想マシンとしてLinux(Ubuntu 20.04 LTS)をインストールして設定します。 Linux仮想マシンの上にHadoop 3.2.1バージョンをインストールします。 3. Hadoop 3.2.1最新の方向ガイドとコアアーキテクチャ構造について 非定型データ処理のためのビッグデータの始まりは、GoogleのファイルシステムのモデルであるHadoop分散ファイルシステム(HDFS)とMapReduce(MapReduce)、そしてYan(YARN)というクラスタ拡張とリソース管理の理解です。 Hadoop Version 1、2、3のアーキテクチャ構造について一つ一つ見て、Hadoop技術の歴史がどんなものか受講生の皆さんに絵を描きます。

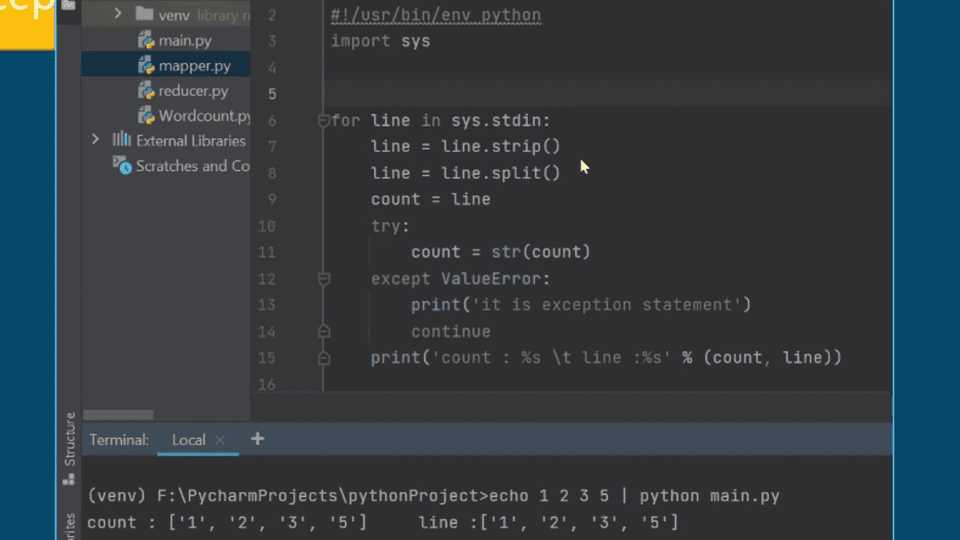

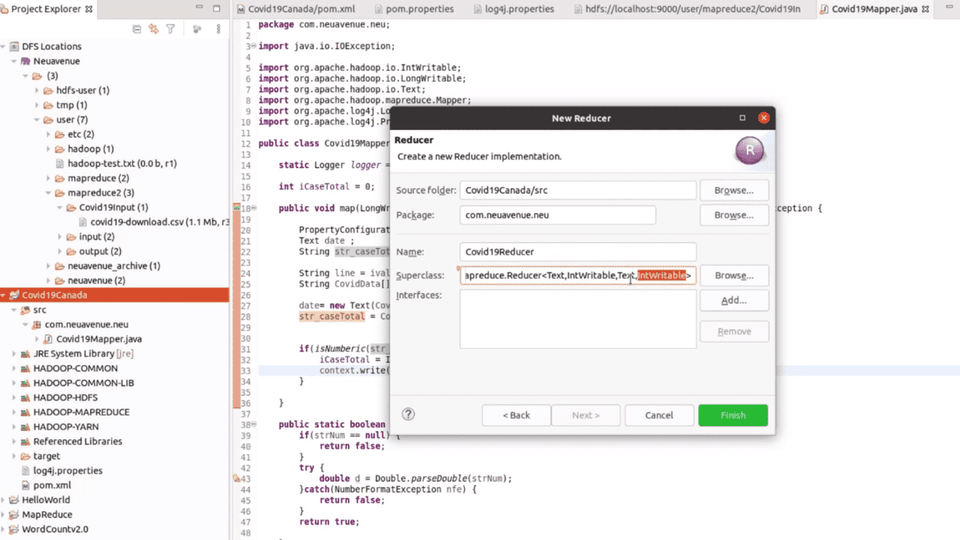

Hadoop分散ファイルシステム(HDFS)を理解して連携してみてください。 マップリデュース(Map/Reduce) フレームワークの原理を理解し、これに基づいてデータを分析してみます。 4. HDFSシェル操作ガイドとJava / PythonでMapReduceアプリケーションを作成する データ操作に使われる技術は多様ですが、ビッグデータ分析の基礎はマップリデュースアプリケーション制作にあります。プログラミング言語Python(Python)で、基本的なWordCount MapReduceアプリケーションからEclipseベースのJava言語でCOVID-19アプリケーションを作成するまで、さまざまなビッグデータマップリデュースアプリケーションの作成は、選択を超えて必須に進むべき方向を提示します。

JavaでHadoopを連動し、アプリケーションを実装してみます。 PythonでHadoopを連携し、アプリケーションを実装してみます。 Python Map/Reduce WordCount Application Java Map/Reduce WordCount Application 予想される質問Q&A! Q. ビッグデータとは何ですか? Hadoopを使用するときは、その定義が必要ですか?

はい、もちろんHadoopを扱うときは必ずビッグデータの簡単な定義と理解を求めます。もちろん、完璧で深いレベルの熟知を必要とするほどではありません。ただ、Hadoopを扱う際に必ず必要な理解度を求める形でしょう。

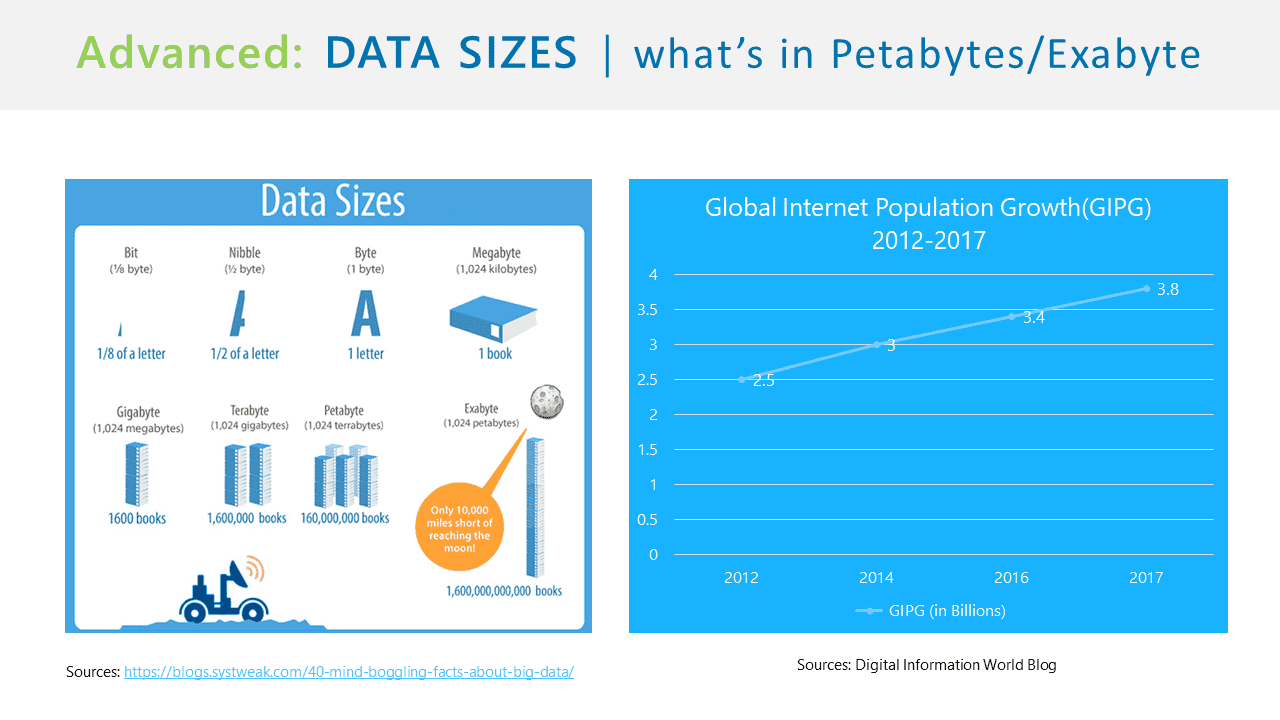

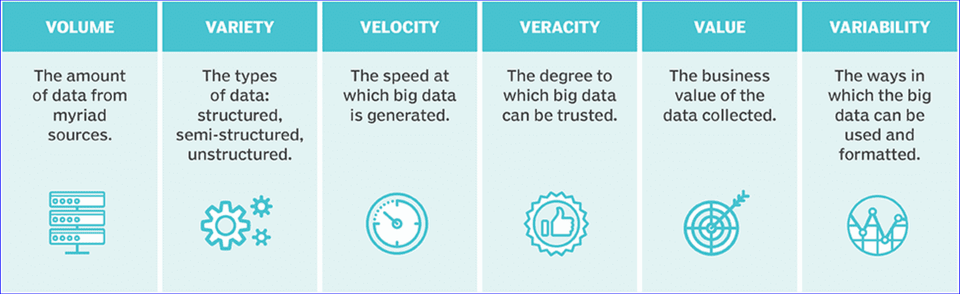

ビッグデータはHadoopツールを備え、非常に大きなデータセットを扱います。このデータセットは、多数の企業が扱うさまざまなパターンやトレンドを特定するために分析する基礎データです。人間の社会的行動とパターン、そして相互作用の中で繰り広げられる人類の価値創造と関連が立っています。

画像ソース:TechTarget (オリジナルショートカット)

Q. Hadoopとは何ですか?コンポーネントは何で、Hadoopスタックは何ですか?

テラバイトを超えてペタ(Petta/Zettabyte)に至る大規模ソーシャルサイトのデータを 処理しなければならない使命をHadoopが助けています。 Hadoop Stackとは、このようなビッグデータを扱うオープンソースのフレームワーク方式です。

単に「Hadoop」は「Hadoop Stack」と呼ばれます。安価で日常的なコマディティハードウェアを使用してクラスタを構築し、その膨大なサーバーの集合体であるクラスタ内で大容量プロセスを処理するのを助けるのは、HadoopとHadoopスタックです。 Hadoopスタックは「単純なバッチプロセス」とも呼ばれ、Javaベースの「分散コンピューティングプラットフォーム」です。だから個人が望むだけのデータを周期別にバッチを回して処理しながら、データを所望の形に加工分散して結果値を算出するのです。

Q. プログラミングの知識が必要ですか?

プログラミングの知識やコードを書く経験がなくても大丈夫です。 JavaやPythonを初めて体験すると考えて教えるように、深い理解をもとに授業を進めます。講義に書かれた文書は英語で書かれていますが、従うことには支障がないように韓国語で講義します。たまに英語で説明をするのですが、高校レベルであれば解釈できないでしょうか? (私の低い英語力でも夢を叶えたようです。)

Q. Hadoopを扱うのにビッグデータはどのくらい関連がありますか?

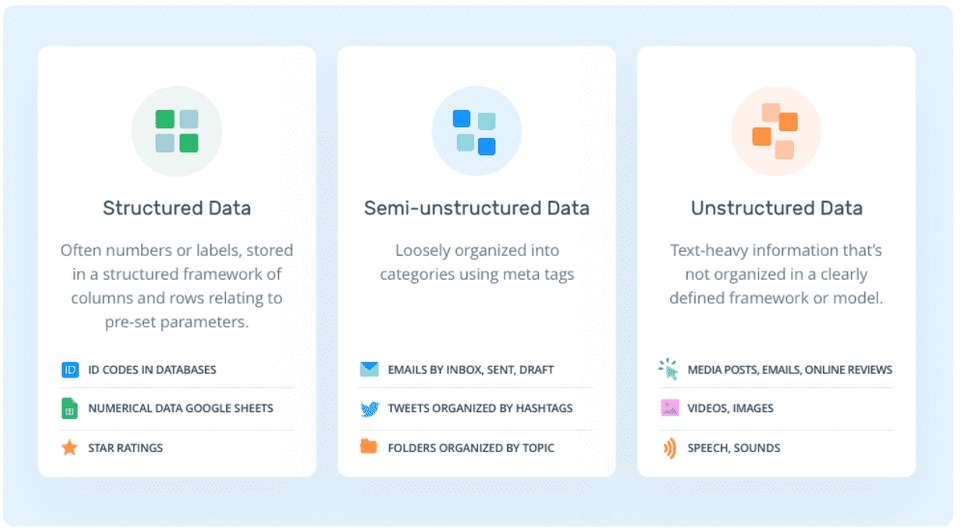

この講義は当然ハドゥプを扱っています。単にRDMSというOracleやMSSQL、あるいはMYSQLを越えて大容量処理をはじめ、データ処理速度の問題、低コスト効果という企業の必須要素を創出したいと思います。特にソーシャルを扱わなければならない企業、つまりすぐに行と列に基づくデータRDMSで扱うリレーショナルデータを扱うストラクチャデータ(Structured data)だけでなく、画像、オーディオ、ワードプロセスファイルそのものを扱わなければならないアンストラクチャデータ(Unstructred data)などもハドゥが扱います。

サービスストラクチャーデータを扱うときは、Email、CSV、XML、およびJSONなどのWebサーバーとの通信とデータ連携に関するデータを言っています。 HTML、Web Sites、NoSQL Databasesもここに含まれています。もちろん、EDIというビジネス書類関連の計算移動させるコンピュータ対コンピュータ間の移動処理問題を扱う際に使うデータセットの累積もやはりここに属します。

画像ソース:MonkeyLearn Blog (オリジナルショートカット)

Q.どの程度レベルまで内容を扱いますか?

このレッスンでは、Ubuntu(Ubuntu)20.04 LTSベースにHadoop(Hadoop)3.2.1をユーザーが直接インストールするのに役立ちます。 UnixやLinuxの経験がなくても自然に追いつくと、Linuxを基につながるインストールのヒントとLinuxオペレーティングシステムを自然に熟知することになります。また、Hadoopが扱うCLI言語やユーザー言語を習得する基本的な部分を超えて、Googleが持っている技術であるDFS and MapReduce技術に慣れるのに役立ちます。 YARN(ヤン)についての理解は基礎理論だけを持つことになります。 後にHadoop 3.3.0中級コースでクラスターを設置しながらヤンについてのより深い学習を期待してください。

Q. Ubuntu 20.04 LTSを練習環境として使用する理由はありますか?

Ubuntuは無料で利用可能で、LTS(Long-Term Service)を通じて長期サービスのサポートを夢見ている企業を対象に、HadoopをLinuxにインストールしながら、自然に企業が要求するオペレーティングシステムや開発環境を構築するのに役立ちます。同じ環境内でEclipseやIntelligentを使用することで、ビッグデータを扱うデータサイエンスの夢を実現するのに役立つ時間があります。

UbuntuはWindowsオペレーティングシステムのインストールと運営です。

![[リニューアル] 初めてのMongoDB(モンゴDB) と NoSQL(ビッグデータ) データベース ブートキャンプ [入門から活用まで] (アップデート)講義サムネイル](https://cdn.inflearn.com/public/courses/324183/cover/fbe9f0cc-4c42-4435-b855-f283f6932415/324183.png?w=420)

![[無料]基礎テキストマイニング:アプリレビュー分析 with Python(40分完成)講義サムネイル](https://cdn.inflearn.com/public/courses/331163/cover/74cc657a-a8f9-4a78-8edb-0d5fcd4c4c75/331163.png?w=420)

![[資格試験対策] 国家技術 経営情報視覚化能力(筆記)講義サムネイル](https://cdn.inflearn.com/public/files/courses/336327/cover/01jytyqa2egrzn52a7m57fntzk?w=420)

![[管理コース#3] DE、DBA(SSIS、SSAS、MachineLearning、BI、ETL)講義サムネイル](https://cdn.inflearn.com/public/courses/329784/cover/c5e6543b-72c3-4471-b43f-15b9002e65ed/329784-eng.png?w=420)