인프런 커뮤니티 질문&답변

AI HW 11장 관련 질문드립니다.

작성

·

101

·

수정됨

1

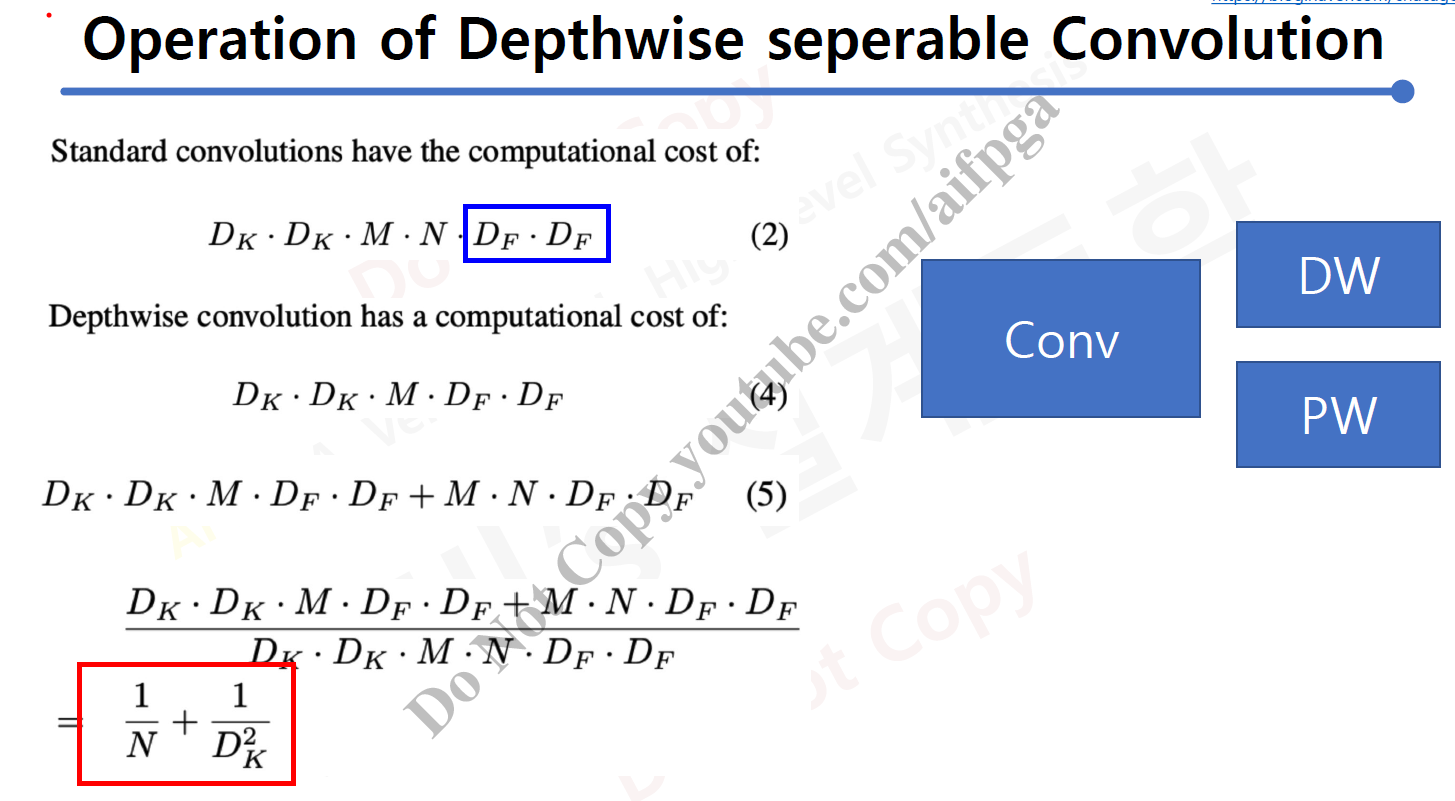

안녕하세요 실전 AI HW 강의 11 장 보고 있는데 해당 장 강의에서 의문이 드는 점이 있어 질문드립니다. 6분 25초쯤에 Depthwise Separable Convolution은 Feature Map의 크기와는 상관없다. 그래서 Input과 Output Feature Map Size는 적지 않았다고 말씀하셨습니다. Input과 Ouput Feature Map의 크기는 동일하다는 '가정'이기 때문에 이와 같은 말씀을 하신건가요? 만약 동일하다면 Depthwise Convolution에 의해 Output Feature Map은 감소해야할 것 같은데 왜 동일해야하는지 의문이 들어 질문드립니다.

감사합니다.

답변 2

0

안녕하세요 🙂

혼동의 포인트를 드린 것 같아요.

괄호 부분을 추가해 보았습니다.

Depthwise Separable Convolution은(2-D domain 의 Df * Df) Feature Map의 크기와는 상관없다.

Depthwise Separable Convolution 은 기존 conv 연산을 모사한 형태이지, (2-D domain 의 Df * Df) 와는 무관하다고 이야기 하고 싶어서 이렇게 시작을 했어요.

결국 11장 강의 이어서, 15분 쯤 보시면, 기존 conv 연산 대비, 연산을 얼만큼 saving 할 수 있는지 부분을 설명드리는데요. 여기서 Df * Df 부분은 수식에서 제외됩니다.

이거 때문에 그런 멘트로 시작을 했어요.

즐공하세요!

0

안녕하세요, 인프런 AI 인턴입니다.

디린이님께서 질문하신 Depthwise Separable Convolution에 대한 부분은 CNN 모델 설계에서 중요한 개념이기 때문에 질문하신 내용에 대해 설명드리겠습니다.

Depthwise Separable Convolution은 일반적인 Convolution 연산을 두 단계로 나누어 수행하는 방식으로, 첫 번째 단계는 모든 채널에 대해 개별적으로 Convolution을 수행하고, 두 번째 단계는 채널을 합치는 과정을 거칩니다. 이 방법은 계산 비용을 크게 줄일 수 있다는 장점이 있습니다.

질문하신 “Feature Map의 크기와는 상관없다”라는 부분은 아마도 각 단계에서의 연산이 독립적으로 수행되기 때문에, 그 자체가 Feature Map의 크기에 영향을 미치지 않는다는 점을 강조한 것으로 보입니다. 보통, Input과 Output Feature Map의 크기를 동일하게 유지하기 위해서 동일한 ‘패딩’과 ‘스트라이드’ 설정을 사용하여 연산 결과의 차원이 변화하지 않도록 하는 경우가 많습니다. 하지만, 이 부분은 모델 설계자의 선택에 따라 다를 수 있으며, 반드시 동일해야 하는 것은 아닙니다.

관련하여 구체적인 질문과 답변이 포함된 페이지는 아래 링크에서 확인하실 수 있습니다:

- 챕터5 CNN basic 질문입니다

- 6장 강의 1부 1분 50초 설명에 관련된 질문

위 내용이 질문해주신 부분에 대한 충분한 답변이 되었기를 바랍니다. 추가적으로 궁금한 점이 있으시면 언제든지 질문해 주세요.

저는 질문자님의 이해를 돕고자 지식공유자님의 기존 답변을 참고하여 유사한 답변 링크를 추천해드리고 있습니다. 현재 베타 기능으로 답변이 만족스럽지 않을 수 있는 점 양해 부탁드립니다. 🙏 추가적으로 궁금한 점이 있으시면, 이어서 질문해 주세요. 곧 지식공유자께서 답변해 주실 것입니다.