Thống kê học trí tuệ nhân tạo dành cho người không chuyên ngành

arigaram

Thấu hiểu bản chất của thống kê cơ bản cần thiết cho việc phát triển và ứng dụng trí tuệ nhân tạo mà không cần đến một công thức hay một dòng mã nào.

入門

AI

Giải thích chi tiết về các mô hình ngôn ngữ đa dạng được phát triển trong quá trình từ khởi đầu của công nghệ xử lý ngôn ngữ tự nhiên cho đến các mô hình LLM hiện đại nhất.

18 học viên đang tham gia khóa học này

Độ khó Nhập môn

Thời gian Không giới hạn

Quá trình phát triển của mô hình ngôn ngữ và nguyên lý của từng mô hình ngôn ngữ

Nguồn gốc của NLP

# Cấu trúc và Nguyên lý của Transformer Transformer là một kiến trúc mạng neural được giới thiệu trong bài báo "Attention is All You Need" (2017), đã cách mạng hóa lĩnh v

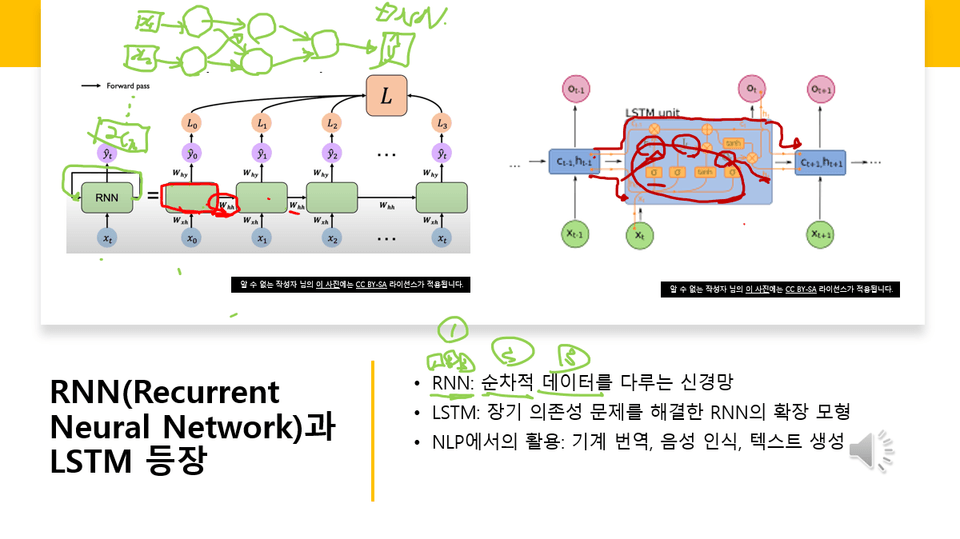

# Cấu trúc và Nguyên lý của RNN, LSTM ## RNN (Recurrent Neural Network - Mạng Nơ-ron Hồi quy) ### Cấu trúc

Nguyên lý của cơ chế Attention

Hiện tại khóa học đang trong quá trình hoàn thiện. Có nhược điểm là bạn sẽ phải chờ đợi lâu cho đến khi khóa học hoàn thành (mặc dù sẽ có các bổ sung thường xuyên). Vui lòng cân nhắc điều này trước khi quyết định mua.

10 tháng 12 năm 2025

Tôi đã công bố mục lục trước với kế hoạch bổ sung thêm nhiều bài học mới. Đã đánh dấu là [Phiên bản 2].

Tôi đã đánh dấu các lớp học hiện có là [Phiên bản 1]. Tôi dự định sửa đổi các lớp học hiện có. Khi nội dung được cập nhật thành phiên bản sửa đổi, tôi sẽ ghi [Phiên bản 2] trong tiêu đề lớp học.

Khóa học này là một quá trình học tập toàn diện về dòng chảy phát triển của mô hình ngôn ngữ, từ nghiên cứu ban đầu về xử lý ngôn ngữ tự nhiên cho đến các mô hình ngôn ngữ lớn (LLM) hiện đại. Bạn sẽ hiểu một cách có hệ thống về sự thay đổi công nghệ bắt đầu từ thời đại dựa trên quy tắc, trải qua mô hình ngôn ngữ thống kê, mô hình dựa trên mạng nơ-ron, cuộc cách mạng Transformer, cho đến LLM tập trung vào đa phương thức, tối ưu hóa và ứng dụng ngày nay.

Hiểu được toàn bộ quá trình phát triển của mô hình ngôn ngữ.

Nắm bắt đặc điểm của các mô hình cốt lõi theo từng thời kỳ (RNN, LSTM, Transformer, BERT, GPT, v.v.).

Tổ chức có cấu trúc các xu hướng công nghệ và nghiên cứu LLM mới nhất.

Hiểu về công nghệ tối ưu hóa LLM và cách ứng dụng thực tế.

Nhìn nhận một cách phê phán về hướng đi và những hạn chế của nghiên cứu LLM trong tương lai.

Khóa học bao gồm tổng cộng 6 phần, mỗi phần được cấu trúc xoay quanh dòng chảy thời đại và trục nghiên cứu.

Phần 1: Nguồn gốc và sự phát triển ban đầu của NLP

Phần 2: Nghiên cứu mô hình ngôn ngữ trước Transformer

Phần 3: Cuộc cách mạng Transformer và các Mô hình Ngôn ngữ Lớn

Phần 4: Công nghệ LLM mới nhất và xu hướng nghiên cứu

Phần 5: Kỹ thuật tối ưu hóa hiệu suất LLM và tối ưu hóa mô hình

Phần 6: Ứng dụng LLM · Tích hợp hệ thống · Triển vọng tương lai

Trong phần này, bạn sẽ học về điểm khởi đầu của NLP và nền tảng của các mô hình ngôn ngữ ban đầu.

NLP giải quyết những vấn đề gì và bắt đầu như thế nào

Cách hệ thống dựa trên quy tắc được cấu trúc như thế nào và tại sao nó lại gặp phải giới hạn

Cách mô hình ngôn ngữ thống kê (n-gram LM) ra đời như thế nào

Sự xuất hiện và ý nghĩa của các corpus quy mô lớn ban đầu như Brown Corpus, Penn Treebank

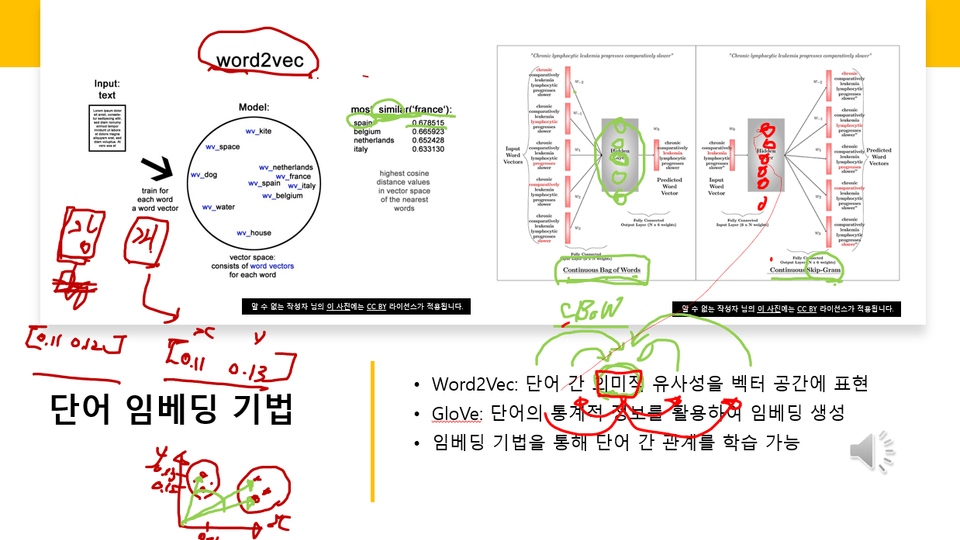

# Khái niệm về Giả thuyết Phân phối (Distributional Hypothesis) và Cách áp dụng trong NLP Giả thuyết Phân phối (Distributional Hypothesis) là một trong những khái niệm nền tảng quan trọng nhất trong Xử lý Ngôn ngữ Tự nhiên (NLP) hiện đại. Giả thuyết này đưa ra ý tưởng rằng ý nghĩa của một từ có thể được suy ra từ

Word2Vec, GloVe và sự ra đời cùng đóng góp của các công nghệ nhúng từ ban đầu

Trong phần này, chúng ta sẽ tìm hiểu cách các mô hình dòng RNN đã thay đổi NLP như thế nào, và những hạn chế kỹ thuật trước khi có Transformer.

# Bối cảnh ra đời và nguyên lý cấu tạo của RNN, LSTM, GRU ## Bối cảnh ra đời của RNN (Recurrent Neural Network) Mạng nơ-ron truyền thống (Feedforward Neural Network) có hạn chế là không thể xử lý dữ liệu tu

# Bản chất của vấn đề phụ thuộc dài hạn (Long-term dependency)

Cấu trúc Seq2Seq đã dẫn dắt sự đổi mới trong dịch máy như thế nào

Lý do xuất hiện và hiệu quả của cơ chế Attention

Mô hình ngôn ngữ dựa trên CNN thuộc phân loại nghiên cứu khác nên không chắc chắn, nhưng học các ý tưởng chính

Tổng hợp tình hình nghiên cứu trước Transformer và hiểu về sự cần thiết của mô hình thế hệ tiếp theo

Trong phần này, bạn sẽ học về cách kỷ nguyên LLM hiện đại tập trung vào Transformer đã mở ra.

"Attention Is All You Need" - Cấu trúc và Đặc điểm của Transformer

Bối cảnh xuất hiện của Pretraining và mô hình hiểu ngôn ngữ

Khái niệm tính hai chiều của mô hình BERT, kỹ thuật MLM(Masked LM)

Dòng phát triển chính của dòng GPT (GPT–GPT-4)

Sự hình thành mô hình học tập chuẩn hóa "Pre-training → Fine-tuning"

Ý nghĩa của Quy luật Mở rộng (Scaling Laws) và Sự thay đổi Chiến lược Huấn luyện LLM

Phần này không chỉ đề cập đến cấu trúc, đặc điểm và phương pháp học của LLM hiện đại mà còn bao gồm cả mô hình dựa trên phản hồi của con người.

GPT-4, Llama, Claude và các đặc điểm chung của LLM hiện đại

Bối cảnh ra đời của các LLM mã nguồn mở (ví dụ: Llama·Mistral)

RLHF·DPO·Instruction Tuning và các công nghệ học tập tùy chỉnh theo người dùng

Cấu trúc và trường hợp sử dụng của mô hình Đa phương thức (Multimodal)

Nghiên cứu về thiên kiến, ảo giác, an toàn và các yếu tố cân nhắc về đạo đức

Phần này tập trung vào công nghệ giúp các mô hình quy mô lớn trở nên nhẹ hơn và nhanh hơn.

Lượng tử hóa (Quantization), Tỉa cành (Pruning), Chưng cất tri thức (Distillation)

LoRA·Prefix Tuning như PEFT(Parameter-Efficient Fine-Tuning)

FlashAttention và các thuật toán Attention tốc độ cao khác

Kỹ thuật giảm chi phí suy luận

Khái niệm và thách thức kỹ thuật của LLM trên thiết bị (on-device)

Các trường hợp tối ưu hóa hiệu quả trong việc áp dụng dịch vụ thực tế

Phần này giúp bạn học cách LLM được ứng dụng trong các hệ thống và dịch vụ thực tế,

đồng thời tổng hợp hướng đi tương lai với sự thừa nhận một số yếu tố không chắc chắn.

Cấu trúc và ưu điểm của Retrieval-Augmented Generation (RAG)

Nguyên lý của LLM dựa trên sử dụng công cụ như Toolformer·ReAct

LLM chuyên biệt cho các lĩnh vực như y tế, pháp lý, lập trình (Domain-specific LLM)

Mở rộng các mô hình đa phương thức như GPT-4V

# Nghiên cứu hệ thống tự trị dựa trên LLM (một phần "không chắc chắn")

Triển vọng tương lai và các điểm tranh luận về LLM (ví dụ: khả năng AGI → "không chắc chắn")

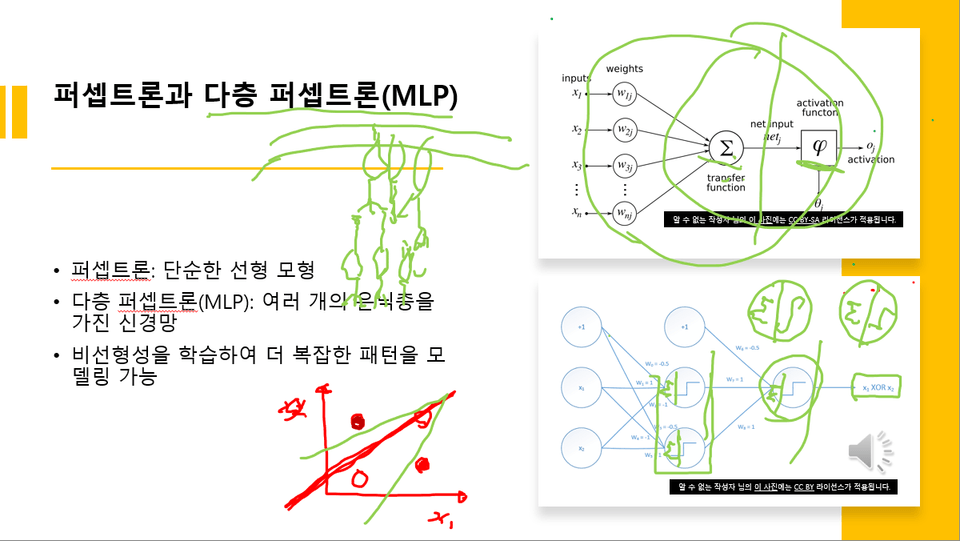

Như màn hình ví dụ bên dưới, trong khóa học sẽ sử dụng các loại sơ đồ để giải thích chi tiết các khái niệm liên quan đến LLM. Đặc biệtsẽ tập trung giải thích bằng các sơ đồ liên quan đến NLP, RNN, self-attention, transformer, LLM.

Ví dụ màn hình 1 được giải thích trong Bài học 3

Ví dụ màn hình 2 được giải thích trong Bài học 3

Tiêu đề bài giảng

Ví dụ màn hình 3 được giải thích trong bài học 3

Người học quan tâm đến Trí tuệ nhân tạo·Khoa học dữ liệu

Các nhà phát triển và nhà nghiên cứu muốn hiểu một cách có hệ thống về công nghệ NLP hoặc LLM

Những người muốn nắm bắt xu hướng mới nhất của công nghệ trí tuệ nhân tạo

Các khái niệm cơ bản về Machine Learning

Kinh nghiệm sử dụng mô hình đơn giản dựa trên Python (khuyến nghị)

Bạn có thể hiểu sâu sắc về lịch sử phát triển tổng thể của các mô hình ngôn ngữ.

Bạn có thể trang bị kiến thức nền tảng để phân tích và ứng dụng công nghệ và xu hướng LLM mới nhất.

Có thể thiết kế hướng giải quyết vấn đề, thiết kế dịch vụ và hướng nghiên cứu sử dụng LLM.

Vì đây là khóa học tập trung vào lý thuyết nên không cần môi trường thực hành riêng biệt.

Tôi đính kèm giáo án bài giảng dưới định dạng file PDF.

Lịch sử và Phát triển của LLM: Từ Nguồn gốc của Mô hình Ngôn ngữ đến Công nghệ Mới nhất

Khóa học này dành cho ai?

Những người muốn tìm hiểu về nguồn gốc, quá trình phát triển và xu hướng công nghệ của LLM

Những người muốn tìm hiểu cấu trúc mạng nơ-ron nhân tạo làm nền tảng cho LLM

Những người muốn tích lũy kiến thức lý thuyết để tự phát triển LLM

613

Học viên

31

Đánh giá

2

Trả lời

4.5

Xếp hạng

18

Các khóa học

Tôi là một người coi IT vừa là sở thích vừa là nghề nghiệp.

Tôi có nhiều kinh nghiệm trong việc viết lách, dịch thuật, tư vấn, phát triển và giảng dạy.

Tất cả

72 bài giảng ∙ (10giờ 39phút)

Tài liệu khóa học:

2.057.301 ₫

Hãy khám phá các khóa học khác của giảng viên!

Khám phá các khóa học khác trong cùng lĩnh vực!