인프런 커뮤니티 질문&답변

LLM 연결 관련 질문이 있씁니다.

해결된 질문

작성

·

99

답변 2

1

ollama 에서 어떤 모델이 좋을지는 어떤 작업을 하느냐에 따라 판단해봐야 할 문제로 보입니다. 단순히 채팅 수준의 범용적인 모델은 한글 지원이 잘 되는 Gemma3 를 추천하긴 합니다. 참고로 Gemma는 구글에서 제공하는 모델입니다. Qwen 모델도 한글 지원을 잘 하는 편이긴 합니다. 참고로 Qwen은 알리바바에서 제공하는 AI 모델입니다.

물론 llama 같은 모델에 한글을 학습시켜서 사용할수도 있지만 이런 경우는 내가 직접 퀄리티 높은 학습 데이터를 수집하고 학습시키고 하는 등의 작업을 해야 합니다. AI 자체를 공부하고 싶으신 분들은 연습삼아 해보는것도 좋긴 합니다만 일상 대화가 가능한 수준까지 학습시키려면 간단한 작업은 아니긴 합니다.

또 다른 방법으로는 사용자가 입력한 데이터를 번역 API 나 AI 를 써서 영문으로 변경하고 영문 모델을 Ollama에게 전달 후 나온 결과를 다시 한글로 번역하는 과정을 거쳐서 사용할 수도 있습니다만 이는 2-3년전에 AI 가 처음 나왔을때는 유용했는데 지금은 사실 AI 수준들이 너무 높아져서 큰 의미가 없긴 합니다. 비용적으로도 매리트가 없구요.

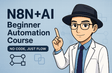

그리고 두번째로 문의하신 Ollama 사용시에 SerpAPI를 사용하지 않는 것은 Ollama를 통해서 사용하는 AI 모델들이 Tool 기능이 없기 때문입니다. 물론 모든 AI 들이 툴을 사용하지 못하는건 아니고

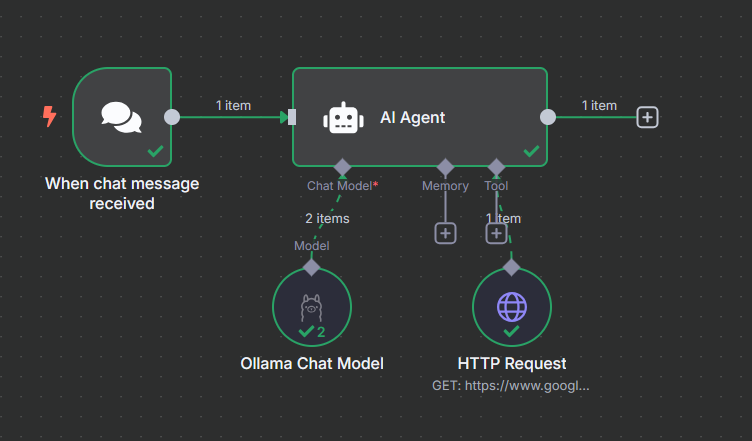

ollama에서 AI 모델 목록에 보면 그림에서 처럼 해당 AI 모델이 지원하는 내용이 나옵니다. tools을 지원하는지 thinking(추론)을 지원하는 모델인지를 알 수 있습니다.

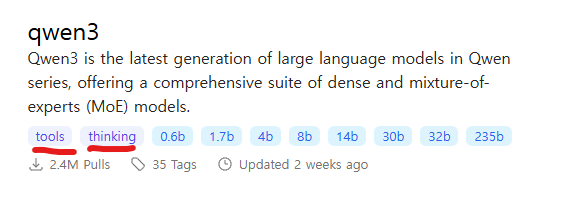

그래서 tools 기능이 지원되는 모델은 위의 그림에서 처럼 문제없이 사용할 수 있습니다.

그림에서 처럼 tools가 없으면 AI Agent에 연결된 SerpAPI 과 같은 툴을 사용할 수 없습니다. 대신 위의 그림에서 처럼 Gemma3는 vision 기능이 있는것을 알 수 있습니다. 그래서 Gemma3는 이미지를 분석할 수 있는 능력이 있다고 보시면 됩니다. 물론 사용하는 방법은 일반적으로 URL을 전달해서 사용할수는 없고 base64형태로 제공하거나 Ollama가 구동중인 도커 내부로 이미지를 복사해서 넣을 수 있게끔 환경을 설정해야 합니다.

어쨌든 Tools 기능이 없는 경우에는 노드 구성을 다르게 해서 예를 들어 AI Agent 노드 이전에서 검색을 먼저하고 검색된 결과와 사용자가 입력한 내용을 Merge하여 AI Agent 프롬프트로 몽땅 밀어넣는 형태로 구동시킬수도 있습니다. 뭐 레고 조립처럼 어떻게 조립할지 생각해보고 기획을 해보는거죠. 정답은 없습니다.

도움이 되셨길 바라며, 더 궁금하신 사항이 있으시면 또 질문 주시기 바랍니다.

1

안녕하세요, 인프런 AI 인턴입니다. Jae rry님.

- Ollama 외 무료 LLM 모델 사용:

Ollama 외에도 Hugging Face의 Transformers 라이브러리를 통해 다양한 무료 LLM(대형 언어 모델)을 활용할 수 있습니다. Transformers 라이브러리는 다양한 자연어 처리 모델을 제공하며, PyTorch 또는 TensorFlow 기반으로 실행할 수 있는 장점이 있습니다. 이를 통해 BERT, RoBERTa, T5, GPT-2 등의 다양한 모델을 테스트할 수 있으며, 특히 한글을 잘 처리하는 모델 중 하나로 KoBERT나 KoGPT-2 등을 고려해보실 수 있습니다.

또한, DialoGPT와 같은 대화형 모델을 통해 다방면으로 활용해볼 수도 있으니 Hugging Face의 모델 허브에서 무료로 사용 가능한 모델들을 살펴보시기 바랍니다.

- Ollama와 SerpAPI 연동 문제:

Ollama를 사용하는 경우와 GPT를 사용하는 경우의 차이는 주로 API 호출 방식과 관련이 있습니다. Ollama는 로컬에서 모델을 구동하는 방법을 제공하는 반면, 대부분의 GPT 기반 솔루션은 클라우드 기반으로 동작하기 때문에 사전 정의된 API 엔드포인트와의 통신을 통해 쉽게 연동됩니다.

Ollama는 주로 로컬 환경에서 동작하므로 SerpAPI 같은 외부 API와의 직접적 연결보다, 별도의 미드웨어 또는 프록시 서버를 둘러 데이터 통신을 중계해야 할 수도 있습니다. 이는 사용하고자 하는 솔루션의 아키텍처를 재검토하고 적절한 통신 방식을 구현해야 해결될 수 있습니다.

유사한 주제에 대한 더 많은 정보를 위한 참고 링크는 다음과 같습니다:

- AI 모델 연결시

- Ollama를 이용한 모델 사용시 GPU 사용

질문자님의 탐구가 원활히 진행되길 바라며, 추가적으로 궁금하신 점이 있으시면 언제든지 문의해 주세요. 제가 제공하는 링크가 현재 베타 기능으로 답변이 만족스럽지 않을 수 있는 점 양해 부탁드리며, 곧 지식공유자께서 직접 답변해 주실 것입니다. 🙏