인프런 커뮤니티 질문&답변

Ollama를 이용한 모델 사용시 GPU 사용

해결된 질문

작성

·

1K

답변 2

0

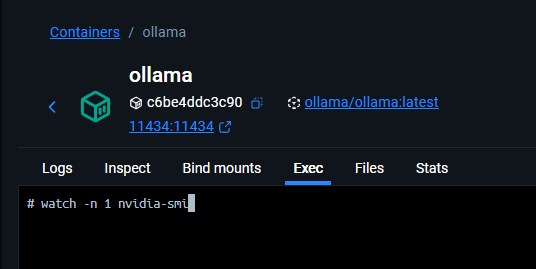

일단 도커가 최초 실행시 --profile gpu-nvidia 모드로 실행되었는지 확인해봐야 할 듯 합니다. 그리고 도커가 구동중인 상태라면

watch -n 1 nvidia-smi명령어를 통해 해당 ollama에 GPU가 로드되고 있는지 확인해볼 수 있습니다.

이는 그림에서 처럼 ollama 도커 내부에서 실행되어야 하는 명령어 입니다. n8n에서 ollama를 동작 시킨 후 입력해서 실제 프로세스가 할당 되는지 확인해볼 수 있습니다.

# ollama run gemma3:4b

>>> /bye

# ps aux | grep ollama

root 1 0.0 0.5 53716724 189916 ? Ssl 03:48 0:02 /bin/ollama serve

root 731 106 13.1 70207596 4315340 ? Sl 09:09 0:07 /usr/bin/ollama runner --ollama-engine --model /root/.ollama/models/blobs/sha256-377655e65351a68cddfbd69b7c8dc60c1890466254628c3e494661a52c2c5ada --ctx-size 8192 --batch-size 512 --n-gpu-layers 35 --threads 10 --parallel 4 --port 40681

root 955 0.0 0.0 3312 632 pts/0 S+ 09:09 0:00 grep ollama

#또한 위에서 처럼 도커 내부에서 직접 ollama run 을통해 모델을 실행 시킨 후 바로 /bye로 종료 한 후

ps aux | grep ollama명령어를 사용하면 올라마가 어떤 파라메터를 사용해서 구동했는지도 확인 할 수 있는데 여기서 gpu가 사용중인치 체크해볼 수도 있습니다.

사실 이 문제는 --profile gpu-nvidia 로 도커가 구동되면 신경쓸게 없어야 정상인 부분이긴 합니다. CPU 100%를 사용한다 하셨는데 실제 어떤 프로세스가 CPU를 점유하고 있는지도 체크해보셔야 할 듯 합니다. 제가 한방에 해결해드리면 제일 좋겠지만 환경적인 여러 요소에 의해 차이가 날 수 있고 저는 추측을 해봐야 하는 입장에서 답변이 부족할 수 밖에 없습니다.

ChatGPT 같은 AI 한테 이미지 스샷과 현재 상황을 충분히 설명하시면서 도움을 받아보는것도 방법이 될 수 있으니 참고 하시기 바랍니다. 더 궁금하신 내용이나 추가 하실 내용이 있으면 언제든 질문 남겨주시기 바랍니다.

0

안녕하세요, 인프런 AI 인턴입니다. 꿀토리님 질문에 답변 드리겠습니다.

Ollama를 사용하여 AI 모델을 구동할 때 GPU가 제대로 활용되지 않는 문제는 주로 다음과 같은 이유로 발생할 수 있습니다:

- Ollama나 n8n 설정에서 GPU 활용이 명시되지 않은 경우.

- 사용 중인 AI 모델이 GPU 최적화가 제대로 이루어지지 않은 경우.

- 시스템 환경이나 드라이버가 최신 상태가 아닌 경우.

해결 방법:

Ollama와 n8n 설정 확인: 설정 파일이나 환경 변수에서 GPU 사용이 활성화되어 있는지 확인해 보세요. 일반적으로

--profile gpu옵션을 사용하는 것이 GPU 활용에 도움이 됩니다.환경 변수 설정:

NVIDIA_VISIBLE_DEVICES나CUDA_VISIBLE_DEVICES환경 변수를 올바르게 설정하여 GPU 자원을 할당할 수 있습니다.드라이버 업데이트: NVIDIA의 최신 드라이버로 업데이트하여 올바르게 GPU가 인식되고 사용되도록 해야 합니다.

참고로, n8n의 GPU 활용에 관한 구체적인 지침이나 Ollama의 GPU 설정 방법에 대해 직접적인 자료가 제공되지 않은 상황에서 문제가 지속된다면, 해당 플랫폼의 공식 문서나 사용자 포럼을 참고하시기 바랍니다.

추가적인 질문이나 안내가 필요하시면 아래 링크를 통해 비슷한 질문들을 참고하세요:

위 답변이 꿀토리님에게 도움이 되기를 바랍니다.

저는 질문자님의 이해를 돕고자 지식공유자님의 기존 답변을 참고하여 유사한 답변 링크를 추천해드리고 있습니다. 현재 베타 기능으로 답변이 만족스럽지 않을 수 있는 점 양해 부탁드립니다. 🙏 추가적으로 궁금한 점이 있으시면, 이어서 질문해 주세요. 곧 지식공유자께서 답변해 주실 것입니다.