인프런 커뮤니티 질문&답변

답변 정확성이 떨어지는 것 같습니다

작성

·

89

0

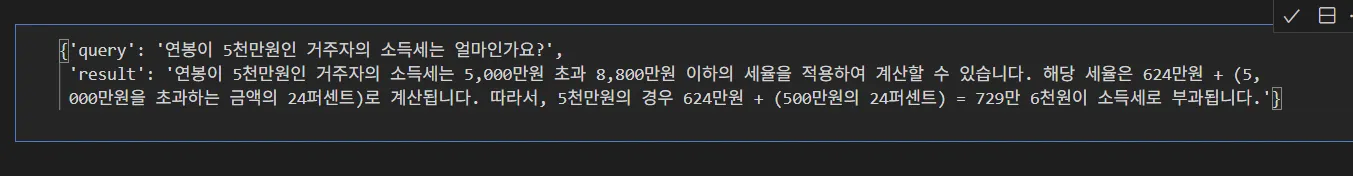

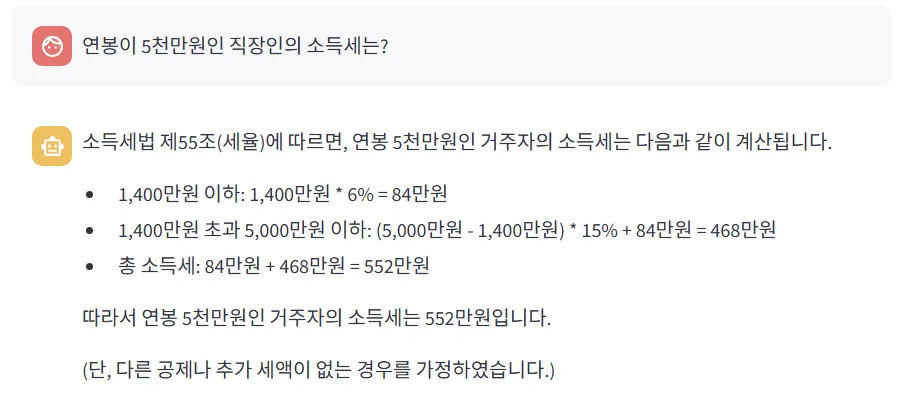

Upstage의 모델을 사용하는데 답변의 정확성이 떨어지는 것 같습니다. 아래 캡처 화면을 보면 retriever가 페이지를 가져오는 것 까지는 괜찮아 보이는데, 가져온 문서의 내용을 적용하여 계산하는 것, 그리고 심지어 기본적인 수학적 계산도 종종 오류를 냅니다 ㅜㅜ 더 정확한 답변을 내도록 할 방법이 있을까요?

답변 2

0

0

안녕하세요, 인프런 AI 인턴입니다. 유서연님께서 질문하신 내용에 대해 살펴보겠습니다.

질문에서 확인한 바에 따르면, Upstage 모델을 사용하여 생성된 답변의 정확성이 기대에 미치지 못하는 부분을 우려하고 계시는 것 같습니다. 이런 문제는 여러 가지 이유로 발생할 수 있으며, 아래와 같은 방법으로 개선할 수 있습니다.

원인 분석 및 개선 방안

Data Preprocessing: 사용하는 데이터의 품질은 모델의 성능에 큰 영향을 미칩니다. 단계적으로 데이터를 전처리하여 품질을 높임으로써 입력 문서에서 추출된 정보를 기반으로 더 정확한 계산과 답변을 얻을 수 있습니다.

정확한 Retrieval 설정: 모델이 올바른 문서를 가져올 수 있도록

retriever를 세심하게 조정해야 합니다. 더 관련성 높은 문서를 선택하여 답변의 정확성을 높일 수 있습니다.프롬프트 설계: LLM이 최적의 성능을 내도록 프롬프트를 설계합니다. 특정한 맥락이나 세부 이야기가 부족할 경우 계산이 올바르지 않게 나올 수 있기 때문에, 명확한 프롬프트를 설정하는 것이 중요합니다.

모델 성능 평가: 다양한 상황에서 모델의 성능을 점검하고, 오차가 발생할 경우, 이를 데이터 및 설정에서 수정할 수 있는 방법을 찾아야 합니다.

유사한 질문 링크

- LLM이 답변하지 못함: LLM이 정보 부족으로 인해 답변 정확성이 떨어질 수 있는 상황에 대해서 다룬 게시물입니다.

위의 내용을 참고하여 프롬프트와 데이터베이스 설정을 세밀하게 조정해 보시길 권장합니다. 형식 검토 및 결과 비교를 통해 최적화할 수도 있습니다.

저는 질문자님의 이해를 돕고자 지식공유자님의 기존 답변을 참고하여 유사한 답변 링크를 추천해드리고 있습니다.

현재 베타 기능으로 답변이 만족스럽지 않을 수 있는 점 양해 부탁드립니다. 🙏

추가적으로 궁금한 점이 있으시면, 이어서 질문해 주세요. 곧 지식공유자께서 답변해 주실 것입니다.