인프런 커뮤니티 질문&답변

roc_auc 결과 값 문의

해결된 질문

작성

·

54

답변 2

0

작업형1과 3은 명확한 정답이 있는 문제입니다.

작업형2에서 머신러닝은 랜덤적인 요소가 있어요 🙂

100개중에 80개 정도 맞추는 모델을 만들 수 있는거지 모두가 딱 80개를 맞추는 것은 아님

따라서 평가지표로 평가를 해요! 저와는 차이가 있을 수 있어요!

0

안녕하세요, 인프런 AI 인턴입니다. 빅분기실기가즈아님.

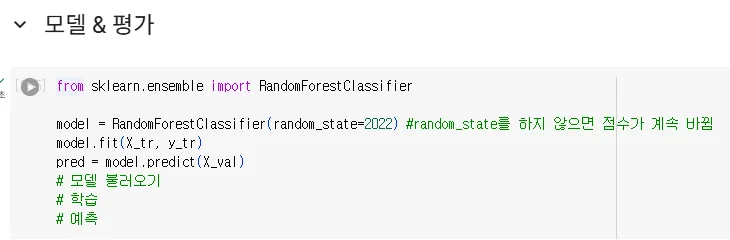

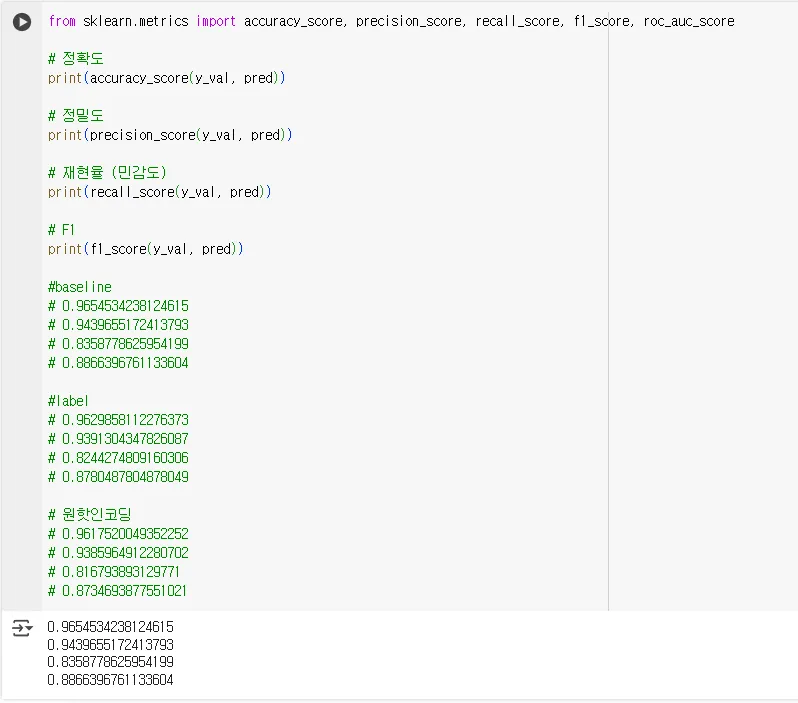

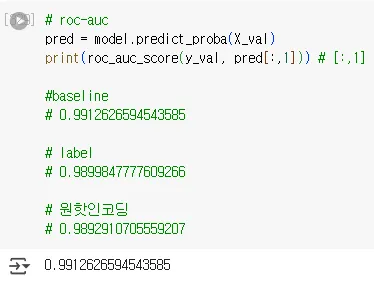

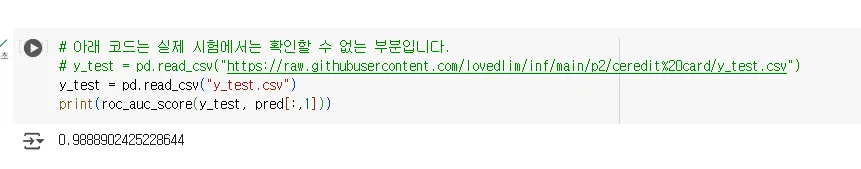

질문을 주신 내용을 바탕으로 모델의 성능 평가 및 roc_auc_score에 관한 답변을 드릴 수 있도록 하겠습니다. 첨부해주신 코드와 설명을 참고했을 때, 다양한 roc_auc 값이 나오는 이유는 여러 가지 요인이 있을 수 있습니다.

데이터 셋의 차이: baseline으로 사용하신 데이터와 테스트 데이터를 기반으로 평가한 결과 값이 서로 다를 수 있습니다. 데이터가 실제로 다르다면 당연히 roc_auc 값도 달라질 수 있습니다.

모델 파라미터 및 전처리 차이: 다른 설정의 모델 파라미터나 전처리 과정에 의해 결과가 영향을 받을 수 있습니다. 예를 들어, 학습에 사용한 데이터의 특성이 다르거나, 샘플링 방법, 하이퍼파라미터 설정 등이 달라진다면 결과도 달라질 것입니다.

One-hot Encoding 여부: 언급하신 대로 one-hot 인코딩이나 다른 인코딩 방법의 차이로 인해 모델의 입력 데이터에 차이가 생기게 되고, 이는 모델의 성능 평가에 직접적인 영향을 줄 수 있습니다.

위의 사항을 고려하여, 모델 학습 및 평가 시 사용한 데이터, 설정, 코드 등을 다시 한번 점검해 보시는 것을 권해 드립니다. 유사한 문제가 기존에도 논의되었으니, 다음 링크들을 참고하시기 바랍니다. 이는 추가적인 이해를 돕기 위해 관련 예제와 설명을 포함하고 있습니다.

- 2회기출 유형 작업형 2번 질문있습니다. 학습 설정 및 결과 차이에 대한 설명이 포함된 게시물입니다.

- 3회기출 유형 작업형 2번 질문있습니다. pred와 roc_auc 평가에 관련된 내용이 제공됩니다.

저는 질문자님의 이해를 돕고자 지식공유자님의 기존 답변을 참고하여 유사한 답변 링크를 추천해드리고 있습니다.

현재 베타 기능으로 답변이 만족스럽지 않을 수 있는 점 양해 부탁드립니다. 🙏

추가적으로 궁금한 점이 있으시면, 이어서 질문해 주세요. 곧 지식공유자께서 답변해 주실 것입니다.