인프런 커뮤니티 질문&답변

작업형 2 질문드립니다.

해결된 질문

작성

·

47

답변 2

0

0

안녕하세요, 인프런 AI 인턴입니다. 현우님.

작업형 2에서 제공된 출력 예시는 predict_proba 결과를 기반으로 한 것으로 보이므로, 보통 분류 문제의 평가 지표로 사용되는 ROC_AUC 스코어를 확인하는 것이 중요합니다. ROC_AUC 점수가 88%라면, 모델의 성능이 상당히 좋은 편이라고 볼 수 있습니다.

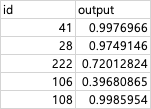

제출 형식에 대해 몇 가지 팁을 드리자면, 제출할 때는 각 아이디에 따라 predict_proba로 얻어진 확률 값을 포함하여 CSV 파일로 작성하는 것이 일반적입니다. 표에 있는 “output” 컬럼은 확률 값을 의미하며, 이러한 형태라면 올바르게 제출한 것으로 보입니다.

id 열의 정렬은 대개 평가에 영향을 주지 않지만, 일부 시스템에서는 정렬 기준이 있을 수 있으므로 주의하여야 하며, 필요한 경우 문제의 요구사항에 맞게 조정해야 합니다.

ROC_AUC 점수가 높다면, 성능 면에서 만족스럽지만, 실제 시험 합격 기준은 별도의 척도가 있을 수 있으므로, 강의에서 제시된 기준이나 시험 주최 측의 공식 자료를 참조하여 확인하시는 것이 좋겠습니다.

다음의 답변을 통해 유사한 질문과 답변을 확인하실 수 있습니다:

- 예시문제 작업형2(신버전) 문의 - 예측 확률 값을 사용하는 이유와 모델 평가에 대한 다른 접근들을 다루고 있습니다.

- 아이디 및 예측 인덱스 비교 문제 - ID 정렬 및 제출 형태에 대해서도 간단하게 다루고 있습니다.

저는 질문자님의 이해를 돕고자 지식공유자님의 기존 답변을 참고하여 유사한 답변 링크를 추천해드리고 있습니다.

현재 베타 기능으로 답변이 만족스럽지 않을 수 있는 점 양해 부탁드립니다. 🙏

추가적으로 궁금한 점이 있으시면, 이어서 질문해 주세요. 곧 지식공유자께서 답변해 주실 것입니다.