Sau khi tốt nghiệp Tiến sĩ, tôi đã có cơ hội nghiên cứu và giảng dạy về Computer Vision trong khoảng 5 năm,

Cho đến nay, tôi vẫn đang thực hiện các nghiên cứu kết nối giữa chuyên ngành toán học và lý thuyết kỹ thuật.

Lĩnh vực chuyên môn (Lĩnh vực nghiên cứu)

Chuyên ngành: Toán học (Hình học Topo), Chuyên ngành phụ: Khoa học máy tính

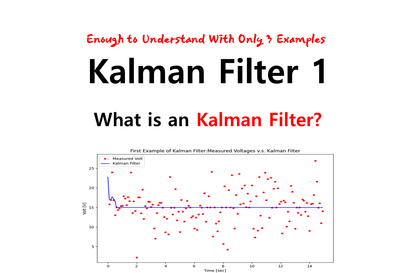

Hiện tại) 3D Computer Vision(3D Reconstruction) , Kalman Filter, Lie-group(SO(3)),

Nhà nghiên cứu Phương trình vi phân ngẫu nhiên (Stochastic Differential Equation)

Hiện tại) Vận hành kênh YouTube: Lim Jang-hwan: 3D Computer Vision

Hiện tại) Thành viên Ban chuyên môn Toán học tại nhóm facebook Spatial AI KR

Trường đã theo học

Tiến sĩ Khoa học Tự nhiên tại Đại học Kiel, Đức (Chuyên ngành Hình học Topo & Nhóm Lie, chuyên ngành phụ Khoa học Máy tính)

Cử nhân, Thạc sĩ khoa Toán Đại học Chung-Ang (chuyên ngành Hình học tô-pô)

Kinh nghiệm làm việc

Cựu Giám đốc Công nghệ (CTO) của Doobeevision, công ty con thuộc Tập đoàn Daesung

Cựu Giáo sư nghiên cứu tại Cao học Hình ảnh Tiên tiến, Đại học Chung-Ang (Nghiên cứu 3D Computer Vision)

Sách đã xuất bản:

Lý thuyết tối ưu hóa: https://product.kyobobook.co.kr/detail/S000200518524

Liên kết

Youtube: https://www.youtube.com/@3dcomputervision

Blog: https://blog.naver.com/jang_hwan_im

Nghiên cứu Computer Vision) Sách: Lý thuyết tối ưu hóa: https://product.kyobobook.co.kr/detail/S000200518524 Link Youtube: https://www.youtube.com/@3dcomputervision Blog: https://blog.naver.com/jang_hwan_im

(Nghiên cứu Computer Vision) Sách: Lý thuyết tối ưu hóa: https://product.kyobobook.co.kr/detail/S000200518524 Link YouTube: https://www.youtube.com/@3dcomputervision Blog: https://blog.naver.com/jang_hwan_im

(Nghiên cứu Computer Vision) Sách: Lý thuyết tối ưu hóa: https://product.kyobobook.co.kr/detail/S000200518524 Link Youtube: https://www.youtube.com/@3dcomputervision Blog: https://blog.naver.com/jang_hwan_im

Nghiên cứu Computer Vision) Sách: Lý thuyết tối ưu hóa: https://product.kyobobook.co.kr/detail/S000200518524 Link Youtube: https://www.youtube.com/@3dcomputervision Blog: https://blog.naver.com/jang_hwan_im

Nghiên cứu Computer Vision) Sách: Lý thuyết tối ưu hóa: https://product.kyobobook.co.kr/detail/S000200518524 Link Youtube: https://www.youtube.com/@3dcomputervision Blog: https://blog.naver.com/jang_hwan_im

Nghiên cứu Computer Vision) Sách: Lý thuyết tối ưu hóa: https://product.kyobobook.co.kr/detail/S000200518524 Link Youtube: https://www.youtube.com/@3dcomputervision Blog: https://blog.naver.com/jang_hwan_im