AWS(Amazon Web Service)入門者の講義

Sungmin Kim

¥5,412

入門 / AWS, cloud-computing, cloud-platform

4.7

(237)

このごろ会社や様々なプロジェクトでよく使われるAWSサービスの核心理論を学び、また一緒に従う実践を通じてAWSを完全に私にしよう!

入門

AWS, cloud-computing, cloud-platform

AWS入門者、中級/上級者のための講義をすべて受講したにもかかわらず、まだ何か不足していると感じますか? AWS 実践のための講義がまさにそのような方のための講義です。

受講生 125名

難易度 中級以上

受講期間 無制限

講座 を紹介して、成長と収益を得ましょう!

マーケティングパートナーズ

講座 を紹介して、成長と収益を得ましょう!

Apache Airflow

AWS Batch

AWS ECR

AWS Athena

AWS Glue

実戦中心! AWS アプリケーションの完成版。

🤔 AWS入門者/中上級者講義を終えたが、まだ1%が足りないようです。

😎 AWSショーケースを通じて会社で昇進を狙っています。

😀AWSが提供するリソースでさまざまなパイプラインを構築したいです。

🥺 AWSの様々な使い方を体験してみたいです。

🤓クラウドの世界にもっと深く陥りたいです。

👉 AWSシリーズの終着駅!あなたの悩みに解決策を提示します。

AWS実践編のための講義は、まずAWS入門者、 中級/上級者のための講義を愛してくださる皆さんがいらなかったらできませんでした。皆さんの熱烈な応援と支持のおかげでこの講義ができたとしても過言ではありません。

このレッスンは、エンジニアが現業でどのようにAWSを使用してETLパイプライン構築、ドッカーコンテナ、Airflowスケジューラを構築するのかを間接的に体験できるように構成されています。タイトルでわかるように、概念の整理は最小限に抑え、実習中心に進みます。

1つのセクションごとのクラスの長さは短くて30分、長くて1時間かかります。グンダーダーはすべて除いて重要な内容だけを入れて属性で皆さんに伝えるためです。

AWSを素早く応用して使いたい方、AWS入門者のための講義を聞き、より深くクラウドを掘り下げてみたい方に強くお勧めします。

講義制作の過程で気になる部分の1つはトラブルシューティング(Troubleshooting)セクションです。私がAWSを回す環境(オペレーティングシステム、環境設定など)はあなたと常に同じではありません。だから私はよく戻っても皆さんはエラーが浮かぶ部分があると思います。すべてのエラーをすべて説明することは不可能ですが、しばしば発生するエラーを集め、どのようにあなたが直接問題解決をすることができるかについての悩みをたくさんしてみました。それで、そのセクションを作ることになりました。

講義を作るとき、「私はうまくいきますが、他の人たちはこのようなエラーが発生しませんか?」という考えを持ち、その時その可能性の高い例外状況を整理し、それに対する解決策を皆さんに提示します。

だから、学習後は...

本講義は実習90%、理論10%で構成されています。したがって、選手の知識はAWS入門者のための講義です。 中級/上級者のための講義はオプションであり、実戦編のための講義と一緒に視聴しても無理はありません。

AWS 実践編の講義は AWS シリーズの終着役です。実戦編を頑張ったからといって、AWSのすべてをすべて理解するとは言えません。しかし、今後AWSを使用し、新しいスキルを学ぶ際に大きな助けになると確信しています。

シリーズ選手コースをチェックしてください。

AirflowをAWSで回すことはできますか?はい。 AWS と Airflow を一緒に使用して、AWS リソースの助けを借りて、より幅広いパイプラインを構築できます。

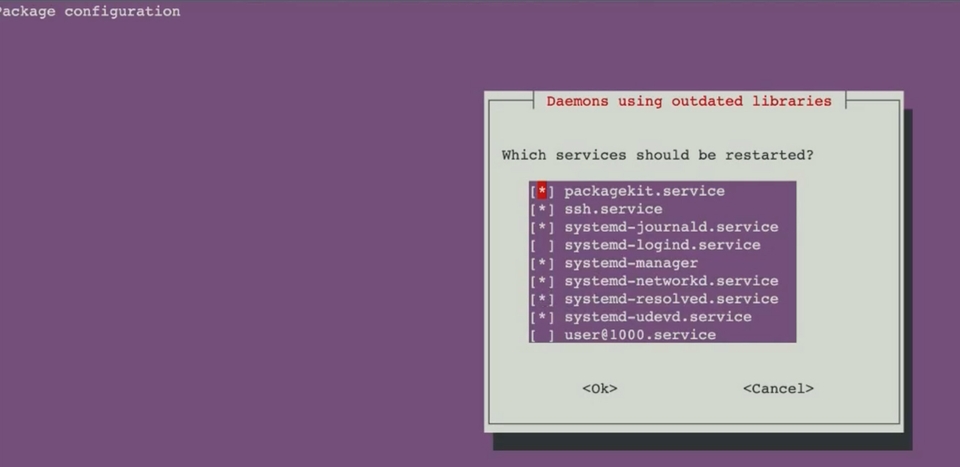

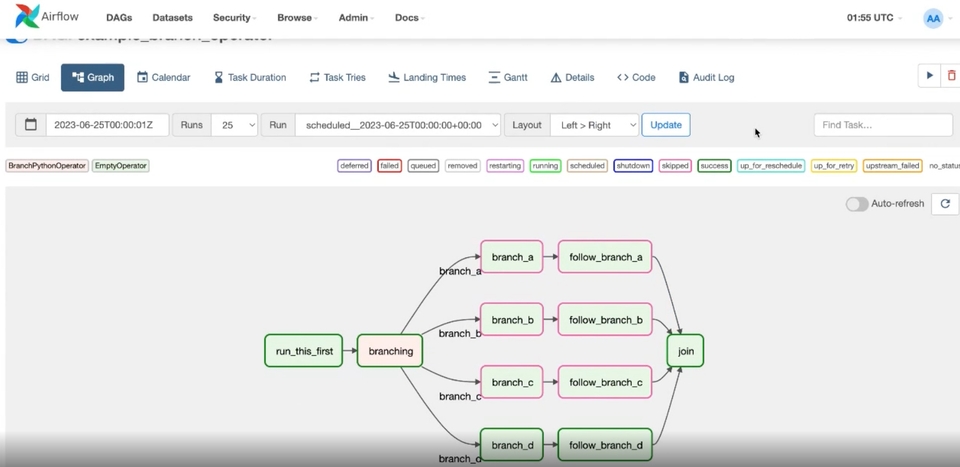

(1) インスタンス作成後に Airflow を回すのに必要なパッケージをインストールします。

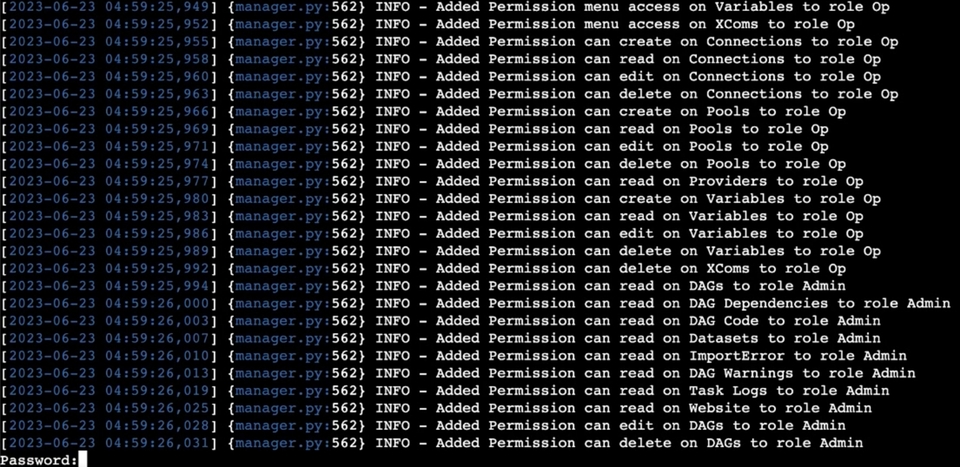

(2)Airflowデータベースを作成してユーザーを作成します。

(3) Airflow DAG を実行します。

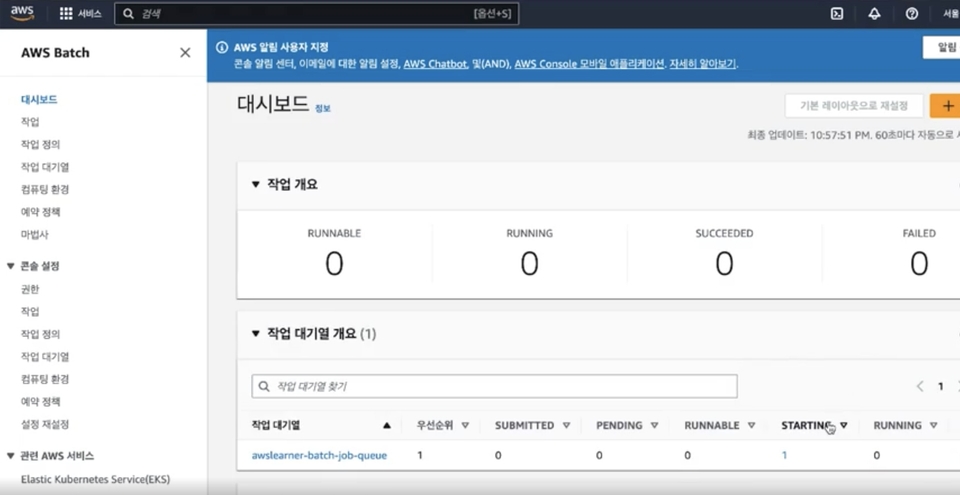

バッチジョブとキューを作成し、ECRにプッシュしたイメージを実行する練習をします。 AWS Batch は入門者、中級/上級者の講義で扱われていないため、このセクションで簡単に紹介します。

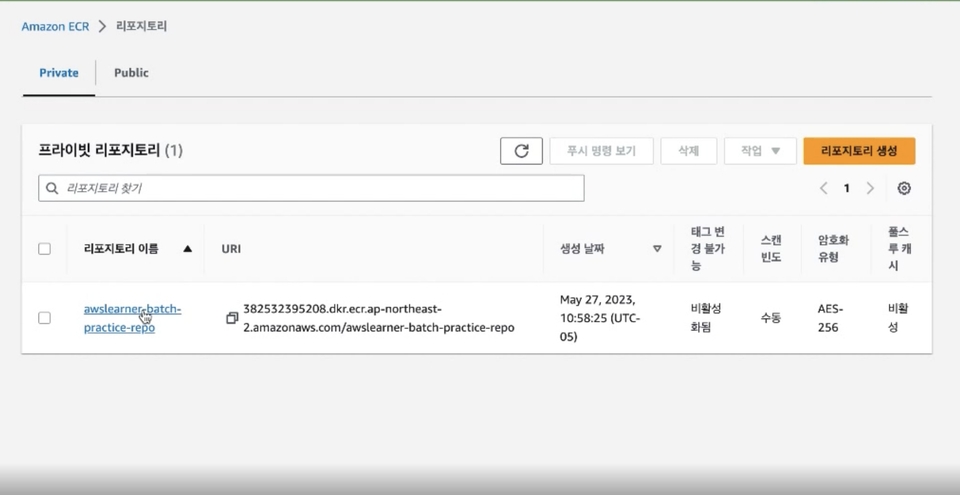

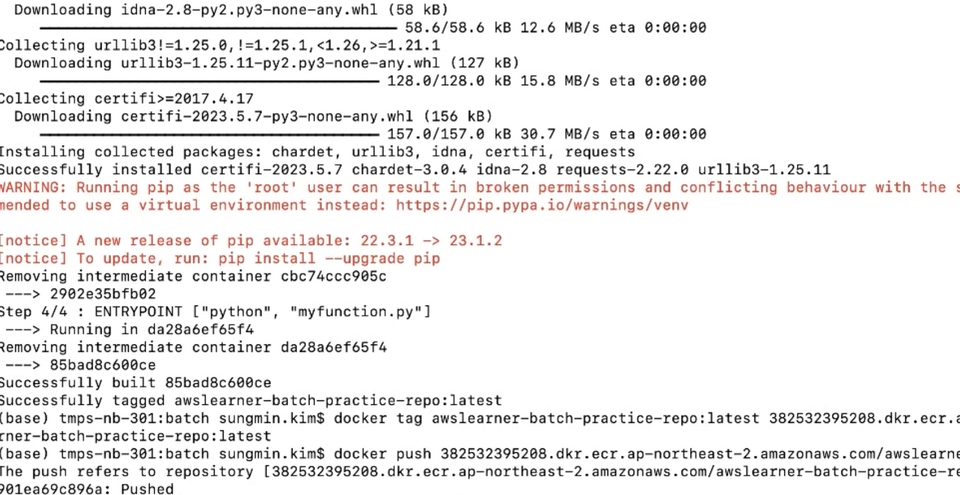

(1) ドッカーイメージを保存する ECR リポジトリを作成します。

(2) ドッカー画像を作成し、ECR リポに画像をプッシュします。

(3)バッチジョブ(Job)とキュー(Queue)を作成してジョブを実行します。

AWSリソース(S3、Glue、Athena)を使用して簡単なETLパイプラインを構築します。

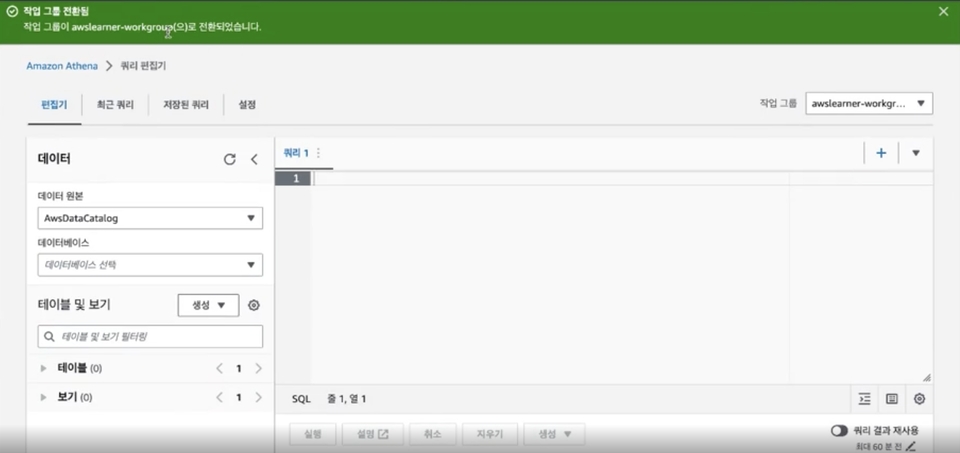

(1)ローデータが入るバケットを作成し、データを保持するAthenaデータベースを作成します。

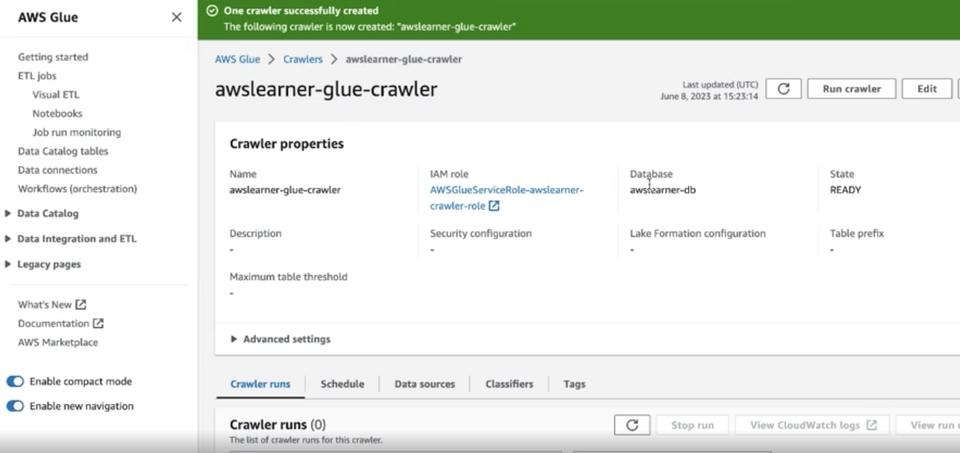

(2)Glue Crawlerを作成してローデータを抽出します。

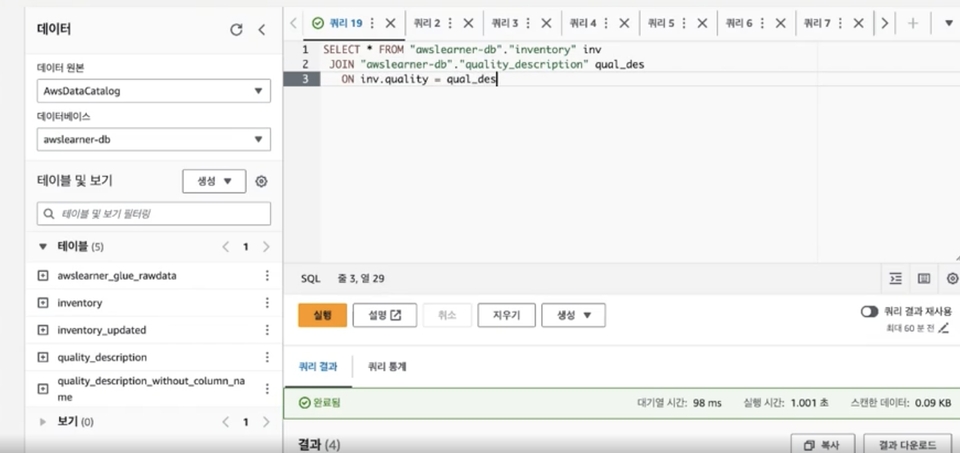

(3) Athenaでデータ検証過程を経ます。

Q. この講義を聞かなければならない理由は何ですか?

今では、IT産業だけでなく、さまざまな場所でクラウドが言及され使用されています。クラウドインフラストラクチャは現在、実生活から離れなければならない。ビッグデータ時代に住んでいる私たちは、毎日多数のデータを生成、処理、分析します。これは決して誰もがすることはできません。クラウドの助けを借りてください。 AWSはまさにその役割を担います。

AWSの実践のためのレッスンは、実際の現業でよく使われるアーキテクチャをいくつか紹介し、あなたがしたがって実践できる講義で構成されています。練習に従い、なぜここでこのようなリソースが使用され、より良い方法がないのか、自分で質問を投げながら講義に従うことをお勧めします。クラウドに正解はありません。ただ、より良い方法が存在するだけです。与えられた環境であなたはより良い方法を探求し見つけなければなりません。この講義はその方法を支援します。

Q. 非専攻者も聞くことができますか?

もちろんです。コンピュータの専攻者でなくてもAWSクラウドの経験がある場合は、十分に受講できます。

💡選手の知識と注意事項

学習対象は

誰でしょう?

AWS入門者、中級/上級者講義を修了した方

AWSさまざまなリソースを使用してパイプラインを構築したい人

AWSの幅広い用途を体験したい方

前提知識、

必要でしょうか?

Python

クラウドの基本知識

AWS

6,048

受講生

308

受講レビュー

157

回答

4.7

講座評価

5

講座

こんにちは。私はアメリカの大学と大学院を卒業し、専攻はそれぞれコンピュータサイエンスとデータサイエンスを学びました。現在はヘルスケア関連の企業でデータエンジニアとして働いています。日々の業務を簡単に説明しますと、AWSとAirflowを使用して毎日データを読み込み、ETLプロセスを実行しています。また、データが正常に取り込まれているかをモニタリングし、問題点や改善の余地がある場合にはプログラムを実装する業務を担当しています。データのモニタリングには、主にAWSのCloudWatchやSplunkというプログラムを使用しています。現在、業務で使用している技術はPython、AWS、SQLなどですが、最近はGCPへのマイグレーションを進めている段階であり、AWSとGCPの両方に携わっています。

2022年には、社内のデータおよびパイプラインの約80%がGCPへの移行を完了しており、BigQuery、GCS、GKEを深く扱っています。もちろん、DockerコンテナやTerraformを使用し、全般的なIaC作業も並行して進めています。

データエンジニアとして働きながら最も強く感じたことは次の通りです。毎日新しい技術が登場する中で、「今自分が使っている技術は果たして廃れてしまうのか?」「もしそうなら、その理由は何なのか?」「本当にその技術はこれで代替できるのか?」「デメリットはないのか?」そうです。これらすべての問いに対する答えを見つけるのは非常に困難に見えます。しかし、その過程を経て一つの共通点が見えてきました。深く掘り下げてみると、どれもほとんど大同小異だということです。言い換えれば、一つを徹底的に突き詰めれば、他の技術を学ぶことは非常に容易になるということです。私はこのようなメカニズムを講義でも度々お伝えしたいと思っています。皆さんと一緒に、私が現在持っているすべての知識を共有したいです。皆さんの道しるべになれるよう、最善を尽くします。

私サイモン・キムは、皆さんに楽しくて分かりやすい講義をお届けします。皆さんと絶えずコミュニケーションを図りながら、より良い人間になることをお約束します。皆さんの実力が向上していくのを見守ることは、私にとって大きな幸せです。

全体

17件 ∙ (1時間 42分)

講座資料(こうぎしりょう):

1. ようこそ

04:24

2. EC2インスタンスの作成

03:55

3. Packagesのインストール

10:06

4. 環境変数を更新する

07:04

5. ユーザーを作成する

02:52

6. Airflowを実行する

05:43

7. AWS Batch

03:38

8. 練習コード Walkthrough

04:06

9. ECRリポジトリの作成

03:28

10. ドッカー画像を作成する

05:28

12. ジョブを作成する

06:54

全体

4件

4.3

4件の受講レビュー

受講レビュー 8

∙

平均評価 5.0

受講レビュー 2

∙

平均評価 4.5

受講レビュー 5

∙

平均評価 3.6

受講レビュー 1

∙

平均評価 5.0

知識共有者の他の講座を見てみましょう!

同じ分野の他の講座を見てみましょう!

¥5,936