하루 만에 이해하는 AI 기반 풀스택 개발 실무 트랙(주니어용)

아리가람

주니어 개발자가 인공지능을 개발 도구로 삼아 기획부터 코드 작성과 배포 및 검증에 이르는 전체 개발 과정을 이해할 수 있게 함으로써, AI 시대에 필요한 풀스펙트럼(Full-Spectrun) 역량을 갖춰 생존하고 발전할 수 있게 합니다.

초급

프로토타이핑, crud

18명 이 수강하고 있어요.

난이도 입문

수강기한 무제한

언어 모형의 발달 과정과 각 언어 모형의 원리

NLP의 기원

트랜스포머의 구조와 원리

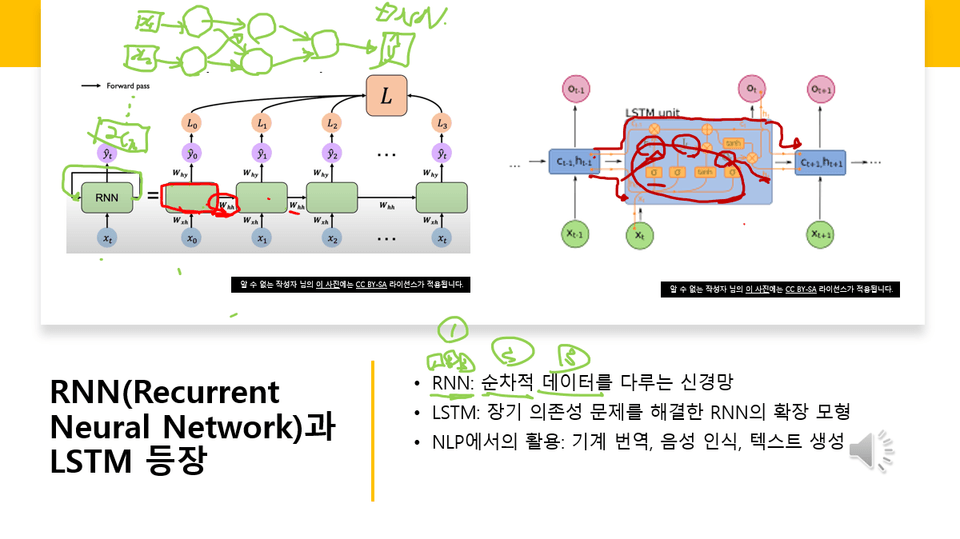

RNN, LSTM의 구조와 원리

어텐션 메커니즘의 원리

현재 강의를 완성해 가고 있는 중입니다. 강의가 다 완성될 때까지 (수시로 보강하겠지만) 오래 기다리셔야 하는 단점이 있습니다. 이러한 점을 고려해서 구매를 결정해 주시기 바랍니다.

2025년 12월 10일

새로운 수업들을 대폭 추가할 예정으로 일단 목차를 공개했습니다. [2판]으로 표기해 두었습니다.

기존 수업들을 [1판]임을 표시해 두었습니다. 기존 수업들을 개정할 예정입니다. 개정된 내용으로 바뀌게 되면 수업 제목에 [2판]이라고 표기할 것입니다.

이 강의는 자연어 처리의 초기 연구부터 최신 대규모 언어 모델(LLM)에 이르기까지, 언어 모델의 발전 흐름을 종합적으로 학습하는 과정입니다. 규칙 기반 시대에서 시작하여 통계적 언어 모델, 신경망 기반 모델, 트랜스포머 혁명을 거쳐 오늘날의 멀티모달·효율화·응용 중심의 LLM까지 이어지는 기술적 변화를 체계적으로 이해합니다.

언어 모델이 어떻게 발전해 왔는지 전체 흐름을 이해한다.

시대별 핵심 모델(RNN, LSTM, Transformer, BERT, GPT 등)의 특징을 파악한다.

최신 LLM 기술과 연구 동향을 구조적으로 정리한다.

LLM 효율화 기술과 실제 응용 방식을 이해한다.

미래 LLM 연구의 방향성과 한계점을 비판적으로 바라본다.

강의는 총 6개 섹션으로 구성되며, 각 섹션은 시대적 흐름과 연구 축을 중심으로 구성됩니다.

섹션 1: NLP의 기원과 초기 발전

섹션 2: 트랜스포머 이전의 언어 모델 연구

섹션 3: 트랜스포머 혁명과 대규모 언어 모델

섹션 4: 최신 LLM 기술과 연구 동향

섹션 5: LLM 효율화 기술과 모델 최적화

섹션 6: LLM 응용·시스템 통합·미래 전망

이 섹션에서는 NLP의 출발점부터 초기 언어 모델의 기반을 학습합니다.

NLP가 어떤 문제를 다루며 어떻게 시작되었는지

규칙 기반 시스템이 어떻게 구성되었고, 왜 한계에 부딪혔는지

통계적 언어 모델(n-gram LM)이 어떻게 등장했는지

Brown Corpus, Penn Treebank 등 초기 대규모 코퍼스의 등장과 의미

분포 가설(Distributional Hypothesis)의 개념과 NLP 적용 방식

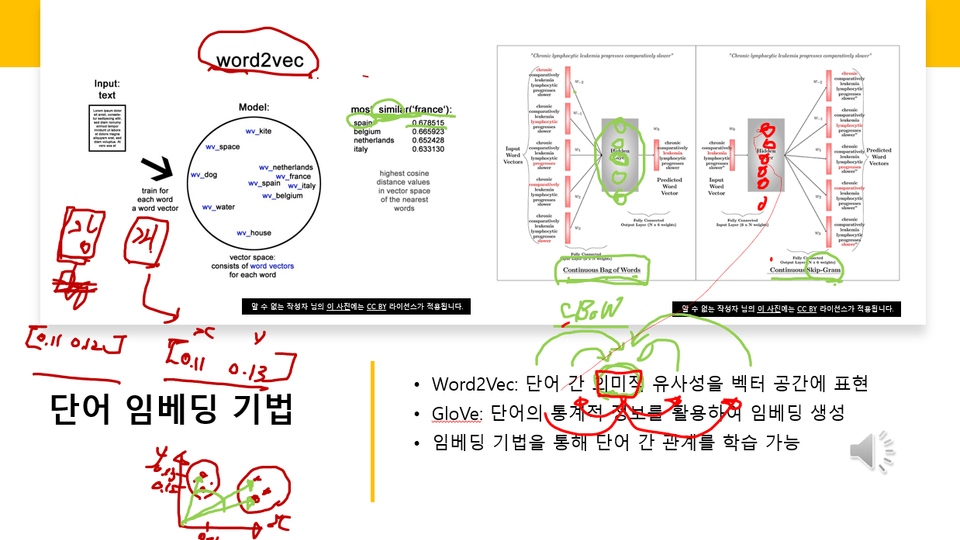

Word2Vec, GloVe 등 초기 단어 임베딩 기술의 탄생과 기여

이 섹션에서는 RNN 계열 모델이 NLP를 어떻게 변화시켰는지, 그리고 트랜스포머 이전의 기술적 한계를 다룹니다.

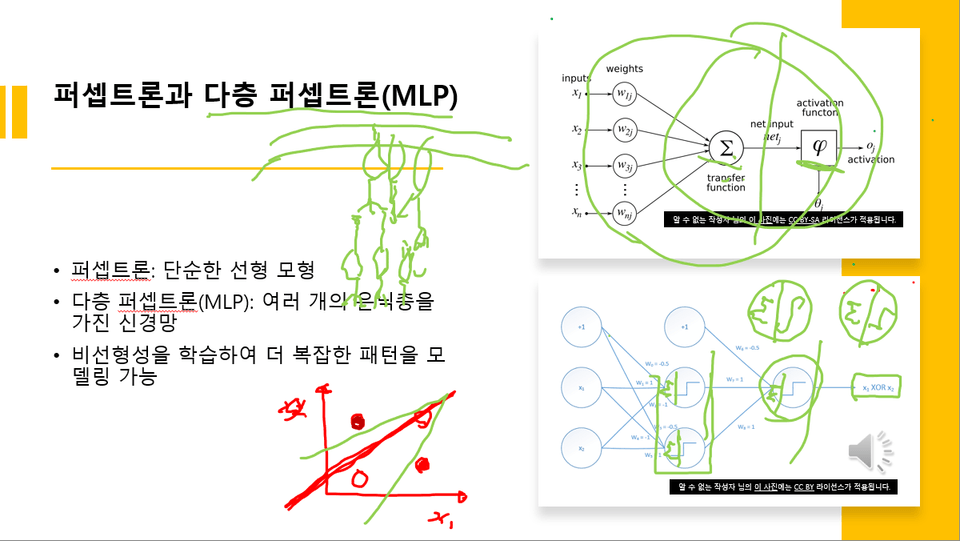

RNN, LSTM, GRU의 등장 배경과 구성 원리

장기 의존성 문제(Long-term dependency)의 본질

Seq2Seq 구조가 기계 번역의 혁신을 어떻게 이끌었는지

Attention 메커니즘이 등장하게 된 이유와 효과

CNN 기반 언어 모델은 연구 분류가 다르므로 확실하지 않음, 하지만 주요 아이디어 학습

트랜스포머 직전의 연구 상황을 정리하며 다음 세대 모델의 필요성을 이해

이 섹션에서는 트랜스포머 중심의 현대 LLM 시대가 어떻게 열렸는지를 배웁니다.

“Attention Is All You Need”로 대표되는 트랜스포머의 구조·특징

사전학습(Pretraining)·언어 이해 모델의 등장 배경

BERT 모델의 양방향성 개념, MLM(Masked LM) 기법

GPT 시리즈(GPT–GPT-4)의 주요 발전 흐름

“사전학습 → 미세조정”의 표준화된 학습 패러다임 정착

스케일링 법칙(Scaling Laws)의 의미 및 LLM 훈련 전략 변화

이 섹션은 최신 LLM의 구조·특징·학습 방식뿐 아니라 인간 피드백 기반 모델까지 다룹니다.

GPT-4, Llama, Claude 등 최신 LLM의 공통 특성

오픈소스 LLM(예: Llama·Mistral)의 등장 배경

RLHF·DPO·Instruction Tuning과 같은 사용자 맞춤형 학습 기술

멀티모달(Multimodal) 모델의 구조와 활용 사례

편향·환각·안전성 연구와 윤리적 고려 요소들

이 섹션은 대규모 모델을 더 가볍고 빠르게 만드는 기술이 중심입니다.

양자화(Quantization), 프루닝(Pruning), 지식 증류(Distillation)

LoRA·Prefix Tuning 같은 PEFT(Parameter-Efficient Fine-Tuning)

FlashAttention 등 고속 Attention 알고리즘

추론 비용 절감 기법

온디바이스(on-device) LLM의 개념과 기술적 과제

실제 서비스 적용에서의 효율화 사례

이 섹션은 LLM이 실제 시스템·서비스에서 어떻게 활용되는지를 배우고,

미래 방향은 일부 불확실성을 인정하며 정리합니다.

Retrieval-Augmented Generation(RAG)의 구조와 장점

Toolformer·ReAct 등 도구 사용 기반 LLM의 원리

의료·법률·코딩 같은 도메인 특화 LLM

GPT-4V 등 멀티모달 모델의 확장

LLM 기반 자율 시스템 연구(일부 “확실하지 않음”)

LLM의 미래 전망 및 논쟁 지점(예: AGI 가능성 → “확실하지 않음”)

아래 보이는 예시 화면처럼 강의 중에 각종 도식을 사용해 LLM과 관련된 개념들을 자세히 설명합니다. 특히 NLP, RNN, self-attention, transformer, LLM과 관련된 도식들을 사용해서 집중적으로 설명합니다.

수업 3에서 설명하는 화면 예시 1

수업 3에서 설명하는 화면 예시 2

강의 제목

수업 3에서 설명하는 화면 예시 3

인공지능·데이터 과학에 관심 있는 학습자

NLP 또는 LLM 기술을 체계적으로 이해하고 싶은 개발자·연구자

인공지능 기술의 최신 흐름을 파악하고 싶은 분

기본적인 머신러닝 개념

파이썬 기반의 간단한 모델 사용 경험(권장)

전반적인 언어 모델 발전사를 깊이 있게 이해할 수 있습니다.

최신 LLM 기술과 트렌드를 분석하고 활용할 기반 지식을 갖출 수 있습니다.

LLM을 활용한 문제 해결·서비스 설계·연구 방향을 설계할 수 있습니다.

이론 중심의 강의이기 때문에 별도의 실습 환경이 필요하지 않습니다.

강의 교안을 PDF 파일 형식으로 첨부합니다.

LLM의 역사와 발전: 언어 모델의 기원에서 최신 기술까지

학습 대상은

누구일까요?

LLM의 기원과 발전 과정 및 기술 동향을 알고 싶은 분

LLM의 기반이 되는 인공신경망 구조를 알고 싶은 분

LLM을 직접 개발하기 위한 이론 지식을 쌓고 싶은 분

전체

72개 ∙ (10시간 39분)

해당 강의에서 제공:

월 ₩19,800

5개월 할부 시

₩99,000

지식공유자님의 다른 강의를 만나보세요!

같은 분야의 다른 강의를 만나보세요!