인프런 커뮤니티 질문&답변

훈련 중 validation_loss가 급격하게 튀는 이유가 무엇인지 알 수 있을까요?

작성

·

2.1K

0

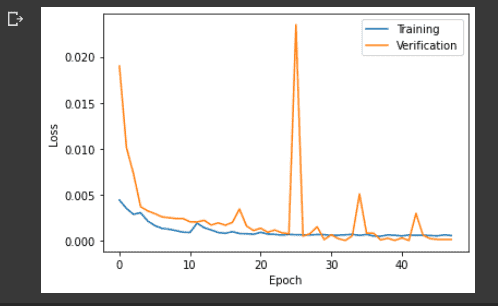

안녕하세요. 혹시 모델 훈련 중에 다음과 같이 한 두 번씩 validation loss가 튀는 현상이 발생하는데, 이는 정상적인 것인가요?

아니면 현재 lr 값이 너무 커서 불안정한 상태인 것인지 판단이 잘 안서서, 경험상 어떤 것이 맞는지 조언을 얻어봐도 될까요?

답변 3

1

권 철민

지식공유자

안녕하십니까,

validation loss가 iteration 하면서 튈수도 있습니다. 정상적인 모습이지만, 비교적 자주 튄다면 Learning rate를 줄여 보면서 관찰할 필요가 있습니다.

Learning rate를 iteration 수행시 ReduceLROnPlateau 등으로 좀더 작게 주면서 loss 변화를 확인해 보십시요(ReduceLROnPlateau 사용하는 것이 익숙하지 않다면, 초기 learning rate를 훨씬 작은값으로 넣고 확인해 보십시요).

감사합니다.

0

0