인프런 커뮤니티 질문&답변

query 에 대한 answer 결과값이 나오지 않습니다.

작성

·

27

0

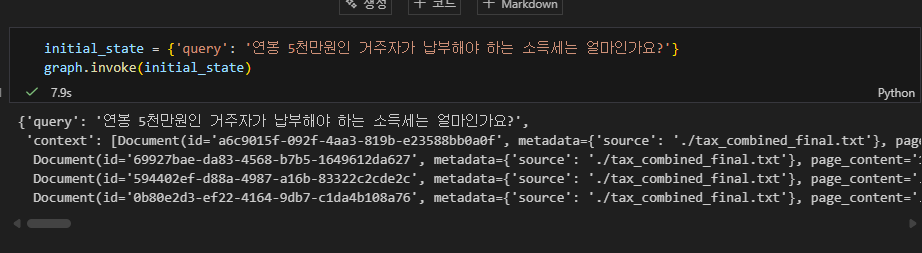

강의 모두 코드 똑같이 돌리고 db만 pinecone 을 사용하였습니다 ! 결과에 강의처럼 answer이 나오지 않는데 원인을 잘 모르겠습니다 ㅜ

gpt 에 검색해보면

전체 코드를 꼼꼼히 검토해본 결과, 질문하신 "결과(answer)가 나오지 않는 이유"는 크게 두 가지입니다. 하나는 데이터가 유실되는 방식의 반환(return) 때문이고, 다른 하나는 무한 루프(Infinite Loop) 가능성 때문입니다.

1. 가장 큰 원인: State 데이터 유실

LangGraph의 각 노드 함수(retrieve, generate, rewrite 등)는 AgentState를 반환할 때, 기존의 데이터를 포함해서 돌려주어야 합니다.

현재 작성하신 코드를 보면:

retrieve함수:return {'context': docs}(이때query가 사라짐)generate함수:return {'answer': response.content}(이때query,context가 모두 사라짐)

이렇게 나오는데 제가 봤을땐 이게 원인은 아닌것같습니다...!

1.질문을 정확하게 LLM이 정확하게 리트리버할수 있게 질문을 한상태인데

판단결과가 irrelevant가 나왔고 엣지에서 질문과 리트리버된 문서와 의 관련도가 없으면 바로 END 되버리는 상황입니다.

정확하게 질문을 했는데 왜 결과가 나오지 않는지 잘 모르겠습니다!