인프런 커뮤니티 질문&답변

OOM의 원인에 대해서 궁금한 점이 있습니다

작성

·

5.2K

0

안녕하세요

모델을 훈련할 때 GPU 하드웨어 부족으로 인해 발생하는 OOM 문제의 원인은 여러가지로 있는 것 같습니다

여러가지 원인 중 해결방법은 레이어들의 총 파라미터 합을 낮춰야 하는 것인가요?

레이어 층의 깊이보다는 이미지 사이즈 (리사이즈 여부 등 )으로 발생하는 파라미터 갯수를 낮추면 될까요?

주로 아래 Error로 훈련을 중지하게 됩니다

OOM when allocating tensor with shape[64,64,256,256] and type float on /job:localhost/replica:0/task:0/device:GPU:0 by allocator GPU_0_bfc [Op:Conv2DBackpropInput]

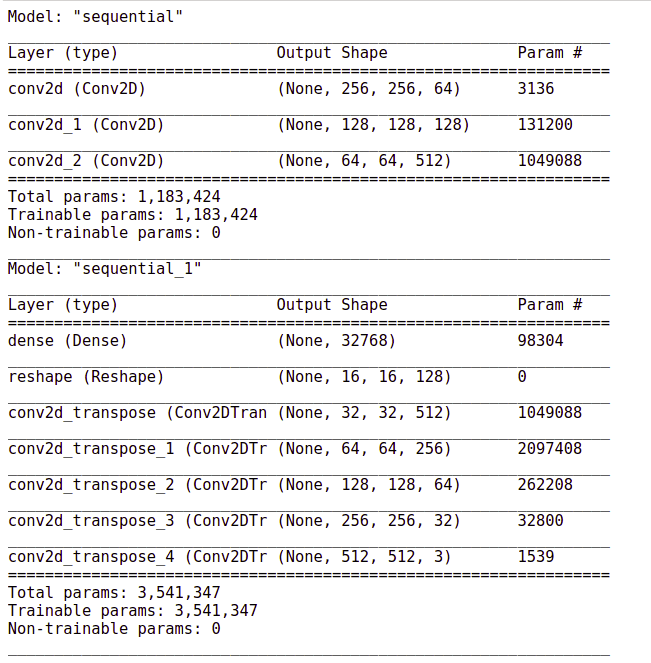

layer summary는 아래와 같습니다

답변 1

0

권 철민

지식공유자

안녕하십니까,

OOM을 방지하는 가장 좋은 방법은

1. Batch Size를 줄인다.

2. 이미지 크기를 줄인다.

3. GPU의 Memory를 늘린다.

2번의 경우에 이미지 크기를 줄이면 예측 성능이 감소 할 수 있습니다. 가장 좋은 건 Batch Size를 줄이는 것입니다.

모델의 parameter개수가 3.54M 정도면 큰 모델은 아닙니다. Batch size를 먼저 줄여 보시죠.