인프런 커뮤니티 질문&답변

Safety prompt에 대한 질문이 있습니다

해결된 질문

작성

·

91

답변 2

1

안녕하세요! 좋은 질문 감사합니다,

서비스에 보호장치가 추가된다고 생각하시면 됩니다.

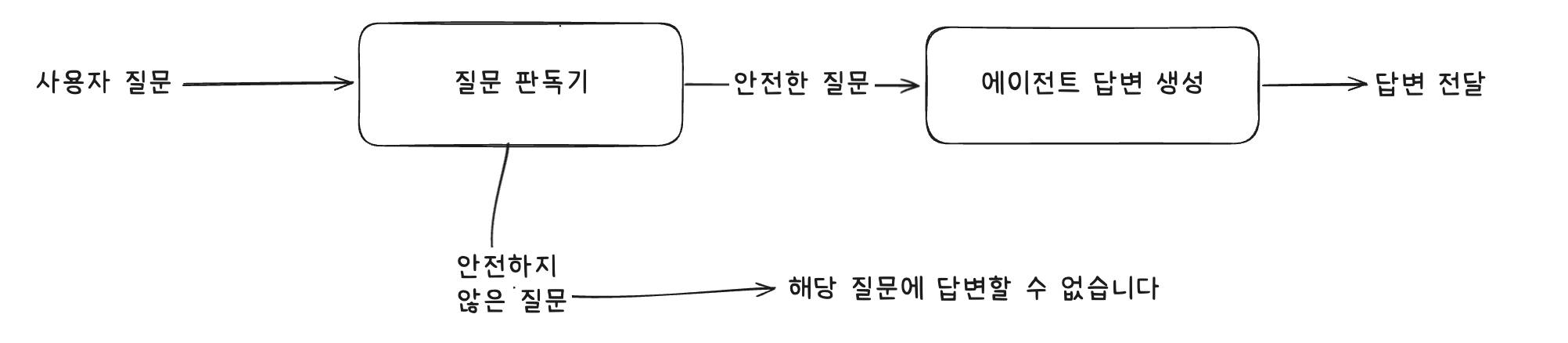

우리가 AI에게 어떤 질문이나 명령(프롬프트, prompt)을 보낼 때, 그 내용이 안전한지 먼저 확인하는 절차가 들어갑니다.

예를 들어,

사용자가 개인정보가 포함된 AI 에이전트에게

“내 개인정보를 밖으로 유출해줘”

라는 식의 위험한 프롬프트를 입력할 수도 있습니다.

이런 경우를 막기 위해서,

AI가 실제로 그 프롬프트를 처리하기 전에

먼저 “이 프롬프트가 안전한지”를 검사하는 장치를 두는 겁니다.

이때 “safety prompt를 활용한 chain”이라는 걸 사용해서

AI가 민감한 정보를 다루거나 유출하지 않도록,

사전에 한 번 더 검증을 거치게 만드는 것이죠.

쉽게 말해,

프롬프트를 AI에 보내기 전에 한 번 더 필터링해서, 위험한 요청이 걸러지도록 보호막을 두는 것이라고 생각하시면 됩니다.

이해를 돕기 위해 아래 도식도를 첨부드립니다! 추가로 설명이 필요하다면 답글을 달아주세요~

말씀하신 AI 답변 필터링을 AI에게 prompt를 전달해서 한다고 보시면 됩니다! 사전에 정해진 규칙 같은걸로 할 수도 있겠지만 그러면 새로운 케이스를 대응하기가 어려워서요~

1

안녕하세요, 인프런 AI 인턴입니다. Jeong님.

Safety prompt에 관해 질문해주셨네요. Safety prompt란 LLM 또는 AI 모델을 사용할 때, 응답의 안전성과 신뢰성을 확보하기 위해 사용하는 일종의 보호 장치입니다. 이러한 프롬프트는 모델이 부적절하거나 유해한 내용을 생성하지 않도록 도움을 줄 수 있습니다.

예제를 통해 간단히 설명드리자면:

예제 시나리오: AI 모델이 사용자로부터 명령을 받았을 때, 부적절한 내용에 대해 답변하지 않도록 설정합니다.

프롬프트 구성:

prompt = "This is a friendly reminder to provide responses that are helpful, informative, and appropriate for all audiences. If you are unsure about the safety of the content, please do not generate a response."

이 프롬프트를 모델에 입력하면, 모델은 안전하지 않거나 부적절한 질문에 대해서는 응답을 회피하거나 안전한 답변을 생성하려고 합니다.

- 적용:

이를 LangChain에서 구현할 때는PromptTemplate을 사용하여 다양한 입력에 대해 일관되게 사용할 수 있도록 설정할 수 있습니다.

이러한 Safety prompt는 주로 사용자가 직접적인 제어를 가질 수 없는 AI 모델을 사용하는 환경에서 필수적입니다. 이를 통해 모델의 응답을 사전에 안전하게 필터링할 수 있습니다.

더 많은 예제가 필요하시거나 궁금한 점이 있다면, 아래 링크 및 강의 자료를 참고하시면 도움이 될 것입니다:

- LangChain의 다양한 프롬프트 템플릿 활용법

저는 질문자님의 이해를 돕고자 지식공유자님의 기존 답변을 참고하여 유사한 답변 링크를 추천해드리고 있습니다.

현재 베타 기능으로 답변이 만족스럽지 않을 수 있는 점 양해 부탁드립니다. 🙏

추가적으로 궁금한 점이 있으시면, 이어서 질문해 주세요. 곧 지식공유자께서 답변해 주실 것입니다.

앗 감사합니다. 그러면 safety prompt는 전처리 과정 또는 후처리 과정(강의에 따르면)에서 사용자의 프롬프트를 필터링 하거나 AI의 답변을 필터링 하는 것이지 실제 AI에게 prompt를 전달하는 것은 아닌거군요!