![[VLM101] Tạo chatbot đa phương thức bằng fine-tuning (feat.MCP / RunPod)Course Thumbnail](https://cdn.inflearn.com/public/files/courses/337551/cover/01jzjdkw9evbt245h3w2mdfs2r?w=420)

[VLM101] Tạo chatbot đa phương thức bằng fine-tuning (feat.MCP / RunPod)

dreamingbumblebee

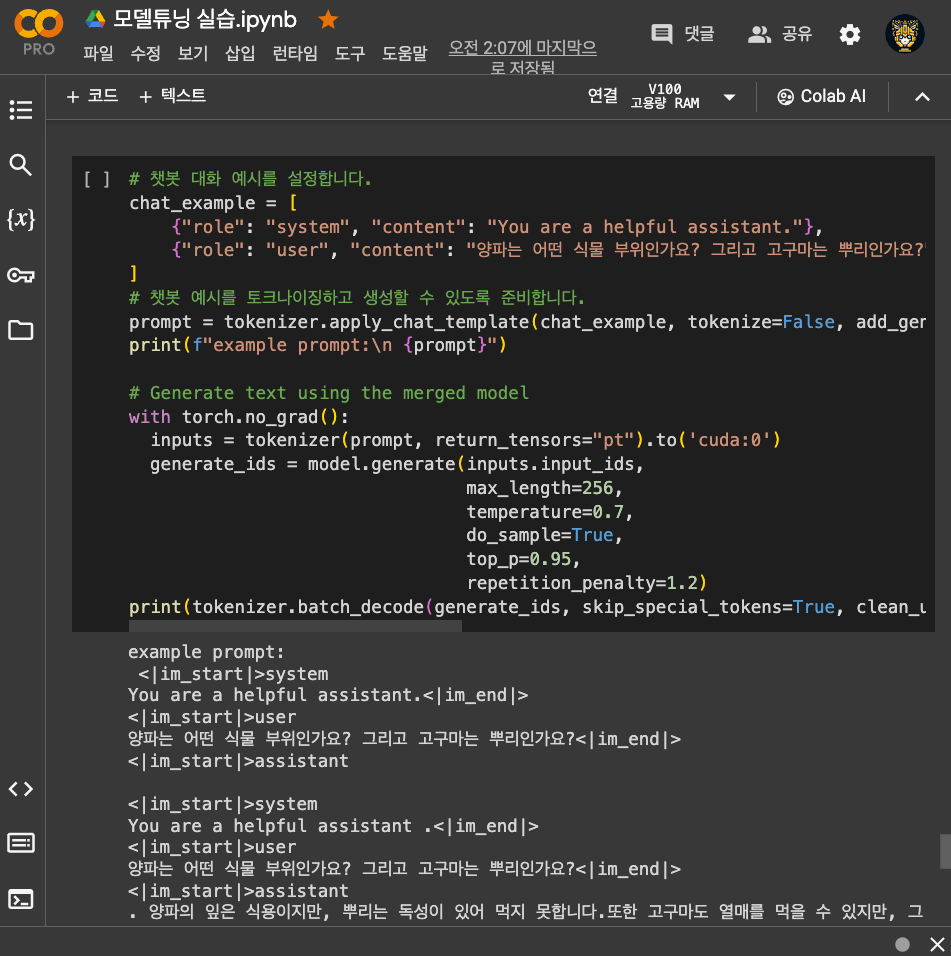

Đây là khóa học dành cho người mới bắt đầu giúp hiểu về khái niệm và cách sử dụng Mô hình Thị giác-Ngôn ngữ (Vision-Language Model, VLM), đồng thời thực hành chạy mô hình LLaVA trên môi trường Ollama và tích hợp với MCP (Model Context Protocol). Khóa học này bao gồm nguyên lý của mô hình đa phương thức, lượng tử hóa (Quantization), phát triển dịch vụ và demo tích hợp, đồng thời cung cấp cân bằng giữa lý thuyết và thực hành.

Basic

Vision Transformer, transformer, Llama

![[Thực chiến AIoT] Chuẩn bị hoàn hảo cho Makerthon Gương thông minh: Từ LLM, CV đến thiết kế phần cứngCourse Thumbnail](https://cdn.inflearn.com/public/files/courses/340196/cover/01kexgfr26whtfsmsqd2dj1x7x?w=420)