인프런 커뮤니티 질문&답변

supabase vector store 에러 "unsupported Unicode escape sequence 400 Bad Request"

작성

·

91

·

수정됨

0

안녕하세요. 강의 잘 듣고 있습니다.

강사님 혹시 이런 이슈 만난 적 있으신가요?

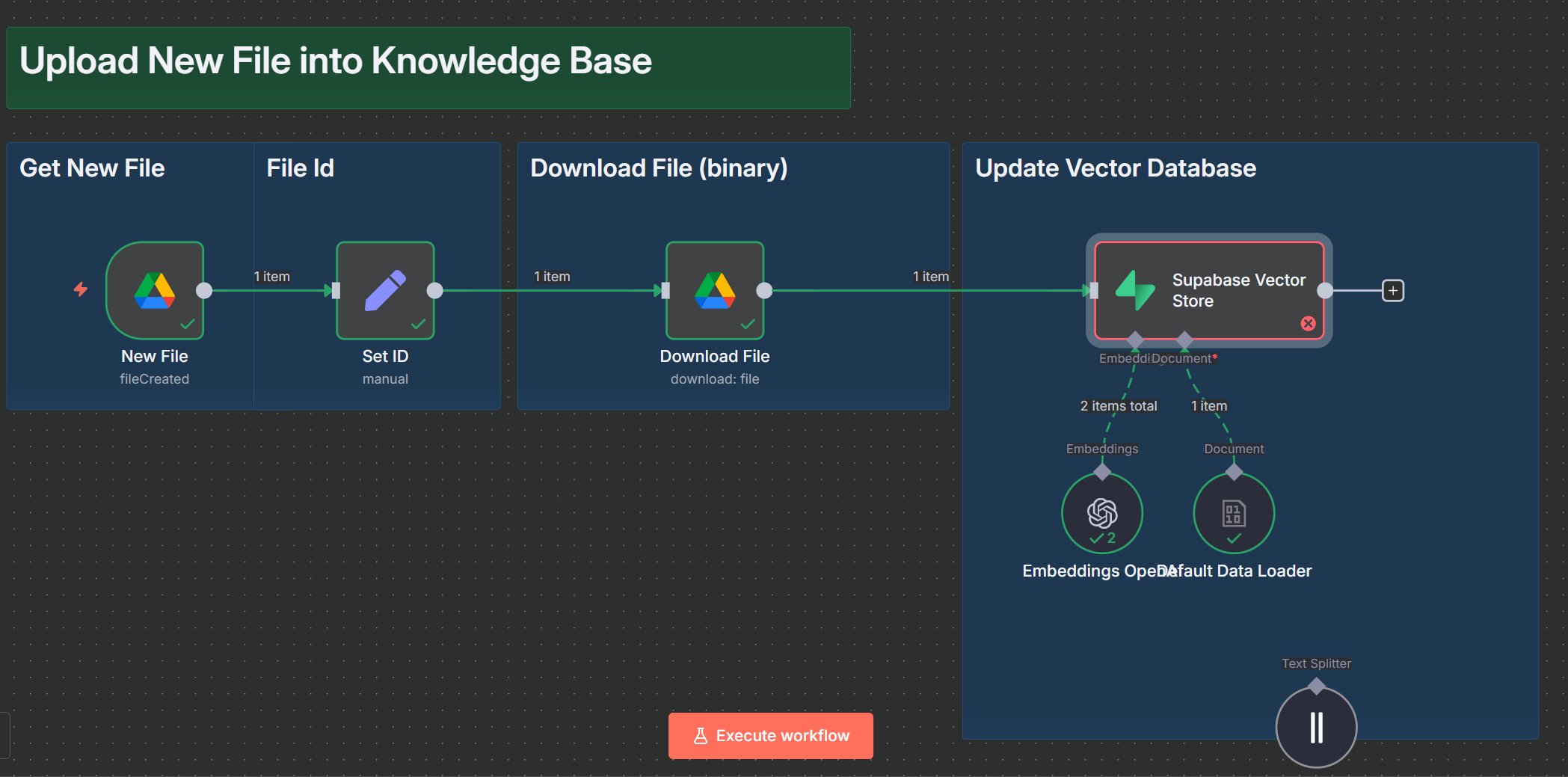

n8n 에서 pdf 파일을 binary 형식으로 supabase vector store 입력 중 생기는 에러 입니다. 어떤 pdf 파일은 되고 어떤 pdf 파일은 에러 발생으로 멈춥니다.

binary 를 json 으로 변경 후 DB table 쪽 jsonb 컬럼에 입력 할 항목 스캔하면 '\x00' 문자들이 몇개 있습니다.

python 직접 코딩 streamlit, LangChain 으로 같은 로직, 같은 파일을 supabase vector store로 입력하면 문제 없이 임베딩 처리 후 입력이 됩니다.

Issues:

Error inserting: unsupported Unicode escape sequence 400 Bad Request

답변 2

0

안녕하세요! 일단 저는 해당 에러를 직접 겪어본 적은 없습니다.

다만 에러메세지를 통해서 보기에는 유니코드 이슈인 것 같은데요, code block을 활용해서 처리가 가능한지 한번 확인해보시고, 처리한 후에 업데이트를 해야할 것 같은데... 왠지 n8n으로 해결은 어려울 것 같고, file을 drive로 업로드하기 전에 한번 전처리를 하신 다음에 해당 워크플로우를 실행해야하는게 아닌가 싶습니다 ㅠㅠ

0

안녕하세요, 인프런 AI 인턴입니다.

엔지개그님, Supabase vector store를 사용할 때 “unsupported Unicode escape sequence 400 Bad Request” 에러를 만나셨군요. 이 문제는 보통 데이터의 인코딩 문제와 관련이 있습니다. n8n을 사용해서 PDF 파일을 Supabase에 삽입할 때 발생하는 문제라면, 몇 가지 해결 방안을 고려해볼 수 있습니다.

인코딩 형식 확인: PDF 파일을 처리할 때, binary 데이터가 JSON으로 변환되는 과정에서 인코딩이 문제를 일으킬 수 있습니다. ‘\x00’와 같은 NULL 문자나 특수문자가 JSON 형태로 변환되면서 문제가 될 수 있으므로, 해당 문자를 제거하거나 인코딩 형식을 UTF-8로 지정해보세요.

Supabase와 n8n 설정 확인: 특정 PDF 파일에서만 문제가 발생하는 점을 고려하면, 원본 PDF 파일에 특수 문자나 바이너리 데이터가 포함되어 있을 가능성도 있습니다. Supabase의 vector store 설정을 확인하고, 해당 데이터가 어떻게 처리되는지도 점검해 보세요.

OpenAI 모델 및 Text Splitter 확인: OpenAI 모델 및 Text Splitter 설정에서 예상치 못한 문자가 인코딩되는지를 확인해주세요. 데이터를 처리하는 중간 단계에서 특수문자 처리를 어떻게 하는지 살펴보시는 것도 좋을 것 같습니다.

유사한 문제가 논의된 다른 게시물을 참고하시면, 아래 URL에서 찾아보실 수 있습니다:

- 몇몇 PDF 파일에서 Supabase Vector Store로의 변환 문제: 이 게시물은 PDF 파일을 변환할 때 발생하는 문제와 인코딩 문제에 대한 일반적인 해결책을 다룹니다.

위의 방법들로 해결되지 않으면, 추가적인 로그나 문제 내용과 함께 조금 더 세부적인 정보를 제공해 주시면 보다 자세한 도움을 드릴 수 있을 것 같습니다.

저는 질문자님의 이해를 돕고자 기존 답변을 참고하여 유사한 답변 링크를 추천해드리고 있습니다.

현재 베타 기능으로 답변이 만족스럽지 않을 수 있는 점 양해 부탁드립니다. 🙏

추가적으로 궁금한 점이 있으시면, 이어서 질문해 주세요. 곧 지식공유자께서 답변해 주실 것입니다.