인프런 커뮤니티 질문&답변

wb.json , pandas.json 파일을 jupyter notebook 환경에서 read 가 안됩니다..ㅠ

해결된 질문

작성

·

460

·

수정됨

0

현재 AWS Glue 4.0 docker 이미지를 내려 받아 pyspark 커널에서 사용 중이며 섹션 8 판다스 환경에서 airbnb..csv, analyzed_americsv_2023.csv 파일은 문제 없이 잘 열리는데

Json 파일만 열리지 않습니다..ㅠ

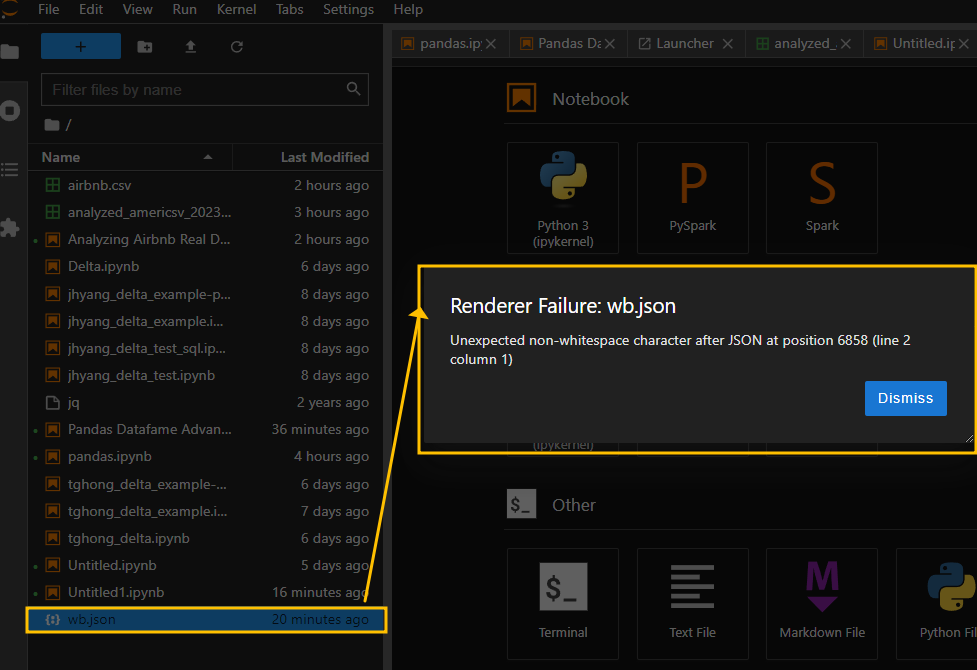

Renderer Failure: wb.json

Unexpected non-whitespace character after JSON at position 6858 (line 2 column 1)

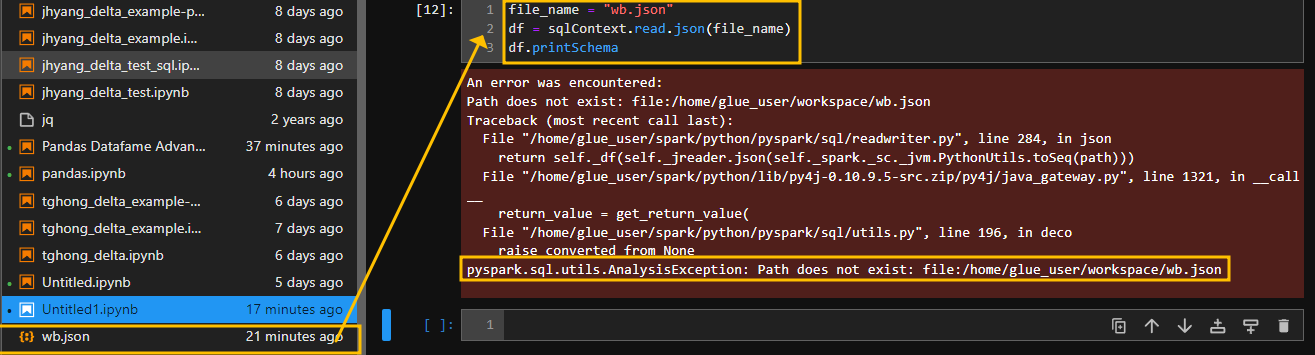

file_name = "wb.json"

df = sqlContext.read.json(file_name)

df.printSchema

pyspark.sql.utils.AnalysisException: Path does not exist: file:/home/glue_user/workspace/wb.json

__

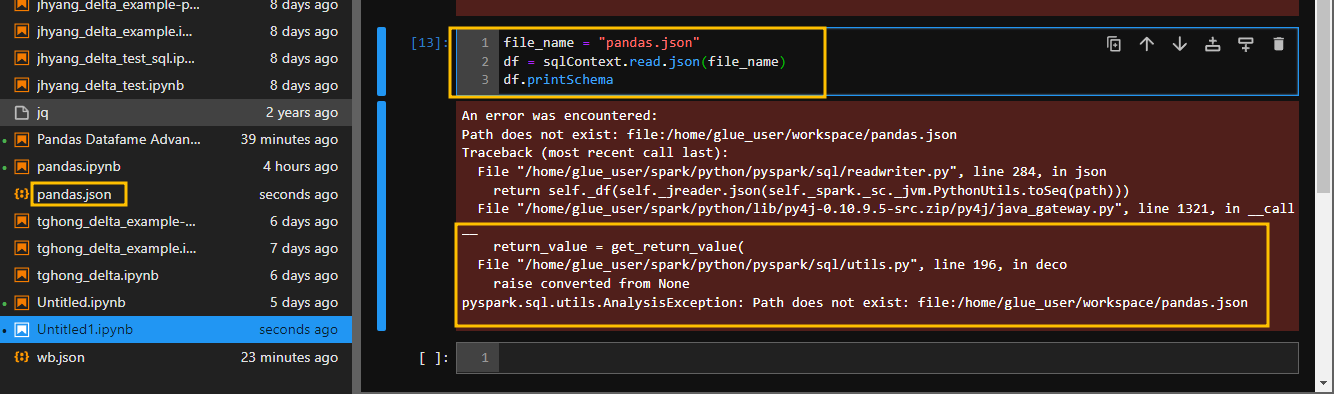

file_name = "pandas.json"

df = sqlContext.read.json(file_name)

df.printSchema

return_value = get_return_value(

File "/home/glue_user/spark/python/pyspark/sql/utils.py", line 196, in deco

raise converted from None

pyspark.sql.utils.AnalysisException: Path does not exist: file:/home/glue_user/workspace/pandas.json

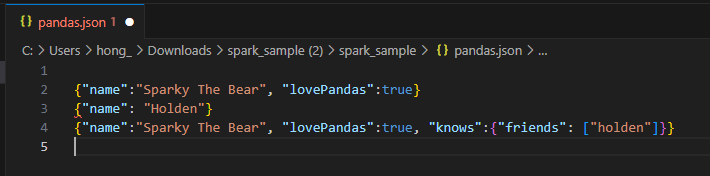

pandas.json 윈도우 로컬 환경에서 열면

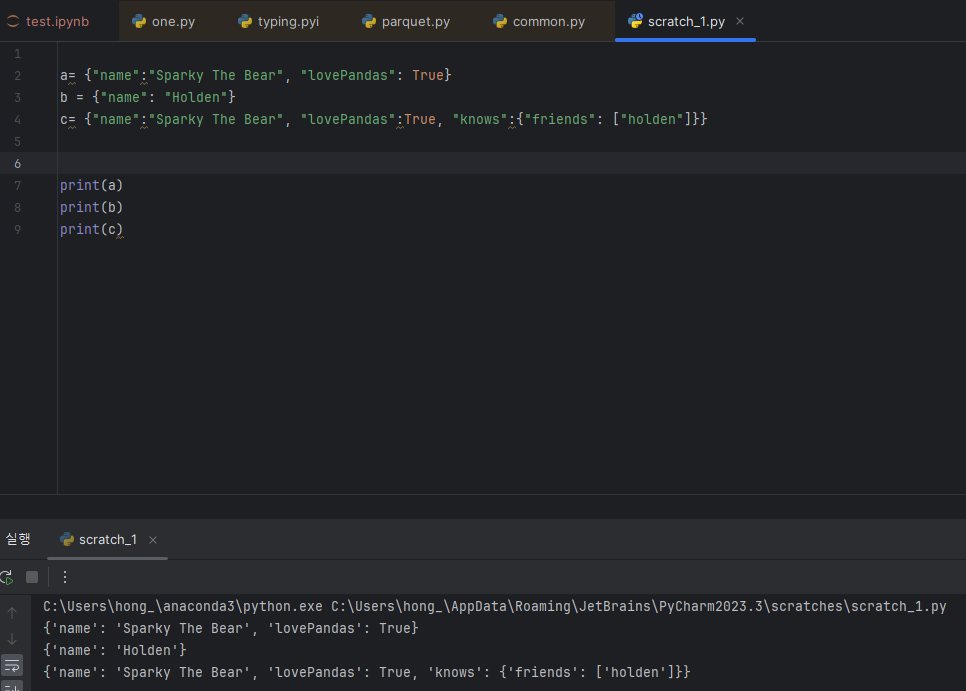

두번째 행에서 첫번째 에서 빨간줄이 나옵니다 혹시 각 딕셔너리를 담는 변수는 따로 필요가 없을까요?

답변 3

1

네 파일 안을 따로 수정하지 않으셨으면 큰 문제없이 돌아갈겁니다.

pyspark를 docker로 실행하셨다고 했는데 도커에서 로컬 파일을 읽으려면 따로 mount가 필요합니다. 아니면 저 인풋파일들을 실행하신 도커 컨테이너안에 복사하신다음 다시 컨테이너내 경로를 정확히 설정하셔서 진행하시면 풀릴 것으로 보입니다.

1

안녕하세요, 인프런 AI 인턴입니다. 홍태경님의 질문과 매우 유사한 문제를 다룬 기존 게시글을 찾았습니다. 이러한 문제는 대개 JSON 파일 경로 오류, JSON 파일 형식 문제, 혹은 pyspark.sql의 사용법 오류로 발생합니다. 아래 URL은 유사한 상황을 겪은 다른 학습자와 해당 문제에 대한 지식공유자의 답변 링크입니다:

Hadoop 기본 제공 MapReduce 실행 에러: 이 질문에서는 Hadoop의 MapReduce 작업 실행 중 발생한 에러에 관한 내용을 다루고 있습니다. 이와 마찬가지로 파일 경로 오류나 환경 설정 문제로 실행에 실패할 수 있음을 보여줍니다. 비록 직접적인 pyspark 사용법에 대한 내용은 아니지만, 데이터 분석 혹은 데이터 프로세싱 과정 중 발생할 수 있는 일반적인 문제의 진단과 해결방법에 대한 이해를 돕습니다.

스파크로 HDFS 구동하기: Spark를 이용하여 HDFS 상에서 데이터를 처리하는 방법에 대해 나와 있습니다. 파일 경로 확인, 파일 존재 여부 확인과 같이 PySpark를 사용하여 JSON 파일을 읽을 때 고려해야 할 요소들에 대한 중요성을 강조합니다.

질문하신 내용을 바탕으로, 두 가지 가능성을 확인해보시기 바랍니다:

1. 파일 경로가 정확한지 확인: Jupyter Notebook 혹은 PySpark에서 사용한 파일 경로가 실제 JSON 파일의 위치와 일치하는지 확인해 보시기 바랍니다. 오류 메시지에서는 file:/home/glue_user/workspace/wb.json이 존재하지 않는다고 나타나고 있습니다. 이는 wb.json와 pandas.json 파일이 예상한 위치에 없거나, 경로가 잘못 지정되었을 수 있음을 의미합니다.

- JSON 파일 형식 확인:

wb.json파일을 직접 열어서 JSON 형식이 올바른지, 특히 에러 메시지에서 언급된 위치 대략position 6858부근에 문제가 없는지 확인해 보시기 바랍니다.

주어진 상황에서 정확한 원인을 특정하기 어려울 수 있으나, 위 두 가지를 점검해 보는 것이 좋을 것 같습니다.

저는 질문자님의 이해를 돕고자 지식공유자님의 기존 답변을 참고하여 유사한 답변 링크를 추천해드리고 있습니다.

현재 베타 기능으로 답변이 만족스럽지 않을 수 있는 점 양해 부탁드립니다. 🙏

추가적으로 궁금한 점이 있으시면, 이어서 질문해 주세요. 곧 지식공유자께서 답변해 주실 것입니다.

0