인프런 커뮤니티 질문&답변

app-<timestamp>-<executor_id> 폴더가 spark-events 내부에 생기게 하고 싶습니다.

작성

·

263

·

수정됨

1

안녕하세요? 강의 자료로 주신 docker-compose 파일을 바탕으로 실습을 하고 있습니다.

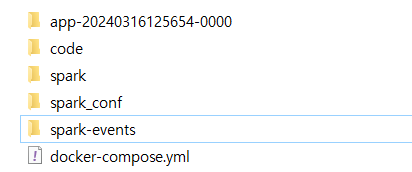

프로그램을 실행할 때 마다 app-<timestamp>-<executor_id> 형식의 폴더가 docker-compose.yml가 위치한 곳과 같은 곳에 생기는데, 저는 spark-events 내부에만 저장하고 싶은데 어떤 설정을 해야 하는지 잘 모르겠습니다...

spark-defaults.conf

spark.eventLog.enabled true

spark.eventLog.dir file:/tmp/spark-events

spark.history.fs.logDirectory file:/tmp/spark-events

강의 자료에 나온 docker-compose.yml 중 spark의 volumes와 enviroment 부분

volumes:

- .:/opt/bitnami/spark/work

- ./spark_conf/log4j2.properties:/opt/bitnami/spark/conf/log4j2.properties

- ./spark_conf/spark-defaults.conf:/opt/bitnami/spark/conf/spark-defaults.conf

- ./spark-events:/tmp/spark-events

environment:

- SPARK_MODE=master

- SPARK_RPC_AUTHENTICATION_ENABLED=no

- SPARK_RPC_ENCRYPTION_ENABLED=no

- SPARK_LOCAL_STORAGE_ENCRYPTION_ENABLED=no

- SPARK_SSL_ENABLED=no

- SPARK_USER=spark

spark 프로그램 실행시 app 폴더가 생기는 사진

답변 1

0

안녕하세요 성범강님,

아마도 working directory를 말씀하시는 것 같은데, 이는 spark event 디렉토리와 다릅니다. 제가 Notebook으로 현재 강의 들으시는 파일을 실행했는데 이 디렉토리는 안 만들어지는데, 혹시 다른 영상을 보시면서 이 문제를 해결 하시고 싶은 건가요? 아마도 뒤쪽에 Kafka 강의를 들으시면 이러한 폴더가 생기게 되는데 이는 Spark Worker에서 만든 working directory configuration 때문입니다.

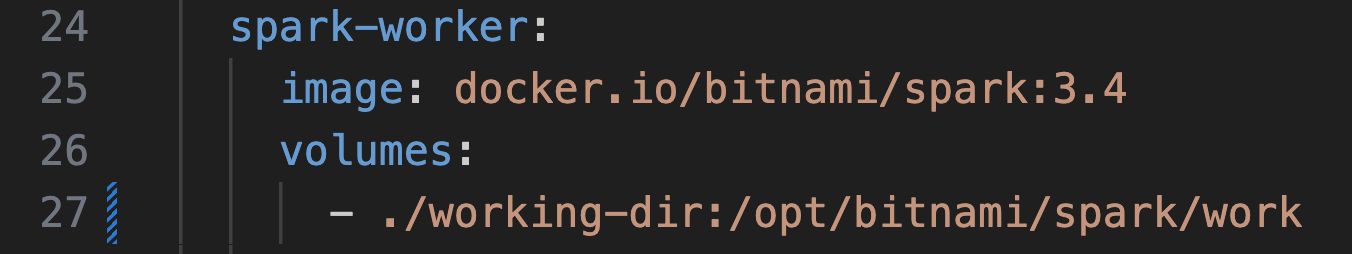

이 디렉토리의 위치를 바꾸시고 싶다면, spark-worker container에서 volumnes 로컬 위치를 바꾸어 주시면 됩니다.

아래와 같이 ./working-dir라고 앞부분을 바꿔주시면 현재 디렉토리 working-dir 디렉토리가 생기면서 거기에 저장될 겁니다.

./spark-events 디렉토리는 event를 위한 디렉토리라 같은 곳에 넣는 것을 추천하지는 않습니다.

답변 감사합니다!

이미 MLLIB 이전까지 수업을 듣고, 어디에다 질문할 지 몰라서 이 강의에서 질문했습니다. 알려주신대로 수정했더니 잘 되네요!