인프런 커뮤니티 질문&답변

scale=9를 늘릴경우 분배가 다르게 나타납니다.ㅜ

작성

·

198

1

systemctl status docker

systemctl status kubelet

전부 active 입니다.

scale=6은 잘됩니다..

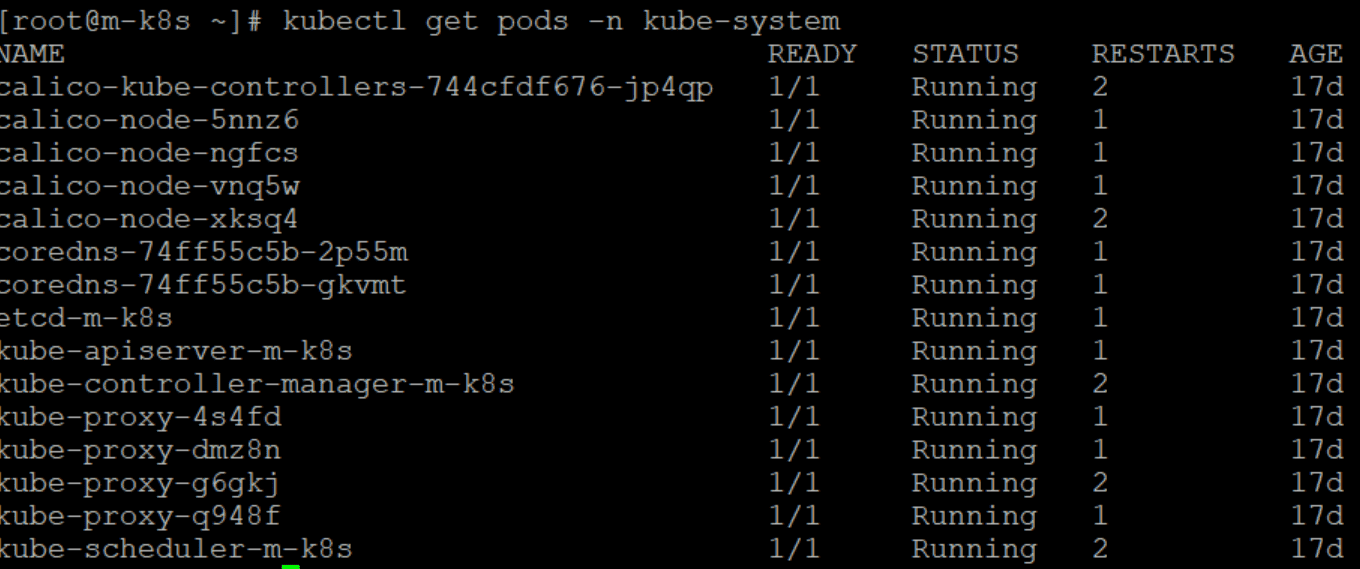

kubectl get pods -n kube-system

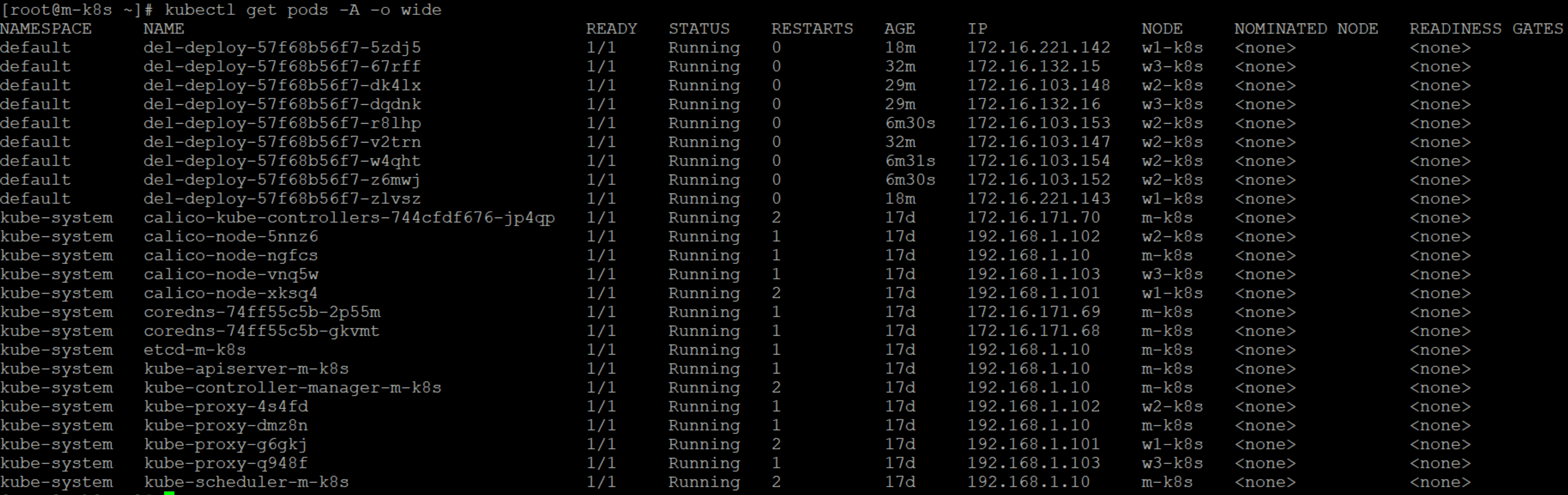

kubectl get pods -A -o wide

입니다..꼬인부분이 있을까요.. ㅜ.ㅜ

답변 2

0

중요한건 분배를 항상 (전체 9개인 경우) 3개씩을 보장하지 않아요.

노드의 상태를 보고 결정하는거라서요

3개씩 꼭 하고 싶다면 분배 제약 조건등을 써야 합니다.

0

안녕하세요

이거만 봐서는 여전히 알기가 ...어려운데...무조건 노드에 3개씩 배포하도록 하는건 아니라서요

스케줄링을 하는 시점에 노드의 상태 정보를 계산해서 하는거라서요.

어떤 이유로 w3-k8s 할당이 적은지 알기 위해서는 알아봐야 할 것들이 좀 많고...

현재 랩은 1G로 최소로 설정되어 있어서요.

그리고 scale 6개까지는 2개씩 배포되는데, 9개부터 달라지는건 (항상을 의미) 아닌거 같고요.

스케줄을 조정하는건 좀 알아야 할 내용이 많아서...

https://github.com/sysnet4admin/_Lecture_k8s_learning.kit

알아야 할 주제 관련은 여기 ch6,7을 알면 도움이 되실꺼 같아요.

위와 같은 이유로 현재 원인을 찾는 것은 쉽지 않을꺼 같고, 직접 봐야 알꺼 같아요

해결은 전체 워커 노드 껐다가 다시 키고, (커피를 1잔 마시고 오시고 / 붙는 시간)

kubectl scale deploy <이름> --replicas=1

kubectl scale deploy <이름> --replicas=9

하시면 해결이 되실꺼 같아요.

도움이 되시면 좋겠네요.

조훈 드림.

답변 감사합니다~! 이해가 쏙쏙 잘 강의듣고있습니다.~! 감사합니다