OpenAI 오픈소스 모델 GPT-OSS 알아보기

2025. 10. 03. 20:15

수정됨

드디어 나왔다, 오픈소스 ChatGPT — GPT-OSS

OpenAI에서 ChatGPT를 출시한 이후로 수많은 LLM들이 등장했지만, ChatGPT 자체의 오픈소스 버전은 없었습니다.

그런데 2025년 7월, GitHub에 아주 조용히, 그러나 강력한 한 줄이 올라왔습니다.

"GPT-OSS: OpenAI ChatGPT의 오픈소스 구현체"

처음 봤을 때 의심했습니다.

“진짜야? OpenAI에서 직접?”

네, OpenAI의 공식 GitHub 저장소에서 릴리즈된 것이 맞습니다. (공식 저장소 링크)

GPT-OSS란?

GPT-OSS는 OpenAI가 2025년 7월 공개한 첫 공식 오픈 웨이트(open-weight) 언어 모델입니다.

이는 GPT-2 이후 처음으로 OpenAI가 가중치(weight)를 포함한 대형 언어 모델을 외부에 공개한 사례입니다.

총 2가지 모델을 공개하였는데요 gpt-oss-20b와 gpt-oss120b 모델 입니다!

둘다 로컬환경에(스팩만 맞다면)서 동작이 가능합니다.

상세정보는 아래 적어둘게요오

gpt-oss-20b: 21B 파라미터 중 활성 파라미터 3.6B

gpt-oss-120b: 117B 파라미터 중 활성 파라미터 5.1B

공개가 되어 있습니다.

그래서 주요 특징이 뭐가 있는가? 알아볼까요???

⚙️ Mixture-of-Experts(MoE) 아키텍처 채택

GPT-OSS는 MoE 방식을 채택하였습니다 모든 파라미터를 사용하는 것이 아니라, 토큰마다 일부 전문가(Expert)만 활성화되어 효율적 추론이 가능하죠

Apache 2.0 라이선스로 공개

GPT-OSS는 Apache 2.0 라이선스로 공개가 되었습니다.

상업적 활용 포함, 자유로운 재사용 및 커스터마이징 가능이 가능하단 소리죠 ㄷㄷ

(OpenAI는 이제 땅파서 장사하나요...ㄷㄷㄷ)

나만의 챗지피티, 나만의 AI 모델도 이젠 구현 가능합니다!

프롬프트 파이프라인이나 API 서버 코드는 포함되어 있지 않음

공개된 것은 모델 가중치 및 기본 사양 / 샘플 사용법 중심인데요

Ollama나 VLLM 같은 소프트웨어를 통해서 간단하게 설치하고 실행이 가능합니다

그래서 왜 중요할까요?

지금까지의 ChatGPT 계열은 클로즈드 API 기반이었기 때문에, 개발자가 내부 구조를 파악하거나 직접 모델을 호스팅하는 것이 불가능했어요

하지만 GPT-OSS는 "ChatGPT 스타일 모델을 우리가 직접 서비스에 적용할 수 있는 첫 번째 오픈소스 기반"

(심지어 아파치 라이선스) 인거죠

특히, 자체 서버에 호스팅하거나 프라이빗한 환경(예: 사내망, 클라우드 폐쇄망 등)에서 운영이 가능해짐

-> 이게 사기인게 돈주고 GPT API 호출하지 않고 자체 클라우드에 프롬포트 엔지니어링을 통한 API 서비스 운영이 가능합니다.. ㄷㄷ

⚒️ 그럼 모델 성능을 비교해볼가요?

https://openai.com/ko-KR/open-models/

공식사이트에서 총 2가지 모델을 볼 수 있는데요 (GPT-OSS 20b, GPT-OSS 120b)

간단한 모델 정보를 보면

120b는 36계층 1170억의 파라미터가, 20b는 24계층 210억개의 파라미터가 사용된 걸 보실 수 있습니다.

로컬에서 돌릴 수 있는 모델 치고 대단하죠?

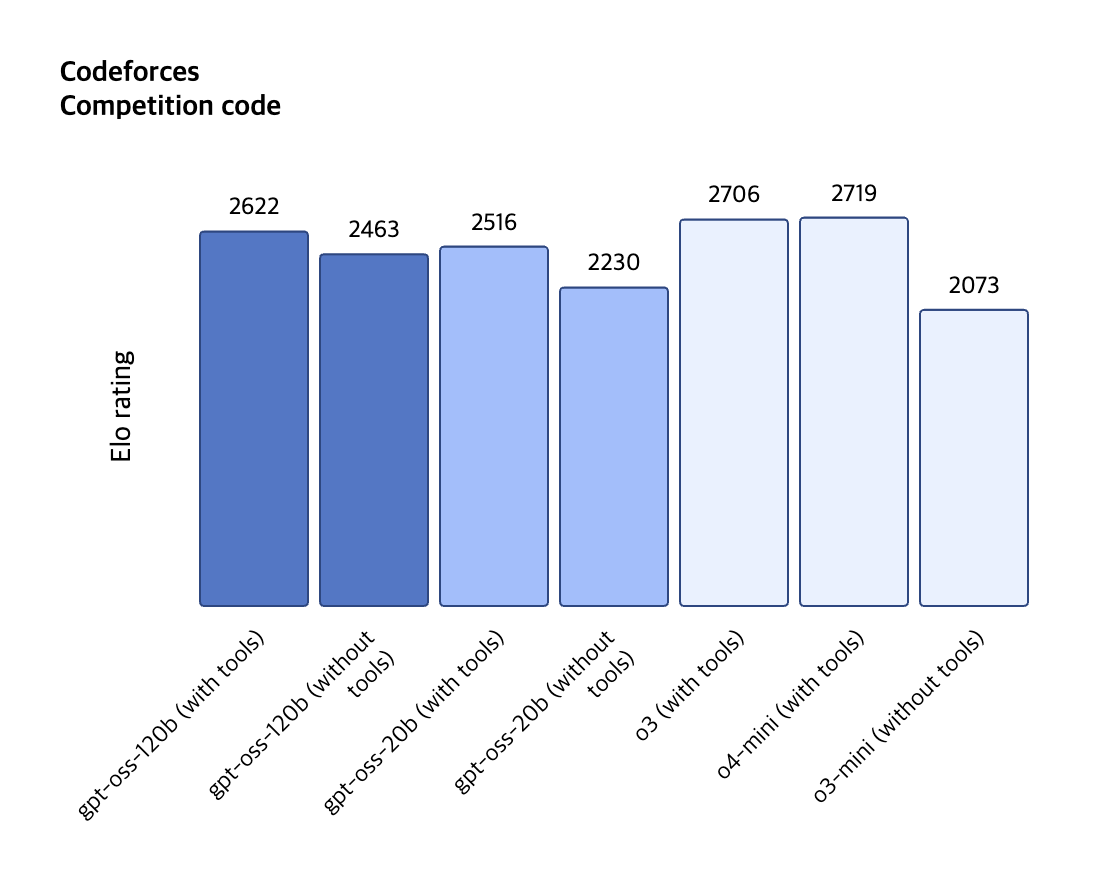

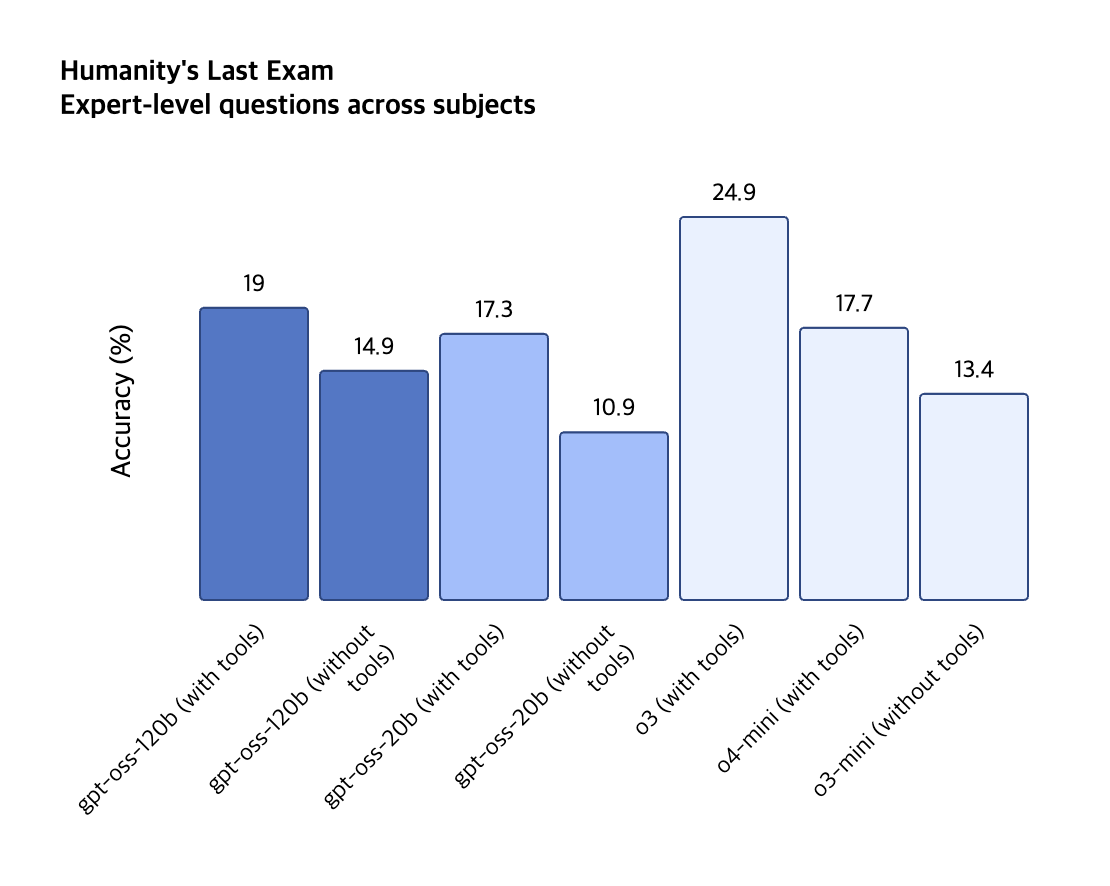

두가지 모델과 다른 GPT 모델을 벤치마킹한 결과도 한번 보겠습니다.

오 생각보다 대단하죠?

GPT-OSS-120b 는 O3와 거의 동급의 (과장하자면) 성능을 보이는 걸 볼 수 있습니다.

GPT-OSS-20b 는 GPT 4o 수준이라고 하네요.

(※ OpenRouter 벤치마크 기준으로 GPT-OSS-120b는 GPT-4o, o3 수준과 유사한 평가를 받았습니다. 단, 실제 품질은 모델 사용 환경이나 라우팅에 따라 달라질 수 있습니다.)

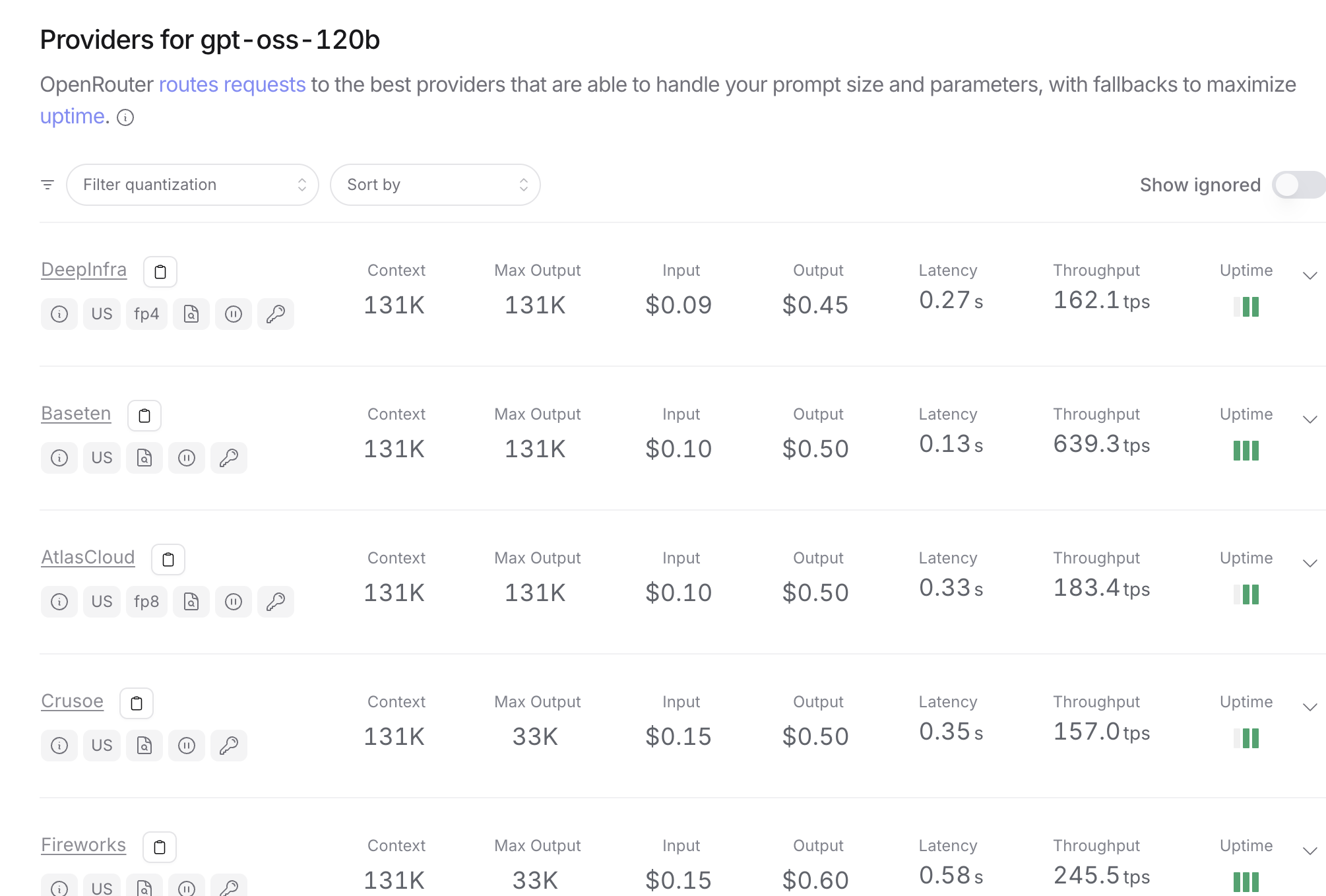

가격도 중요하죠?? 가격부분도 확인해보겠습니다.

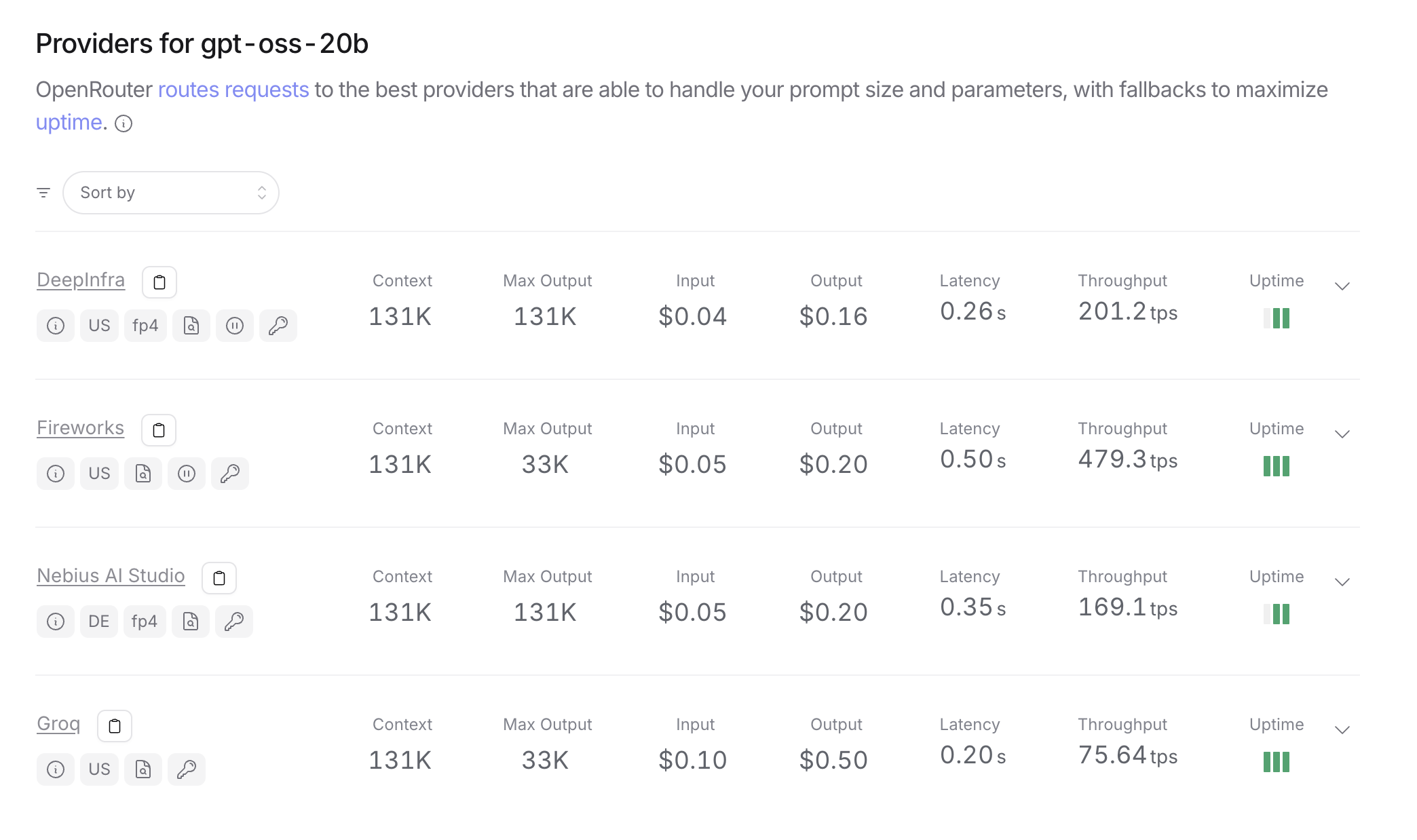

오픈라우터에서는 모델별 input, output 가격을 확인하실 수 있습니다.

먼저 GPT-OSS-120b 부터 볼게요

input 가격이 0.09달러, output 가격이 0.45 달러입니다.

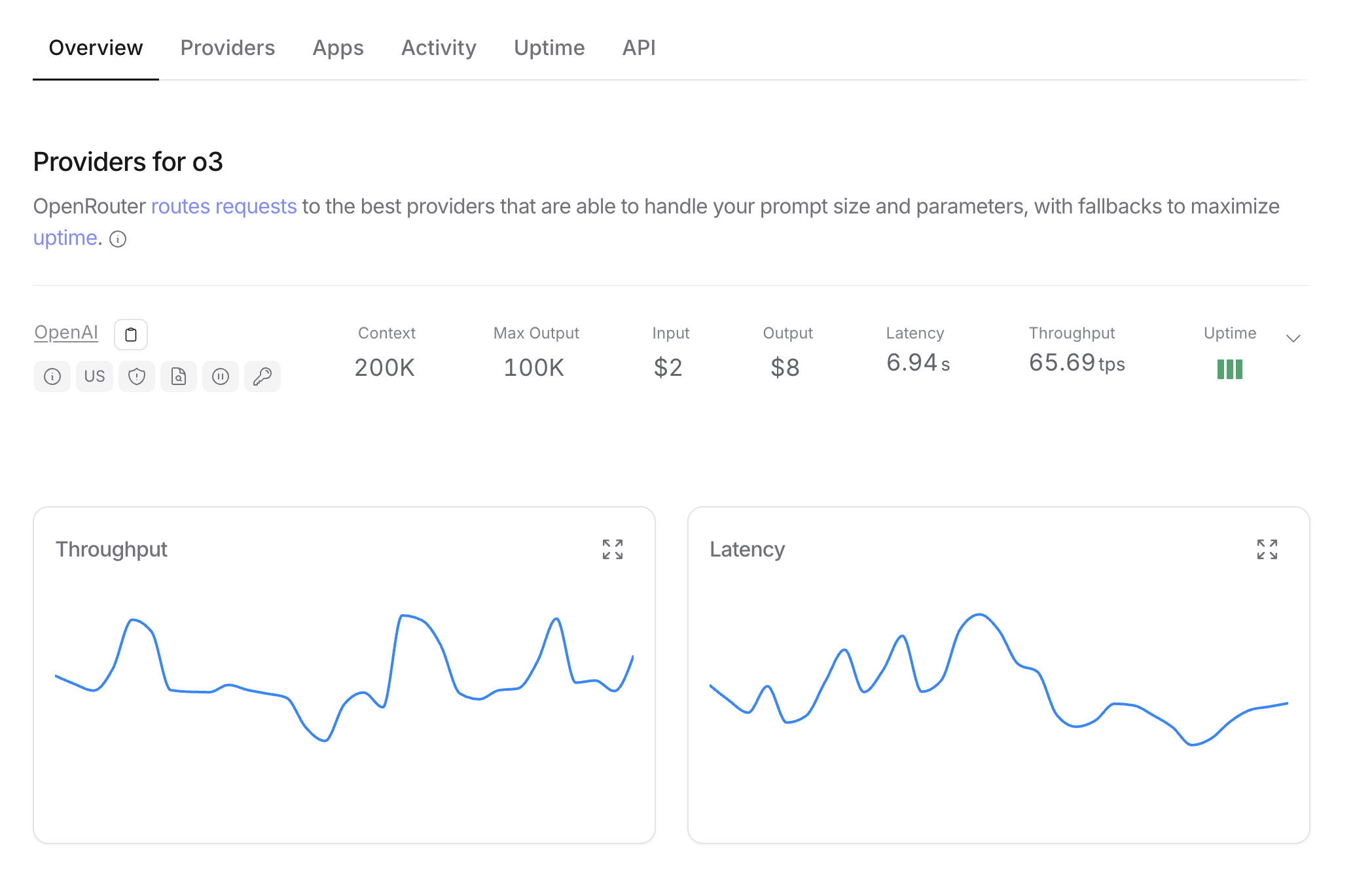

그럼 비슷한 성능을 내는 GPT-o3 가격은 얼마나 할까요?

input 2달러, output 8달러입니다.

차이가 어마어마하게 나죠?

아마 큰 차이는 머신의 성능에 따라 가격차이가 발생하는 것 같습니다.

OSS-120b 는 60G의 VRAM 을 탑재한 머신 로컬에서도 돌릴 수 있거든요.

그럼 비슷하게 로컬에서 돌릴 수 있는 딥식 R1도 볼까요?

딥식 R1 가격은 input 0.5달러 output 2.15 달러입니다.

딥식과 비교해도 OSS-120b 모델이 훨신 우수한 가격 경쟁력을 보이는거죠

(OpenAI가 딥식 견재 빡시게 하는거죠 ㅎㅎ 기술 경쟁은 선택하는 소비자인 저희만 좋아집니다.)

GPT-OSS-20b 도 한번 알아봐야겠죠?

GPT4o VS GPT-OSS-20b 가격비교

GPT-OSS-20b 는 input 0.05달러, output 0.16달러 입니다.

GPT-4o 는 input 2.5달러, output 10달러입니다.

요기선 약간 가정의 오류를 둘 수 있는데요 4o 같은 경우 OCR이나 파일분석 같은 기능이 내장되어 있어 가격이 조금 높습니다.

그래도 그 외 LLM 성능으로만 보면 둘다 비슷하지만 가격은 GPT-OSS-20b 가 훨신 저렴한 걸 알 수 있죠.

GPT-OSS 모델을 돌리기 위한 최소 사양

GPT-OSS를 로컬에서 실행하기 위한 전제 조건은 다음과 같아요

하드웨어:

gpt-oss-20b의 경우: 최소 16GB VRAM, 이상적으로는 GPU(예: NVIDIA 1060 4GB)가 필요합니다.

gpt-oss-120b의 경우: 80GB GPU 메모리(예: 단일 80GB GPU 또는 고급 데이터 센터 설정).

모델 가중치 및 종속성을 위한 20-50GB의 여유 저장 공간.

소프트웨어:

운영 체제: Linux 또는 macOS 권장; Windows는 추가 설정으로 지원됩니다.

인터넷: 초기 모델 다운로드를 위한 안정적인 연결.

종속성: GPU 가속을 사용하는 경우 NVIDIA/AMD GPU 드라이버; CPU 전용 모드도 작동하지만 더 느립니다.

벨로그 보시는 여러분들이라면 최소 16GB V램은 탑재되어 있을 것이라 생각이 드는데요 (맥북 프로라면 무리없이 돌릴 수 있어요!!)

요렇게 스팩만 충분하다면 직접 GPT-OSS 모델을 다운로드하고 돌려보실 수 있습니다!

어디서 사용하나요?

지금 GPT-OSS-120b 및 GPT-OSS-20b 모델을 여러분들이 사용해보실 수 있도록 OpenAI에서 웹사이트를 제공하고 있습니다.

에서 여러분들이 오픈소스 모델인 GPT-OSS-120b 및 GPT-OSS-20b 를 사용해보실 수 있고, 한번 접속해서 사용해보시기 바랍니다.

모델 다운로드 및 사용해보기

최초로 공개된 OpenAI ChatGPT 오픈소스 GPT-OSS 누구보다 빠르게 찍먹하기

강의를 인프런에 공개하게 되었습니다.

GPT-OSS-20b 모델을 Ollama로 다운로드하고 모델을 설치하며 1시간 정도 분량으로 GPT-OSS 를 사용해볼 수 있도록 강의를 구성하였습니다.

관심있으시면 한번 방문해보셔도 좋을 것 같아요.