-

질문 & 답변

카테고리

-

세부 분야

데이터 엔지니어링

-

해결 여부

미해결

특정 부분에서의 미동작

22.08.29 17:28 작성 조회수 228

0

안녕하십니까 ㅎㅎㅎ

이 고개만 넘기면 하둡을 본격적으로 학습할 수 있을 것 같아서 기대하며 질문 남깁니다!

참고로, 하둡 버전의 경우 말씀 주신 사이트에 가서 확인해보니 3.2.1 버전이 현재 없어서, 기존 질문 글 참고해 3.2.3 버전으로 다운 받고 실행했습니다...!

현재 제 상황을 화면으로 보여드리면 다음과 같습니다.

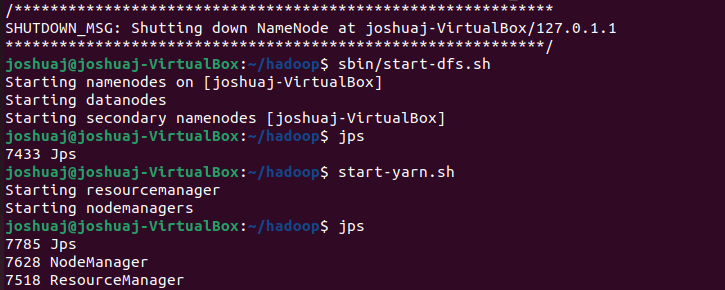

sbin/start-dfs.sh를 실행하고, start-yarn.sh를 각각 실행하고 jps로 현재 진행 상황을 확인해보니, start-yarn을 통해 NodeManager와 ResourceManager는 실행이 되는데, namenodes, datanodes 그리고 secondary namenodes가 실행이 되지 않습니다..ㅎㅎㅎ

sbin/start-dfs.sh를 실행하고, start-yarn.sh를 각각 실행하고 jps로 현재 진행 상황을 확인해보니, start-yarn을 통해 NodeManager와 ResourceManager는 실행이 되는데, namenodes, datanodes 그리고 secondary namenodes가 실행이 되지 않습니다..ㅎㅎㅎ

혹시 sbin/start-dfs.sh를 통해 namenodes, datanodes, secondary namenodes들이 실행되지 않는다면 어떤 스크립트를 중점적으로 다시 확인해봐야하는지 알 수 있을까요? (전체적으로 다시 다 리뷰하긴 했지만..)

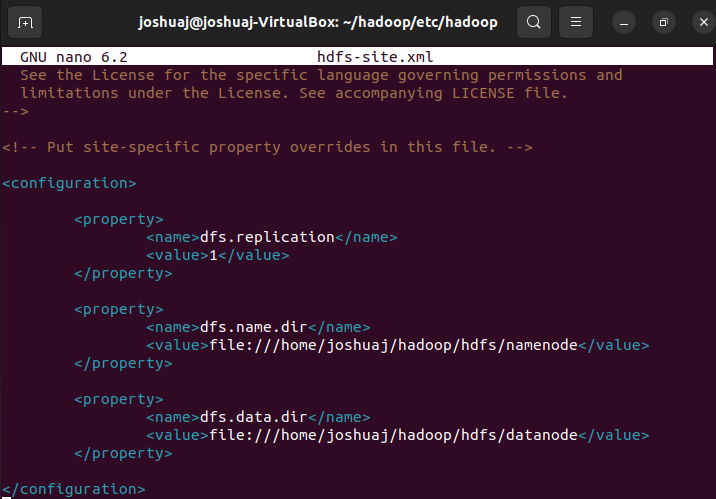

추가적으로, 저는 강의에서 나오는 파일 경로상의 neuavenue를 전부 joshuaj로 수정해놓은 상태인데 마지막에 start-dfs에서 terminal에서 나오는 건 [joshuaj-VirtualBox]라.. 혹시 파일 경로상의 joshuaj를 joshuaj-VirtualBox로 바꿔야하나요...?

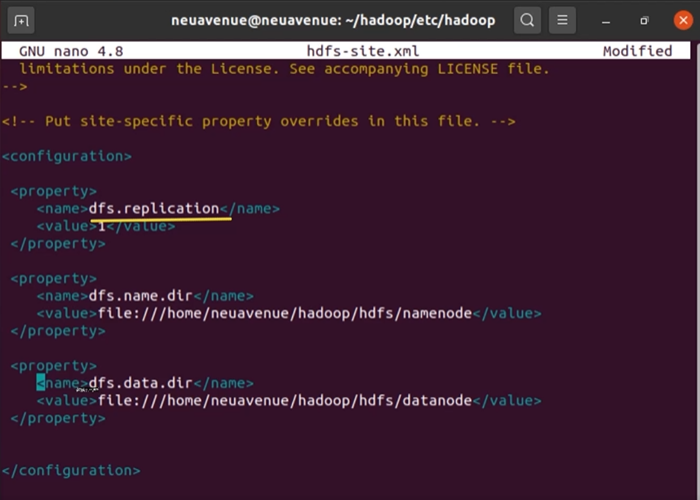

또한 오류 발생 원인으로 의심되는 부분이 또 있는데, 강의 상에서는 들여쓰기가

이렇게 되어있는데 저는 어떻게 하는지 몰라서

이렇게 되어있는데 저는 어떻게 하는지 몰라서

Tab키를 활용해

이렇게 스크립트를 적었는데 이것이 문제의 원인일 수도 있을까요?

이렇게 스크립트를 적었는데 이것이 문제의 원인일 수도 있을까요?

빅데이터 하둡 (Hadoop 3.2.1) 직접 설치하기

우분투 터미널에서 하둡 3.2.1 환경 세팅[2] - 네 가지 xml 하둡 환경 설정과 네임노드 및 포멧 하둡 서비스 실행

강의실 바로가기

답변을 작성해보세요.

0

Billy Lee

지식공유자2022.09.02

재현님

긴 켐쳐를 보내주셔서 감사합니다.

우선 core-site.xml 이 없어서 캠쳐 부탁드립니다.

또한 cd ~/hadoop/hdfs 폴더를 확인하신 뒤

sudo rm -r ~/hadoop/hdfs/*

sudo chmod -R 755 ~/hadoop/hdfs

그 뒤에 하둡 네임 노드 포멧을 하세요..

다시 디몬 서비스를 가동시키세요.

이제 jps 명령어로 확인하세요.

만약 안되면 새로운 유분투 가상 OS를 만들어 처음부터 다시 시작하세요.

토론토에서 응원합니다.

빌리 올림

0

재현

질문자2022.09.01

우선 친절한 답변 감사합니다!!

첫번째 방법 (namenode와datanode의 실제주소와 hdfs-site.xml 상의 name&datanode 주소 비교)은 해봤으나 경로가 같은 것으로 확인했습니다. 화면 첨부하겠습니다..!

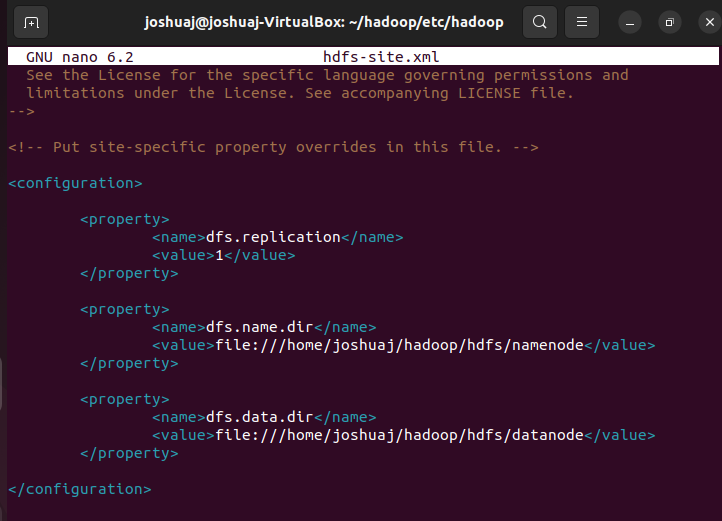

1-1) hdfs-site.xml

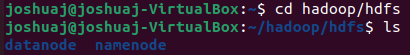

1-2) datanode와 namenode의 실제 주소 (joshuaj/hadoop/hdfs)

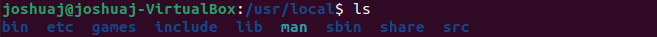

추가로 말씀하신 두번째 방법은 일단 예시에서 말씀해주신대로 해당 경로를 찾아가봤지만 (usr/local/)

hadoop 혹은 hadoop-3.2.3(현재 제 버전) 폴더를 찾을 수가 없어서 해보지 못했습니다 ㅜㅜ

2) 해당 경로의 파일들

추가로 hadoop namenode -format으로 네임노드 포맷을 다시 해봤지만 큰 변화는 없었습니다.. 하나하나 로그들을 봤는데 특별히 오류 내용은 찾을 수가 없어서 따로 캡쳐는 하지 않았습니다.

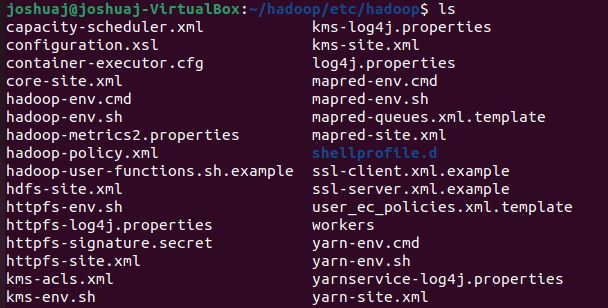

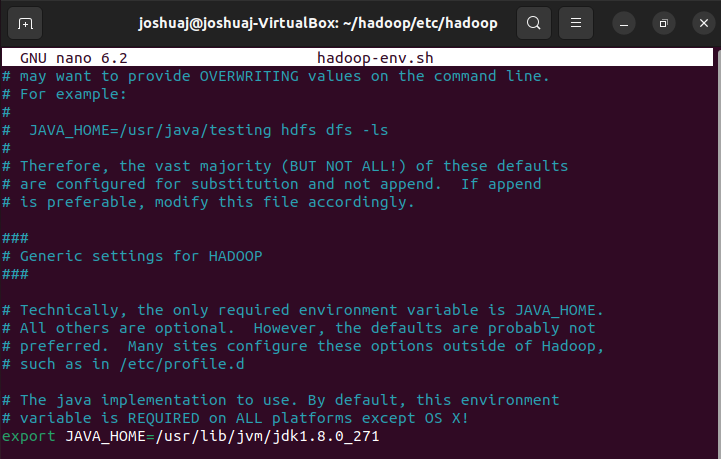

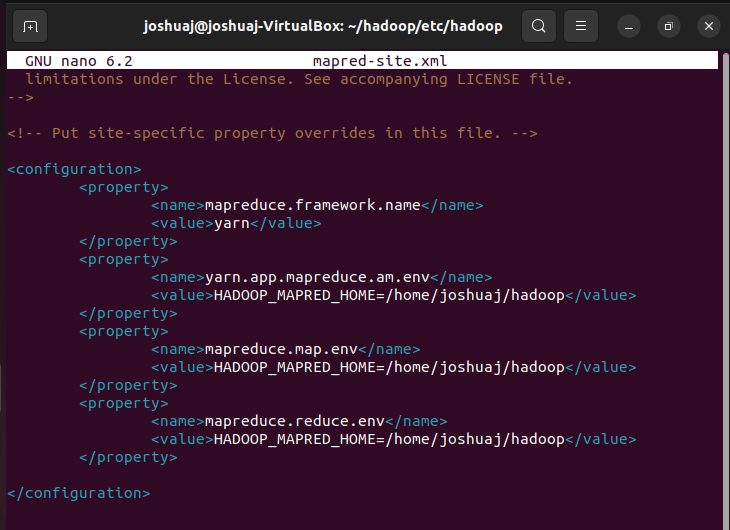

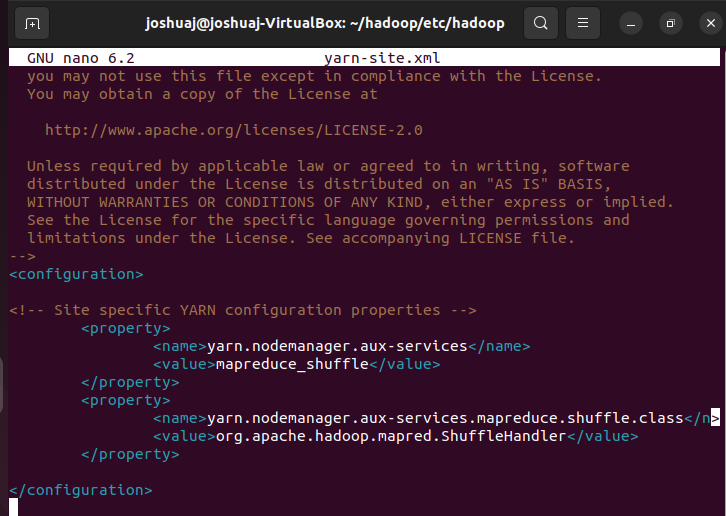

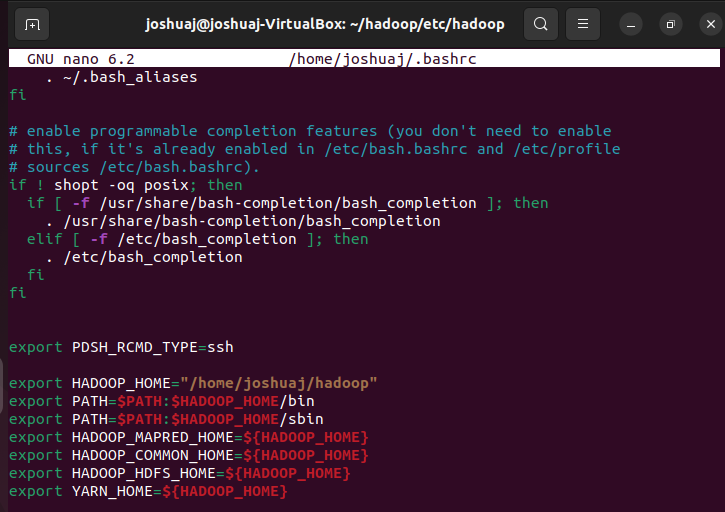

마지막으로 각종 환경 세팅 설정들 및 xml, sh 경로 첨부하겠습니다..!

3) 각종 xml, sh 파일 경로

5) mapred-site.xml

6) yarn-site.xml

7) .bashrc

긴 글 읽어주셔서 감사합니다!!

얼른 세팅 마무리 하고 본격적으로 학습하고 싶네요ㅜㅜ!!

0

Billy Lee

지식공유자2022.08.30

안녕하세요

재현님

저의 강의에 관심을 가져주셔서 감사합니다.

현재 스크립트 부분과 실제 HDFS 파일 경로에 일치하지 않거나 다른 에러가 있을 겁니다.

가령 포멧이 잘 안되었기도 합니다. (물론 포멧 과정을 잘 맞추었지만요).

첫째로 stop-all.sh 와 함께 데몬 서비스를 종료하신 뒤, 네임노드와 데이터노드 경로 곧 the value of property 파일 경로 (hdfs-site.xml)와 실제 hdfs (/home/joshuaj/hadoop/hdfs/datanode, namenode) 파일 경로가 일치하는지 확인하시길 바랍니다. mkdir 파일 명령어로 저장할 때 경로를 다시 한번 확인하신 뒤 데몬 서비스를 다시 가동하여 실행하시길 권고합니다. 일치하지 않으면

환경 세팅을 제대로 파일명 경로를 지정하세요.

둘째로 sudo rm -r /usr/local/hadoop 절대경로/hdfs/tmp 로 hdfs temp 파일을 삭제하시고

다시 지웠던 해당 hdfs 임시 파일 경로를 다시 mkdir 명령어를 실행시키세요.

예제 sudo rm -r /usr/local/hadoop-3.2.1/hdfs/tmp

sudo mkdir /usr/local/hadoop-3.2.1/hdfs/tmp

셋째로 hadoop namenode -format 로 네임노드 포멧을 다시 해보세요.

마지막으로 데몬 서비스를 다시 시작해보세요.

안되면 에러 메시지를 다시 한 번 보내주세요. 혹은 네 가지 환경 세팅 설정 파일들 캠쳐 그림 파일을 보내주시면 확인해보죠. 또한 각각 HDFS 파일 경로들을 하나 하나 캠쳐하여 보내주세요.

토론토에서 응원합니다.

빌리 올림

답변 3