월 19,800원

5개월 할부 시

중급자를 위해 준비한

[데이터 엔지니어링, 딥러닝 · 머신러닝] 강의입니다.

스파크(Spark) 머신러닝의 핵심 Framework에 대한 이해, 난이도 높은 실전 문제를 통한 SQL 기반의 데이터 가공, 업무 도메인 분석을 통한 데이터 분석과 최적화된 머신러닝 모델 구현 능력까지, 대용량 데이터 기반에서 머신러닝 전문가로 인정 받고 싶다면 이 강의와 함께 하십시요.

이런 걸

배워요!

데이터 분석 + 피처 엔지니어링 + ML 구현,

세 가지 역량을 한번에 잡아보세요.

Apache Spark와

머신러닝의 만남.

오픈 소스 대용량 분산 처리 솔루션의 최강자인 Apache Spark(아파치 스파크)와 Machine Learning이 만났습니다.

국내 많은 대기업과 금융기관에서 Apache Spark를 활용하여 대용량 데이터를 분석하고 머신 러닝 모델을 만들고 있습니다. Spark는 분산 데이터 처리 프레임을 기반으로 하고 있기 때문에 적게는 수 대부터 많게는 수십 대의 서버 위에서 용량을 확장해 가면서 대용량 데이터를 처리하고 ML 모델을 만들 수 있습니다. 때문에 한 대의 서버에서만 머신러닝 모델 구현이 가능한 사이킷런의 한계를 벗어날 수 있습니다.

데이터 가공/분석에도 능한

머신러닝 전문가로

성장시켜 드리겠습니다.

'스파크 머신러닝 완벽 가이드 - Part 1' 강의는 스파크(Spark)에서 머신러닝 모델을 구현하는 방법을 익히는 것을 넘어서 데이터 가공과 분석에도 능한 머신러닝 전문가로 여러분을 성장시켜 드릴것입니다.

진정한 머신러닝 전문가로 성장하기 위해서는 비단 ML 구현 능력 뿐만 아니라 업무 데이터를 어떻게 가공하고 조합하여 ML 모델을 만들어 내는 능력 역시 매우 중요합니다. 이를 위해 실무에서 대용량 데이터 처리에 가장 많이 사용되는 SQL을 활용하여 데이터를 가공하는 법과 업무 도메인 분석에 기반한 데이터 분석 기법을 실습을 통해서 익히시게 될 것입니다.

상세한 이론 설명 및 실습을 통해 데이터 가공/분석 및 ML 구현 역량을 키울 수 있도록 구성하였습니다.

상세한 이론 설명 및 실습을 통해 데이터 가공/분석 및 ML 구현 역량을 키울 수 있도록 구성하였습니다.

여러분이 직면할 문제를

해결해드립니다.

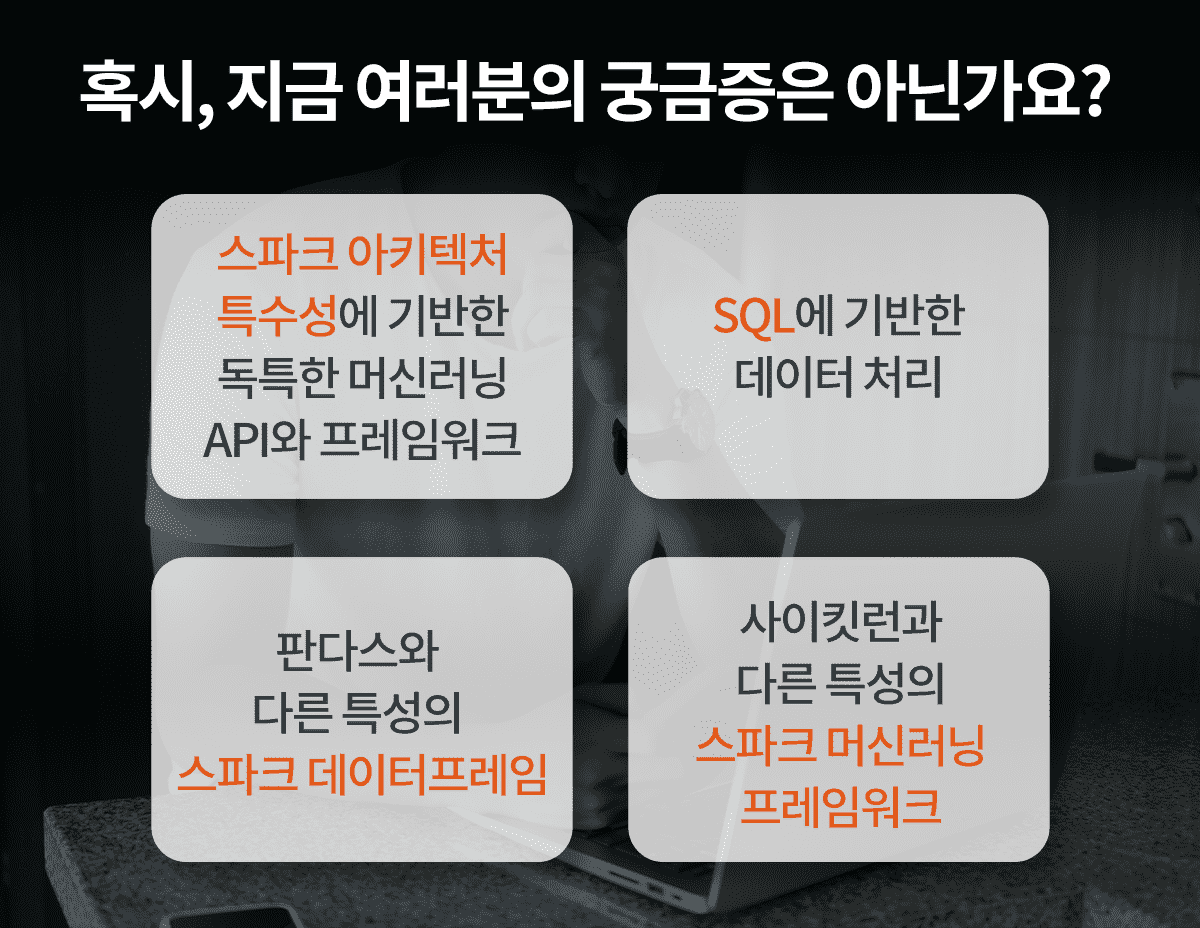

스파크 기반에서 머신러닝 모델을 구현하기는 쉽지 않습니다. 바로 스파크 아키텍처 특수성에 기반한 독특한 머신러닝 API와 프레임워크, 그리고 SQL에 기반한 데이터 처리 등 기존 데이터 사이언티스트나 머신 러닝 전문가들이 겪어보지 못한 많은 문제에 봉착하기 때문입니다.

본 강의, 스파크 머신러닝 완벽 가이드를 통해 여러분이 봉착한 문제를 해결하는 능력을 길러드리겠습니다.

'스파크 머신러닝 완벽 가이드 - Part 1' 강의 전반부는

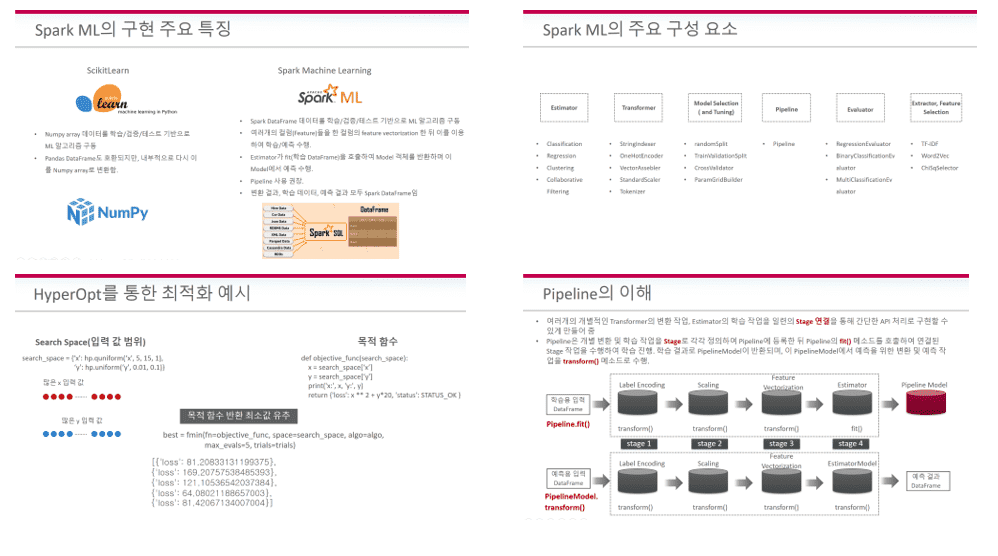

강의 전반부는 스파크 Machine Learning Framework을 구성하는 다양한 요소들인 DataFrame, SQL, Estimator, Transformer, Pipeline, Evaluator 등에 대해서 상세한 이론 설명과 풍부한 실습으로 구성되어 있습니다. 이를 통해 여러분은 Spark에서 ML 모델을 쉽고 빠르게 구현하실 수 있을 것입니다.

또한 스파크에서 XGBoost와 LightGB을 사용하는 방법, 베이지안 최적화에 기반한 HyperOpt를 이용하여 하이퍼 파라미터를 튜닝하는 방법에 대해서 자세히 설명 드리겠습니다.

'스파크 머신러닝 완벽 가이드 - Part 1' 강의 후반부는

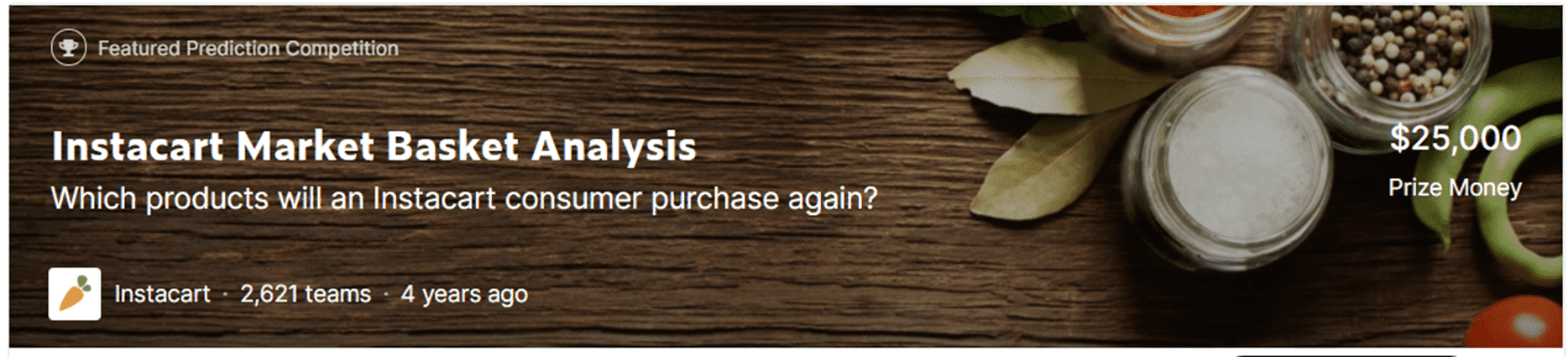

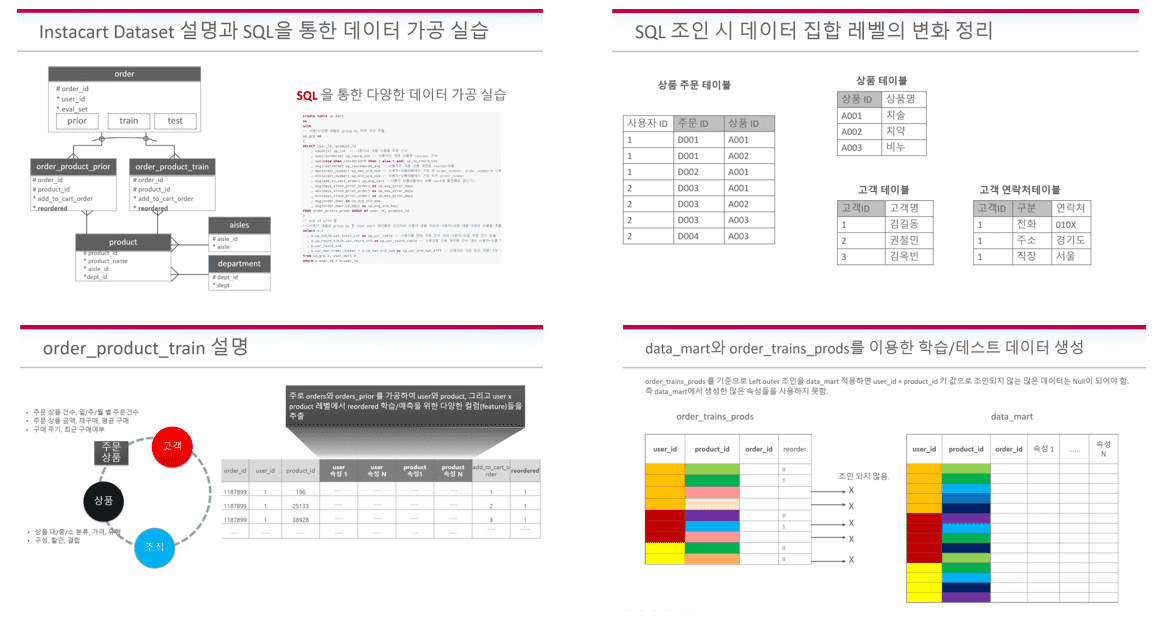

강의 후반부는 캐글의 Instacart Market Basket Analysis 경연 대회 실습을 통해서 여러분의 실전 데이터 가공/분석 능력과 머신러닝 모델 구현 능력을 동시에 향상 시켜 드릴 것입니다. 캐글 Instacart 경연대회는 난이도 높은 경연이며, 특히 데이터 세트가 전자 상거래의 주문 처리 테이블들(상품, 주문, 주문 상품)로 구성되어 있습니다.

해당 데이터 세트를 통해 SQL 기반에서 업무 데이터를 어떻게 가공하고 분석하며 Feature Engineering을 수행하는지, 또한 업무에서 분석 도메인을 어떻게 도출하는지, 그리고 이렇게 도출된 Feature 들을 기반으로 어떻게 모델을 생성하는 지에 대해서 상세하게 배우시게 될 것 입니다.

이번에 출시하는 '스파크 머신러닝 완벽 가이드' 강의는 Part 1입니다. Part 2 강의는 추후에 출시 예정이며, 텍스트 분석, 추천(Recommendation), 그리고 TimeSeries 분석을 다룰 예정입니다.

💻 수강 전 확인해주세요!

- 본 강의의 실습 코드는 모두 Python 기반으로 되어 있습니다. Scala는 다루지 않으니 강의 선택 전 참조 부탁드립니다.

실습 환경을

확인해주세요.

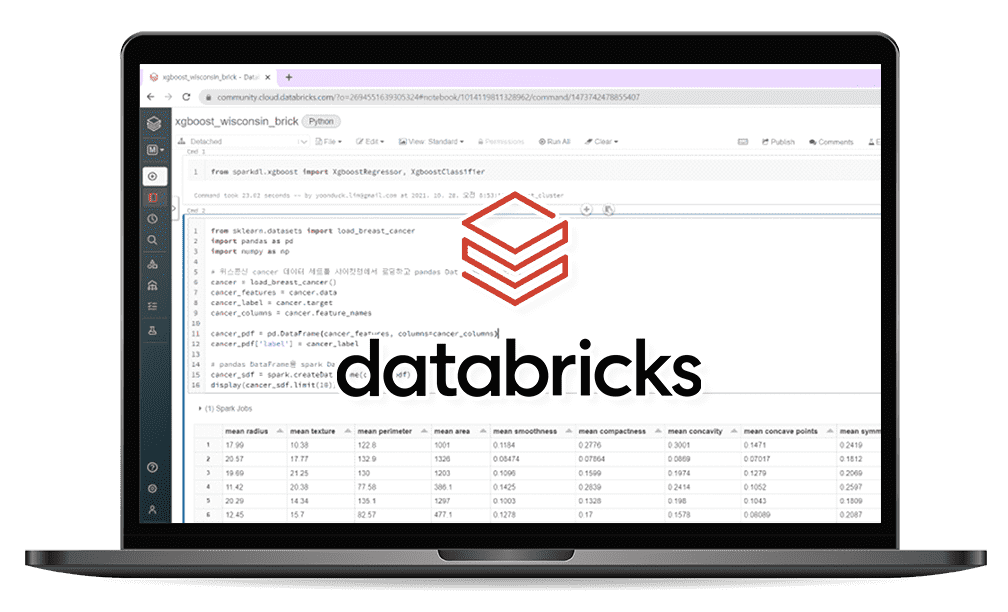

실습은 Databricks(데이터브릭스)를 이용합니다. Databricks는 Spark를 설치하지 않고도 클라우드 상에서 Spark 기반의 애플리케이션을 만들 수 있는 노트북 환경을 제공합니다.

Databricks는 Community 버전으로 공식적으로 14일간 무료 사용이 가능합니다.

그리고 섹션 0의 'Databricks에서 Spark 클러스터 관리하기 및 가입 2주 후에도 Databricks 사용하기' 강의 영상에서 14일 이후에도 무료로 계속 사용할 수 있는 방법에 대해서 말씀드리고 있으니 꼬~옥 해당 영상을 확인 부탁드립니다(Databricks Community 버전에 대한 설명은 링크를 참조해 주십시오).

강의 실습 코드와 강의 설명 자료는 '실습코드와 설명자료 다운로드 받기'에서 다운로드 받으실 수 있습니다.

선수 지식이

필요한 강의입니다.

본 강의는 수강생 분들이 파이썬 머신러닝 완벽 가이드의 5장(회귀) 또는 이에 준하는 지식을 가지고 있는 것으로, 또한 SQL에 대한 매우 기본적인 부분은 아시는 것으로 간주하고 구성되었으니 강의 선택시 위 사항 참조 부탁드립니다.

Spark는 기본적인 부분을 아시면 좋지만, 몰라도 강의를 따라가시는 데 문제가 없으실 것입니다.

지식공유자의 인터뷰가 궁금하다면? (클릭)

이런 분들께 추천드려요!

학습 대상은

누구일까요?

선수 지식,

필요할까요?

권 철민 입니다.

(전) 엔코아 컨설팅

(전) 한국 오라클

AI 프리랜서 컨설턴트

파이썬 머신러닝 완벽 가이드 저자