AWS(Amazon Web Service) 실전을 위한 강의

AWS 입문자, 중/상급자를 위한 강의를 다 수강했음에도 아직 뭔가 부족하다고 느끼시나요? AWS 실전을 위한 강의가 바로 그런 분들을 위한 강의입니다.

중급자를 위해 준비한

[데브옵스 · 인프라, 클라우드] 강의입니다.

이런 걸 배울 수 있어요

Apache Airflow

AWS Batch

AWS ECR

AWS Athena

AWS Glue

실전 중심! AWS 응용의 완결판.

현업에서 AWS를 어떻게 사용하는지 고민이신가요?

🤔 AWS 입문자/중상급자 강의를 마쳤지만 아직 1%가 부족한 것 같아요.

😎 AWS 쇼케이스를 통해 회사에서 승진을 노리고 있어요.

😀 AWS에서 제공하는 리소스로 다양한 파이프라인을 구축하고 싶어요.

🥺 AWS의 다양한 용례를 체험해보고 싶어요.

🤓 클라우드의 세계로 더 깊이 빠지고 싶어요.

👉 AWS 시리즈의 종착역! 여러분의 고민에 해결책을 제시해드립니다.

AWS 실전편을 위한 강의는 우선 AWS 입문자, 중/상급자를 위한 강의를 사랑해주시는 여러분들이 계시지 않았다면 생길 수 없었습니다. 여러분들의 열렬한 응원과 지지 덕택에 이 강의가 생겼다고 해도 과언이 아닙니다.

AWS를 실전에서 빠르게 응용하고 싶은 분들을 위한 강의입니다.

본 강의는 현업에서 엔지니어들이 어떻게 AWS를 사용해서 ETL 파이프라인 구축, 도커 컨테이너, Airflow 스케쥴러 구축을 하는지에 대한 간접적인 경험을 하실 수 있도록 구성되어 있습니다. 제목에서 아실 수 있듯 개념 정리는 최소화하고, 실습 위주로 진행합니다.

하나의 섹션 당 수업 길이는 짧게는 30분, 길게는 1시간 정도 소요됩니다. 군더더기는 모두 빼고 중요한 내용만 담아 속성으로 여러분들에게 전달하기 위함입니다.

AWS를 빨리 응용해서 사용하고 싶으신 분, AWS 입문자를 위한 강의를 듣고 더 깊게 클라우드를 파헤쳐보고 싶은 분들께 적극 추천드립니다.

실무에서 발생할 수 있는 예외 상황에 대한 해결책을 제시합니다.

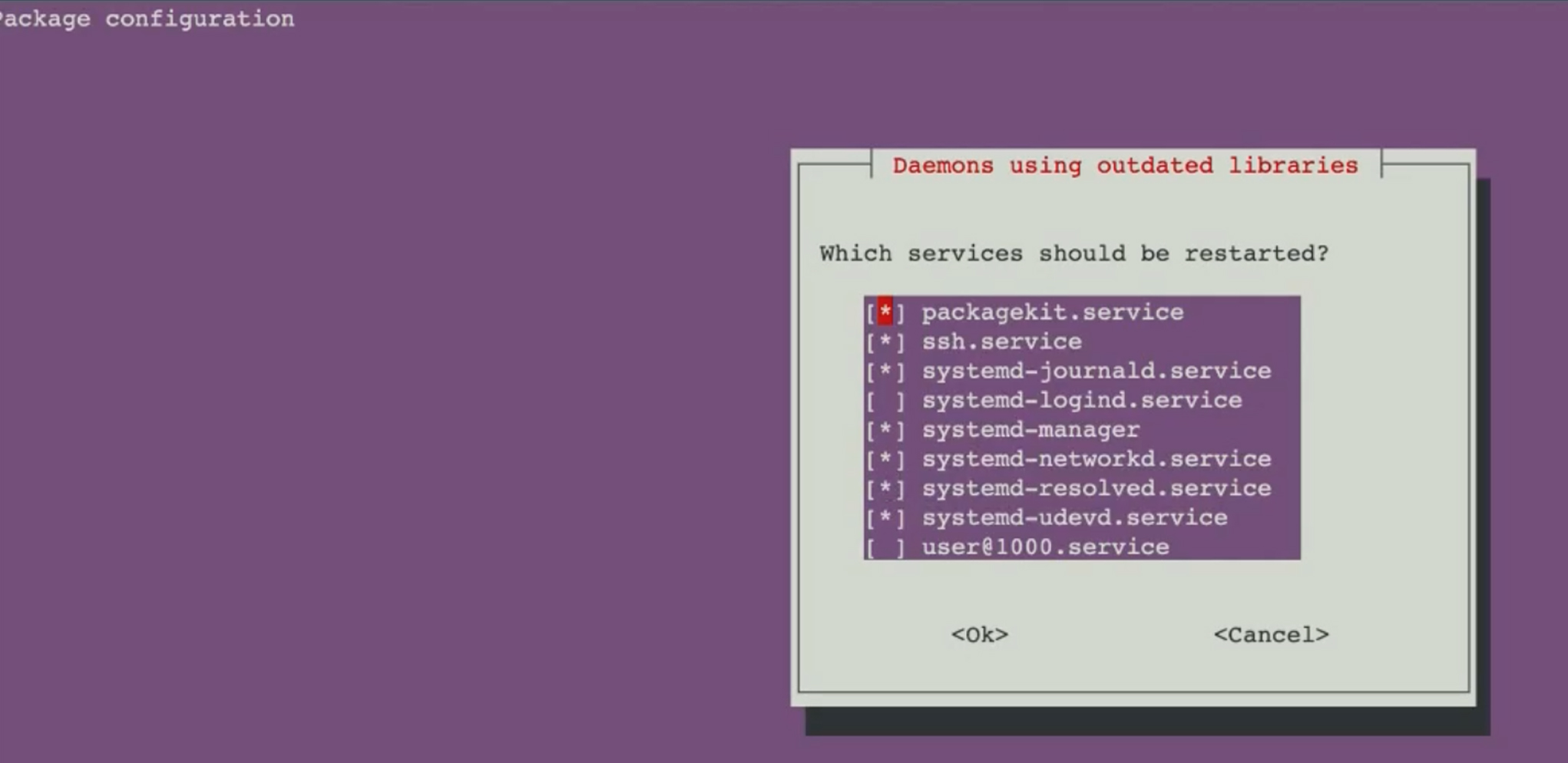

강의 제작 과정에 있어 신경을 많이 쓴 부분 중 하나는 트러블슈팅(Troubleshooting) 섹션입니다. 제가 AWS를 돌리는 환경(운영체제, 환경설정 등)은 여러분들과 항상 같지 않습니다. 때문에 저는 잘 돌아가더라도 여러분은 에러가 뜨는 부분이 있을 거라 생각합니다. 모든 에러를 다 설명드리는 건 불가능하지만, 종종 발생하는 에러를 모아 어떻게 여러분들이 직접 문제 해결을 할 수 있을지에 대한 고민을 많이 해봤습니다. 그래서 해당 섹션을 만들게 되었습니다.

강의를 만들때 '나는 잘 돌아가는데 다른 분들은 이런 에러가 뜨지 않을까?' 라는 생각을 가지며 그때그때 가능성 높은 예외 상황들을 정리하고 그에 대한 해결책을 여러분들께 제시합니다.

그래서, 학습 후에는...

- ✅ AWS를 자유자재로 사용할 수 있습니다.

- ✅ 언제 어디서 어떤 리소스를 어떻게 사용할 수 있는지에 대한 감각이 생깁니다.

- ✅ 또한 상황에 맞게 장단점을 따질 수 있는 능력도 생깁니다.

- ✅ 클라우드에 대한 이해력이 높아집니다.

Simon Kim이 만든 AWS 시리즈의 종착역

본 강의는 실습 90%, 이론 10%로 구성되어 있습니다. 따라서 선수지식은 AWS 입문자를 위한 강의입니다. 중/상급자를 위한 강의는 선택 사항이며, 실전편을 위한 강의와 함께 시청하셔도 무리가 없습니다.

AWS 실전편을 위한 강의는 AWS 시리즈의 종착역입니다. 실전편을 완강하셨다고 해서 AWS의 모든 것을 다 이해한다고 할 순 없습니다. 그러나 여러분들이 앞으로 AWS를 사용하고 새로운 기술을 배우실 때 큰 도움이 될 거라 확신합니다.

시리즈 선수 과정을 확인해보세요.

학습 내용 미리보기

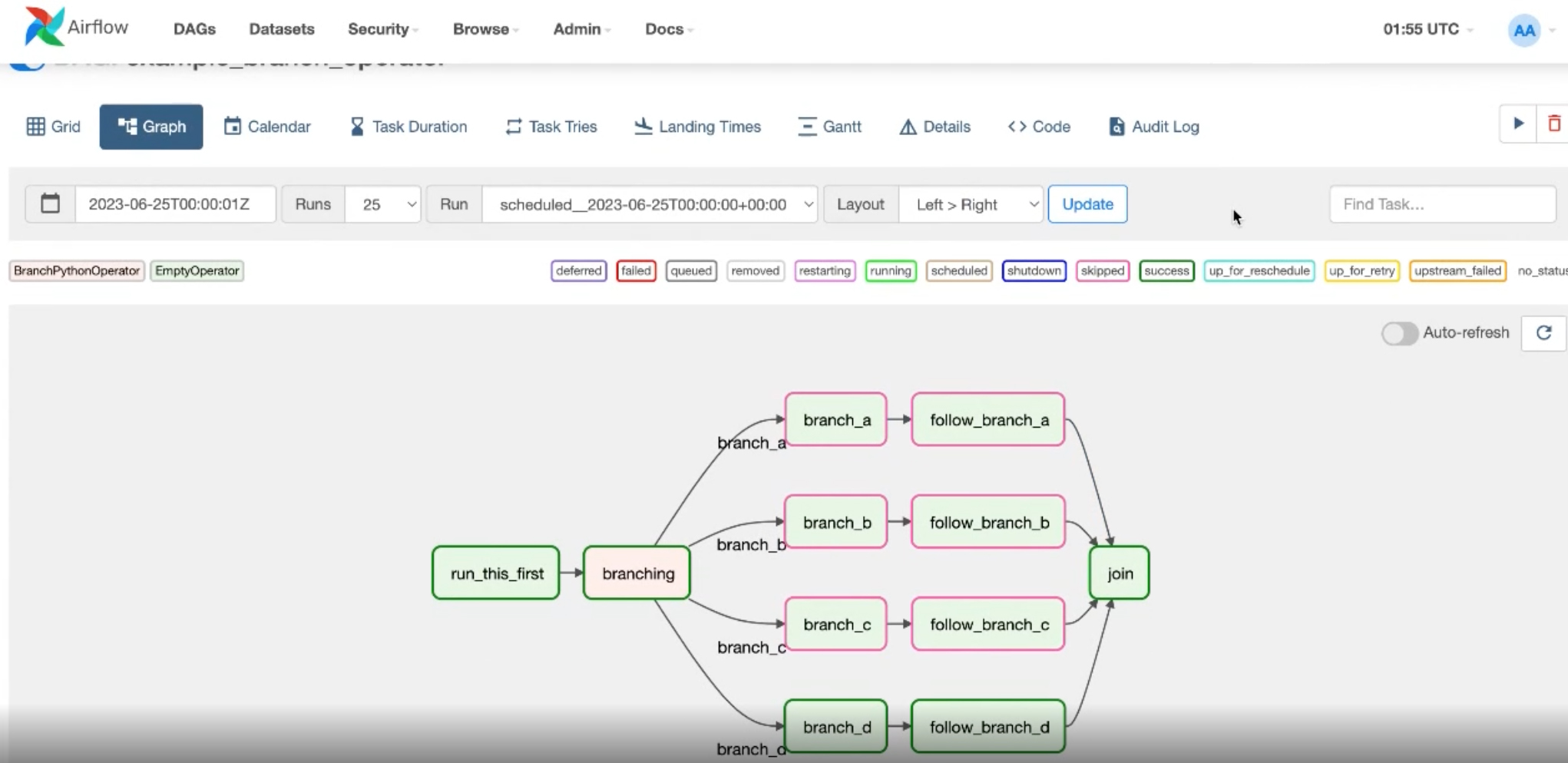

1. AWS와 Airflow의 만남

Airflow를 AWS에서 돌릴 수 있냐구요? 그렇습니다. AWS와 Airflow를 함께 사용해서 AWS 리소스의 도움으로 더욱 다양한 파이프라인을 구축할 수 있습니다.

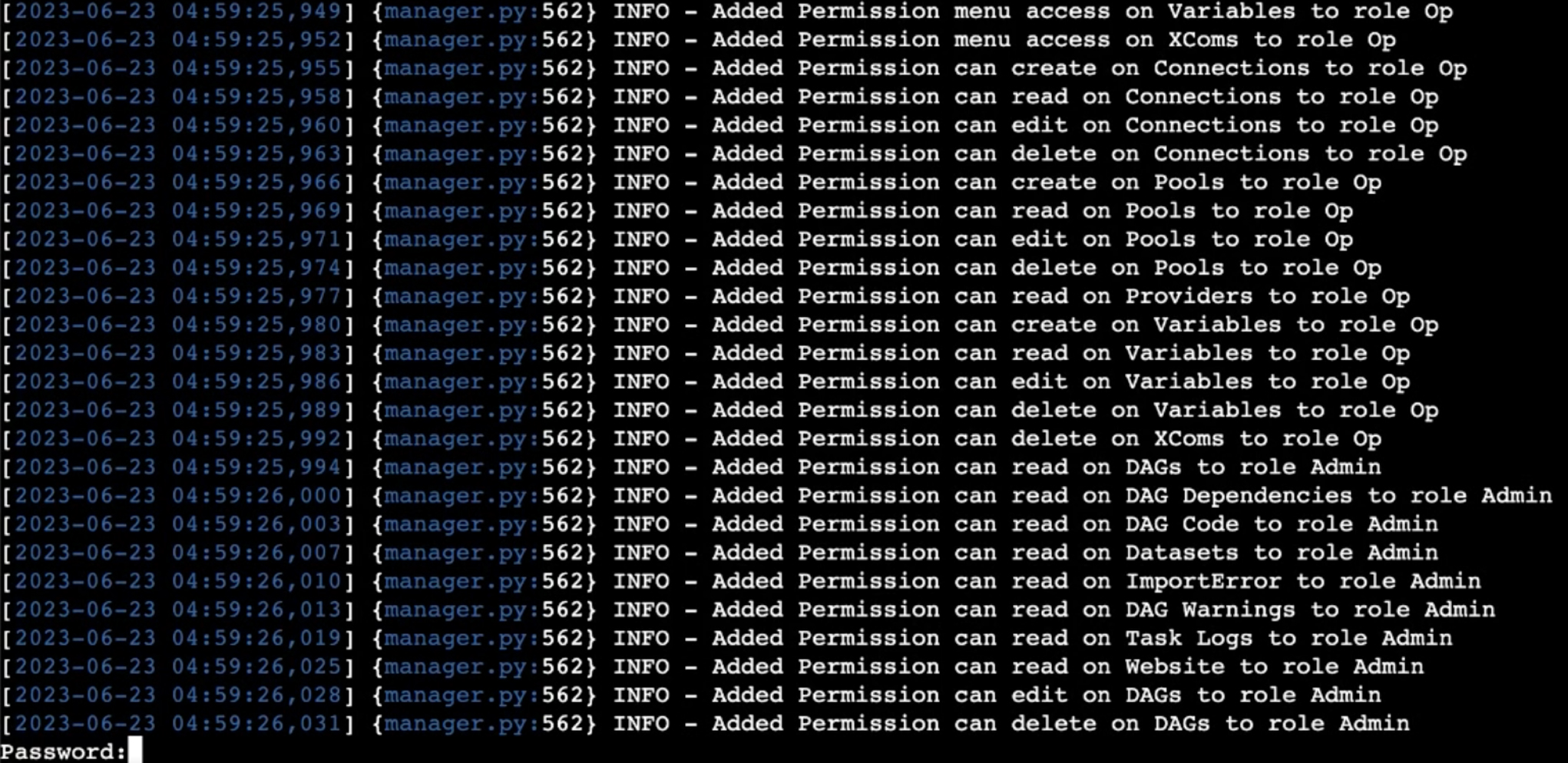

(1) 인스턴스 생성 후 Airflow를 돌리기 위해 필요한 패키지를 설치합니다.

(2) Airflow 데이터베이스를 만들고 사용자 생성을 합니다.

(3) Airflow DAG를 실행합니다.

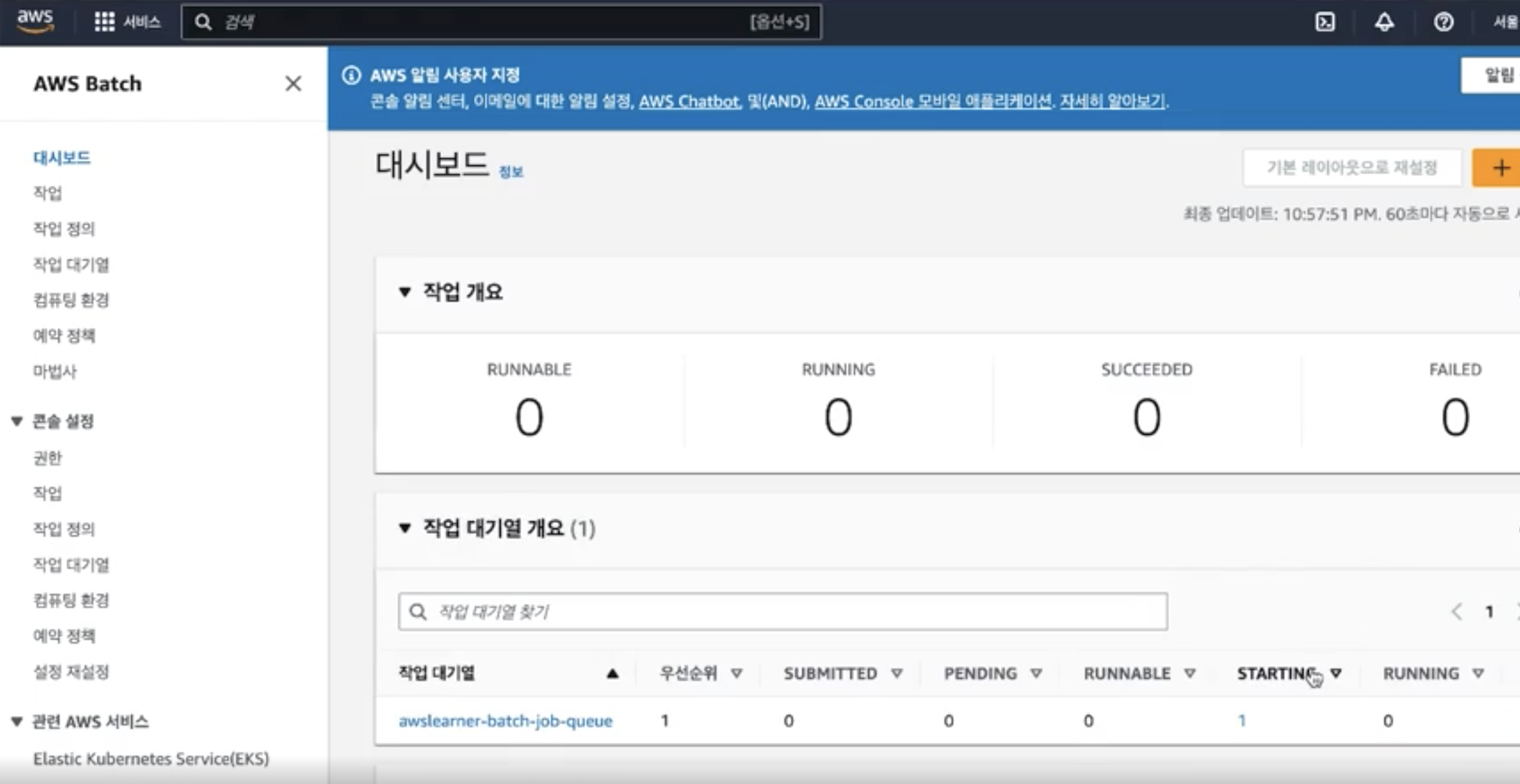

2. AWS Batch & ECR

배치 잡과 큐를 생성하고 ECR에 푸시한 이미지를 실행하는 실습을 합니다. AWS Batch는 입문자, 중/상급자 강의에서 다루지 않았기 때문에 이번 섹션에서 짧게 소개합니다.

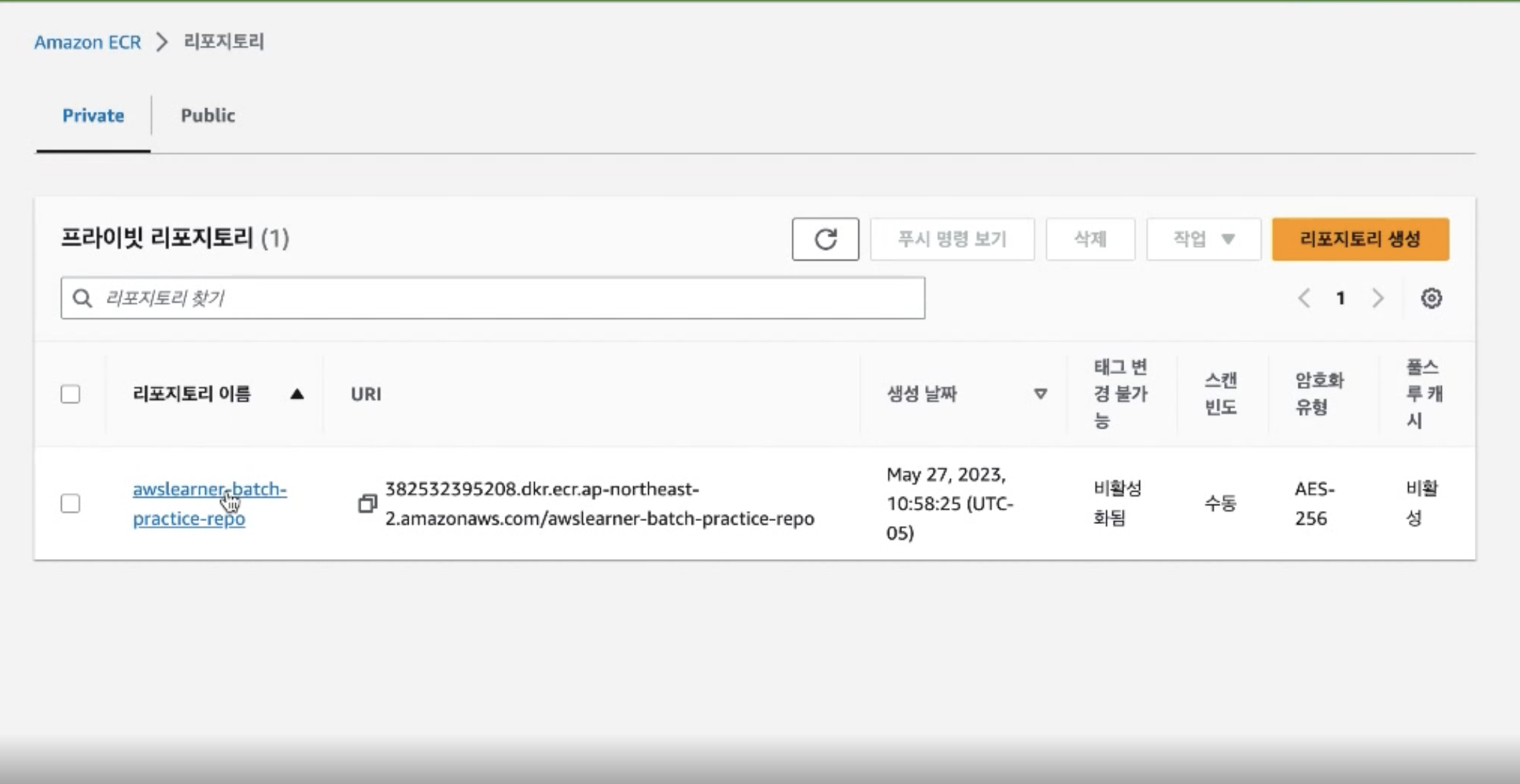

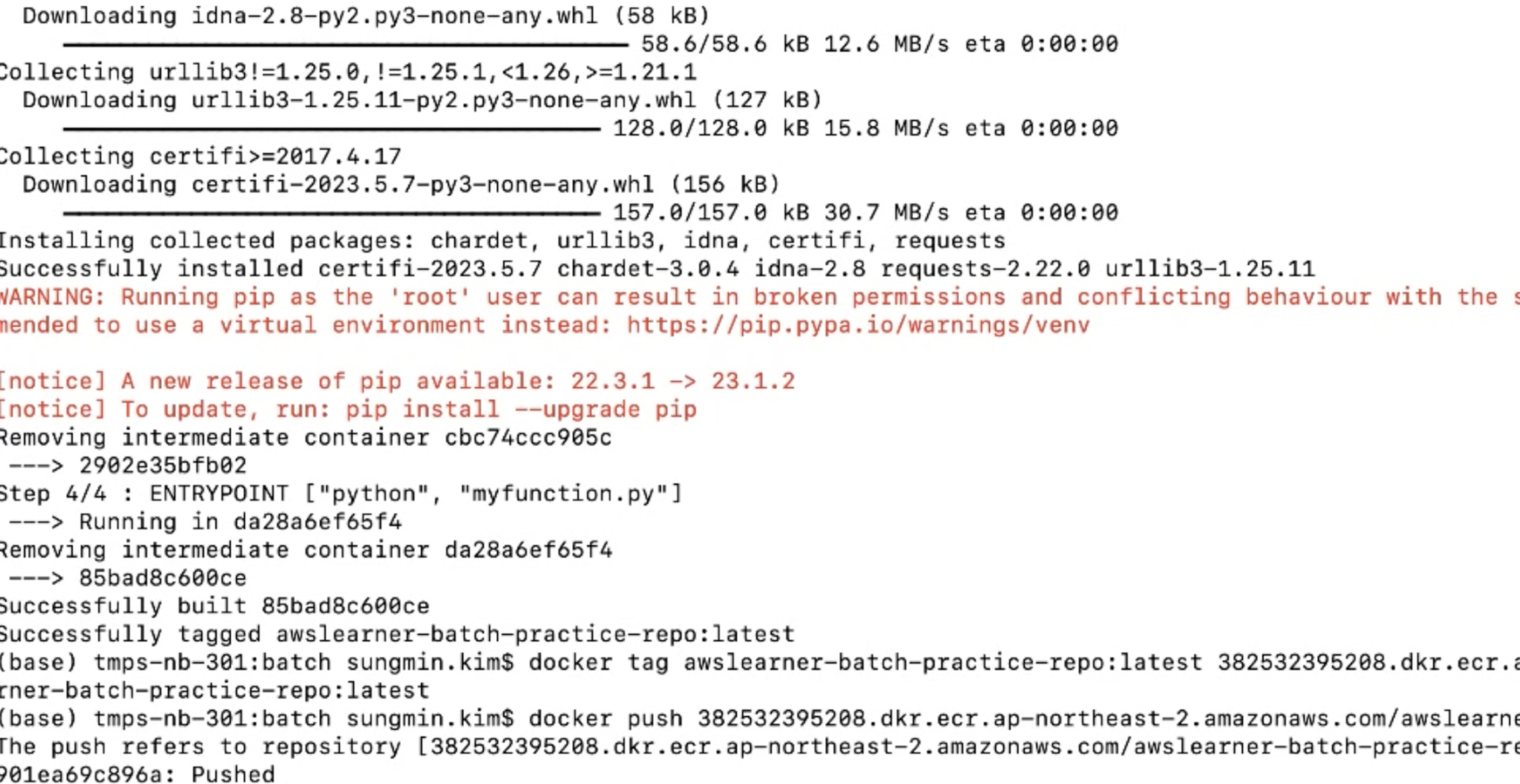

(1) 도커 이미지를 보관할 ECR 리포지토리를 만듭니다.

(2) 도커 이미지를 생성하고 ECR 리포에 이미지를 푸시합니다.

(3) 배치 잡(Job)과 큐(Queue)를 생성하고 잡을 실행합니다.

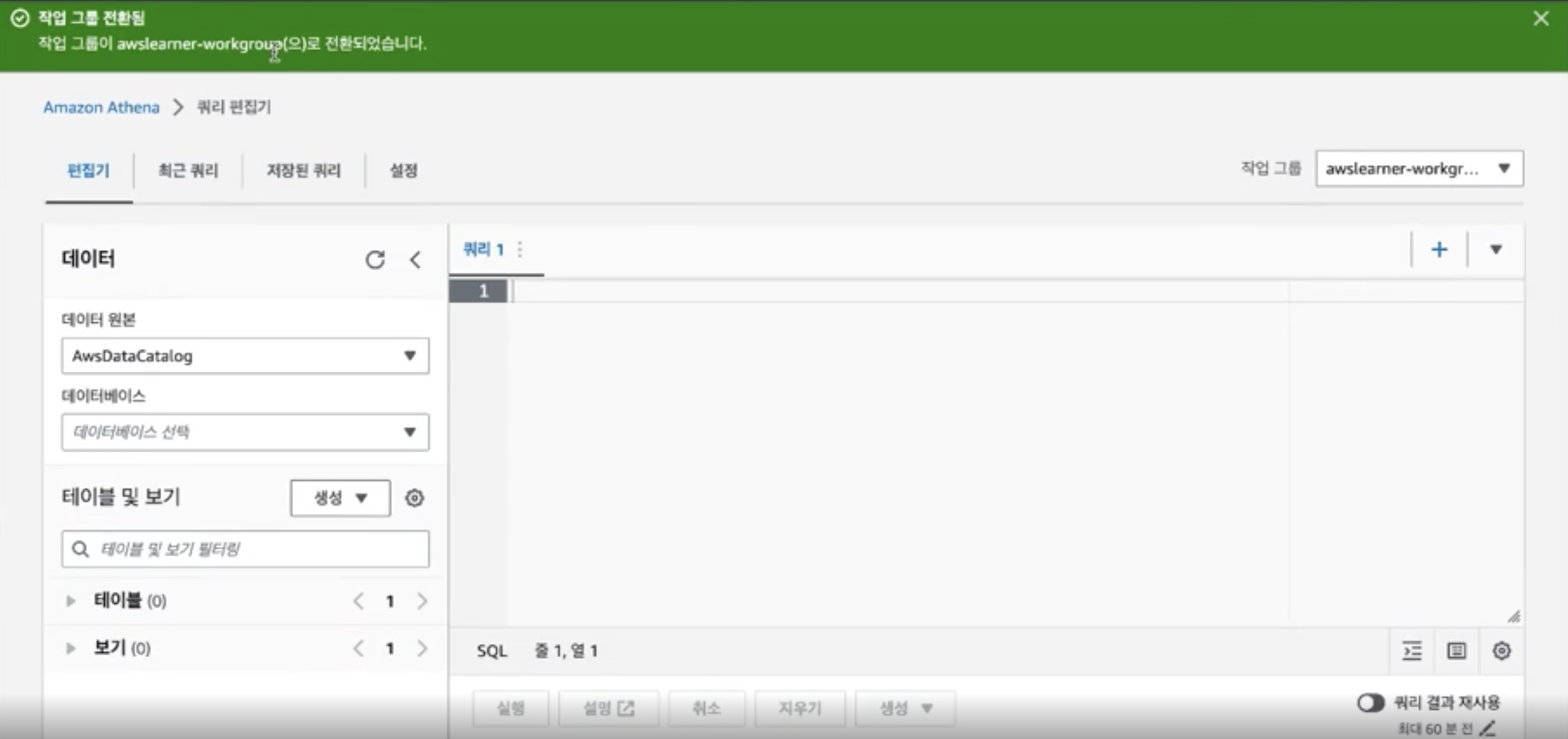

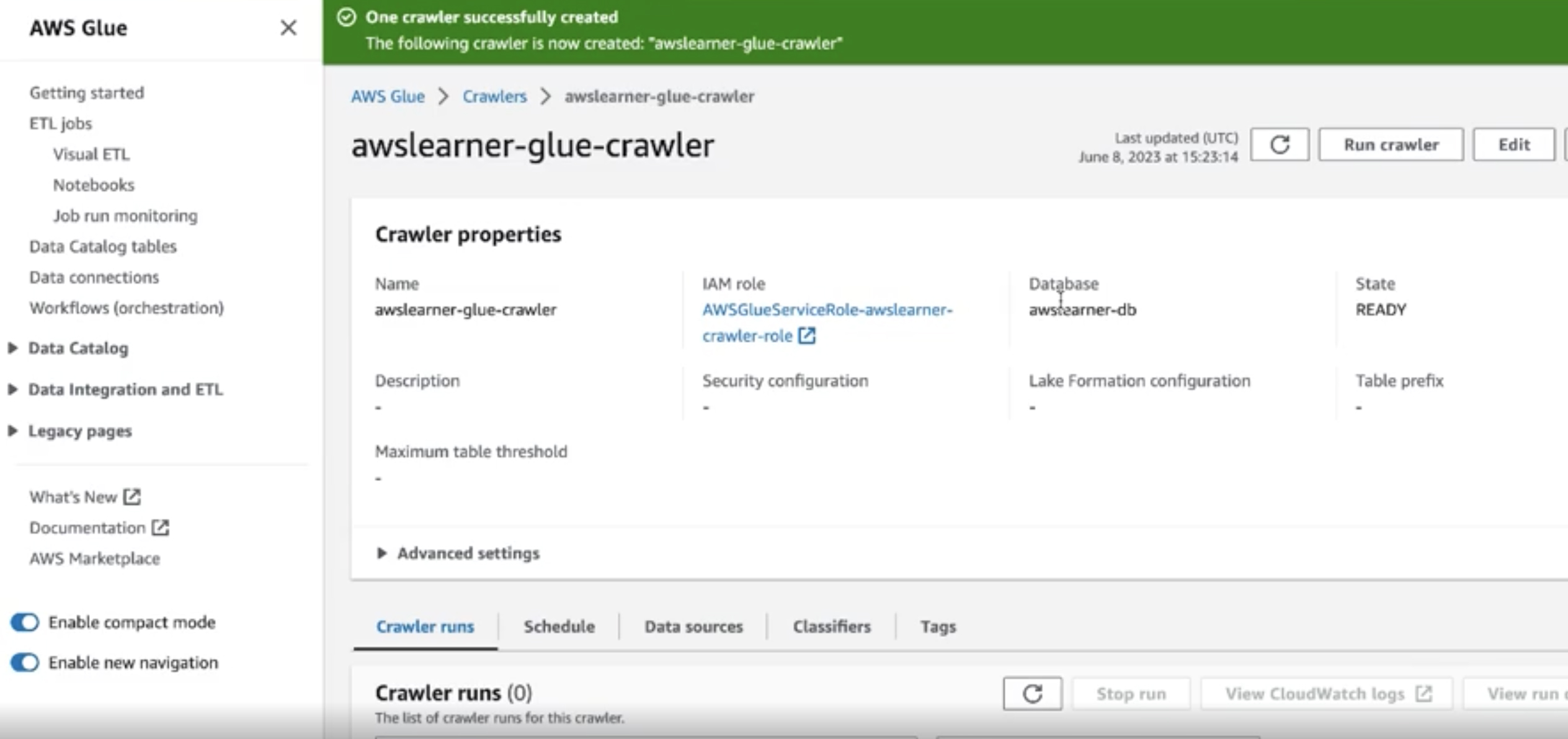

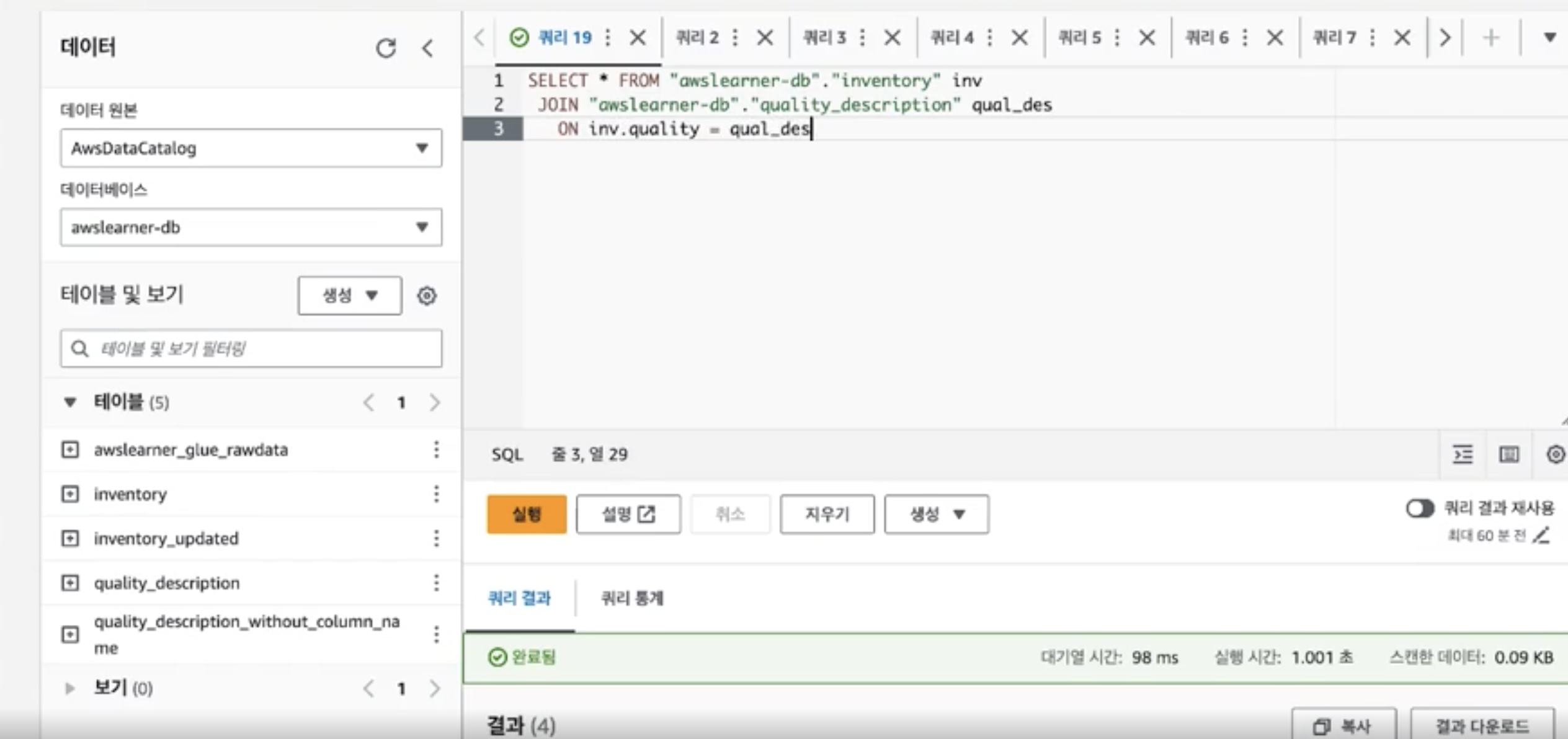

3. ETL 파이프라인

AWS 리소스(S3, Glue, Athena)를 사용하여 간단한 ETL 파이프라인을 구축해봅니다.

(1) 로우데이터(raw data)가 들어갈 버킷을 만들고 데이터를 보관할 Athena 데이터베이스를 생성합니다.

(2) 글루 크롤러(Glue Crawler)를 만들어 로우데이터를 추출합니다.

(3) Athena에서 데이터 검증과정을 거칩니다.

Q&A 💬

Q. 이 강의를 들어야 하는 이유는 무엇인가요?

이제는 IT산업 뿐만 아니라 다양한 곳에서 클라우드가 언급되고 사용됩니다. 클라우드 인프라는 이제 실생활에서 떼려야 뗄 수 없습니다. 빅데이터 시대에 살고 있는 우리들은 매일 수많은 데이터를 생산하고 처리하며 분석합니다. 이는 결코 사람이 모두 해낼 수 없습니다. 클라우드의 도움을 받아야 합니다. AWS가 바로 그 역할을 담당합니다.

AWS 실전을 위한 강의는 실제 현업에서 종종 사용되는 아키텍쳐들을 몇가지 소개하며 여러분들이 따라서 실습을 할 수 있는 강의로 구성되어 있습니다. 실습을 따라하시면서 왜 여기서 이런 리소스가 사용되며 더 나은 방법은 없는지 스스로에게 질문을 던지면서 강의를 따라오시는 것을 권장합니다. 클라우드에는 정답이 없습니다. 다만 더 나은 방법이 존재할 뿐입니다. 주어진 환경에서 여러분들께서 더 나은 방법을 탐구하고 찾아내셔야 합니다. 본 강의는 그 방법을 도와드릴 것입니다.

Q. 비전공자도 들을 수 있나요?

물론입니다. 컴퓨터 전공자가 아니어도 AWS 클라우드 경험이 있으시다면 충분히 수강하실 수 있습니다.

수강 전 확인해주세요 📢

실습을 위한 OS 및 도구

- Windows/macOS에서 수강하실 수 있습니다.

- AWS 계정 생성을 마치신 후 강의를 수강하시는 것을 권장합니다.

학습 자료

- 실습 시 사용되는 명령어를 정리한 텍스트 파일 및 파이썬 코드 파일 등이 학습 자료로 제공됩니다.

- 수업 전후 읽어보면 유용한 링크들은 강의 게시판에서 확인하실 수 있습니다.

💡 선수 지식 및 유의사항 안내

- 본 강의는 실전을 위한 강의로, AWS 입문자 분께는 적합하지 않습니다. AWS 및 클라우드 경험이 전혀 없으시다면 시리즈 AWS 입문자를 위한 강의를 먼저 학습하시는 것을 적극 권장합니다. (AWS 중/상급자 강의와 병행해서 수강하시는 것은 괜찮습니다.)

- 실습을 따라할 때 필요한 파일은 수업 첨부파일을 다운로드받아 사용하실 수 있습니다.

- 강의 내용을 퍼가실 경우 출처를 밝혀주시면 감사하겠습니다.

이런 분들께

추천드려요!

학습 대상은

누구일까요?

AWS 입문자, 중/상급자 강의를 수료하신 분

AWS 다양한 리소스를 사용해 파이프라인 구축을 하고 싶으신 분

AWS의 다양한 사용 용례를 경험해 보고 싶으신 분

선수 지식,

필요할까요?

Python

클라우드 기본 지식

AWS

5,838

명

수강생

276

개

수강평

154

개

답변

4.7

점

강의 평점

5

개

강의

안녕하세요. 저는 학부와 석사를 미국에서 나왔으며 전공은 각각 Computer Science, Data Science를 공부하였습니다. 현재 저는 Healthcare쪽 회사의 데이터 엔지니어로 일하고 있습니다. 매일 제가 하는 일을 간단하게 말씀드리자면; AWS와 Airflow를 사용하여 매일 데이터를 불러와 ETL과정을 거치며, 데이터가 잘 들어오는지 모니터링하면서 문제점 혹은 개선의 여지가 필요한 경우 프로그램을 구현하는 일을 하고 있습니다. 데이터 모니터링은 주로 AWS의 CloudWatch와 Splunk라는 프로그램을 사용하고 있습니다.현재 제가 회사에서 사용하고 있는 기술들은 Python, AWS, SQL 등등이며 최근에는 GCP로 Migration하고 있는 추이이며 AWS와 GCP를 동시에 접하고 있습니다.

2022년에는 회사에서 거의 80%의 데이터 및 파이프라인이 GCP로 Migration을 마쳤으며 Bigquery & GCS & GKE쪽을 심오하게 다루고 있습니다. 물론 Docker Container & Terraform사용으로 전반적인 IaC 작업도 병행해서 진행하고 있습니다.

데이터 엔지니어로 일하면서 가장 크게 느낀점은 다음과 같습니다. 매일 새로운 기술들의 등장으로 인해 지금 내가 사용하고 있는 기술들이 과연 obsolete해질까? 그렇다면 그 이유는 무엇인가? 정말 그 기술이 이걸로 대처될 수 있는가? 단점은 없는 것인가? 그렇습니다. 저 모든 질문들에 대한 답변을 찾는것은 매우 힘들어 보입니다. 그러나 그 과정을 겪으면서 한가지 공통점이 보였습니다. 깊게 들어가보면 거의 대동소이 하다는 것입니다. 다시 말해 하나를 제대로 파헤친다면 다른 기술을 배우는 것은 많이 용이해진다는 것이죠. 저는 이런 메카니즘을 강의에서도 종종 언급을 하고 싶습니다. 여러분들과 함께 제가 현재 가지고 있는 모든 지식들을 공유하고 싶습니다. 여러분들의 길잡이가 될 수 있도록 최선을 다하겠습니다.

저 사이먼킴은 여러분들께 재미있고 이해하기 쉬운 강의를 선보일꺼에요. 여러분들과 끊임없이 소통하면서 더 나은 사람이 될 것을 약속드리구요. 여러분들의 실력이 향상되는것을 지켜보는 것은 저의 큰 행복입니다.

집필저서: 업무에 바로 쓰는 AWS 입문

커리큘럼

전체

17개 ∙ (1시간 42분)

해당 강의에서 제공:

환영합니다

04:24

EC2 인스턴스 생성하기

03:55

Packages 설치하기

10:06

환경변수 업데이트하기

07:04

사용자 생성하기

02:52

Airflow 실행하기

05:43

AWS Batch

03:38

실습 코드 Walkthrough

04:06

ECR 리포지토리 생성하기

03:28

도커 이미지 생성하기

05:28

Job 생성하기

06:54